基于BERT和方面特征定位模型的方面级情感分析方法及模型.pdf

一条****涛k

亲,该文档总共28页,到这已经超出免费预览范围,如果喜欢就直接下载吧~

相关资料

基于BERT和方面特征定位模型的方面级情感分析方法及模型.pdf

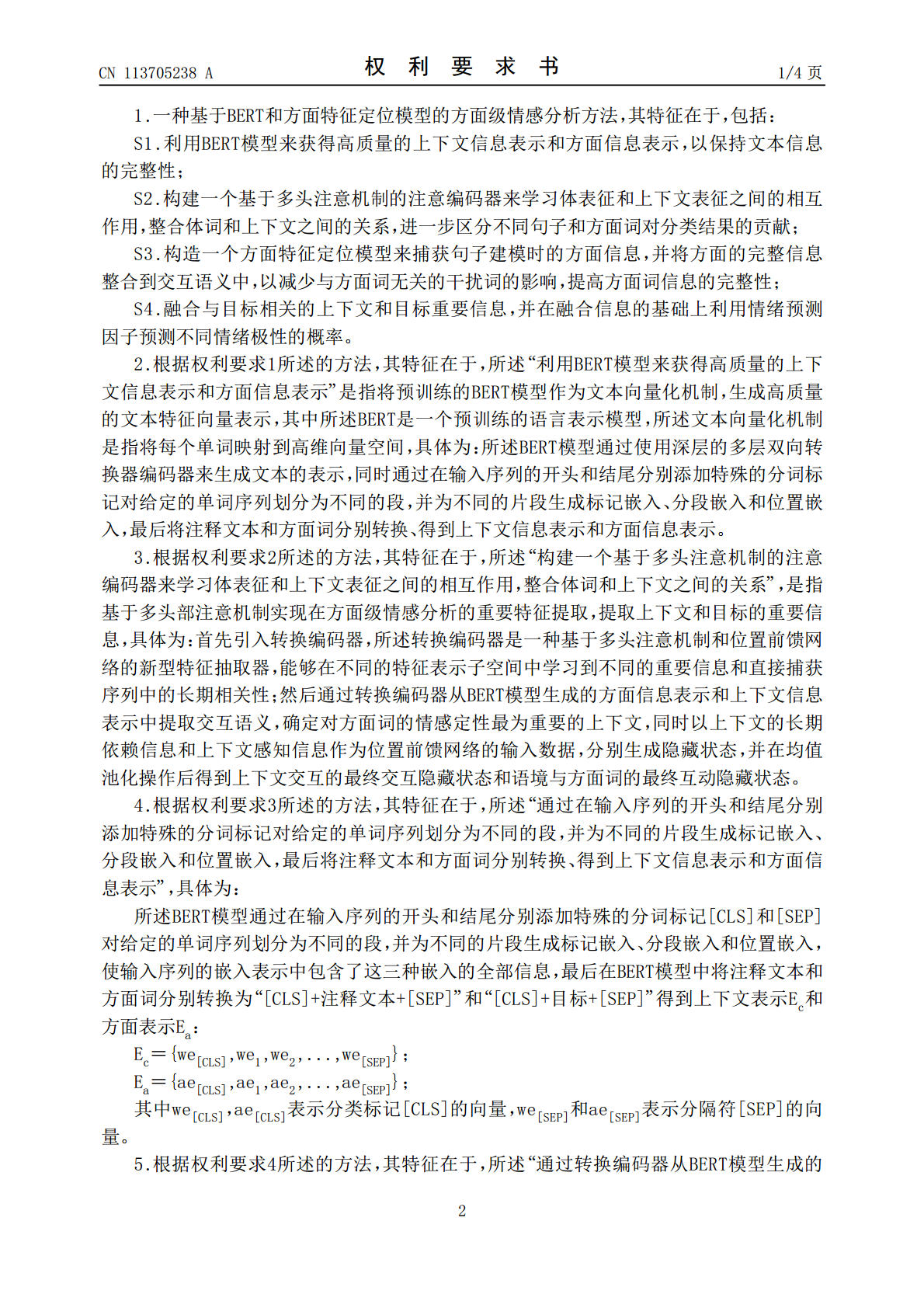

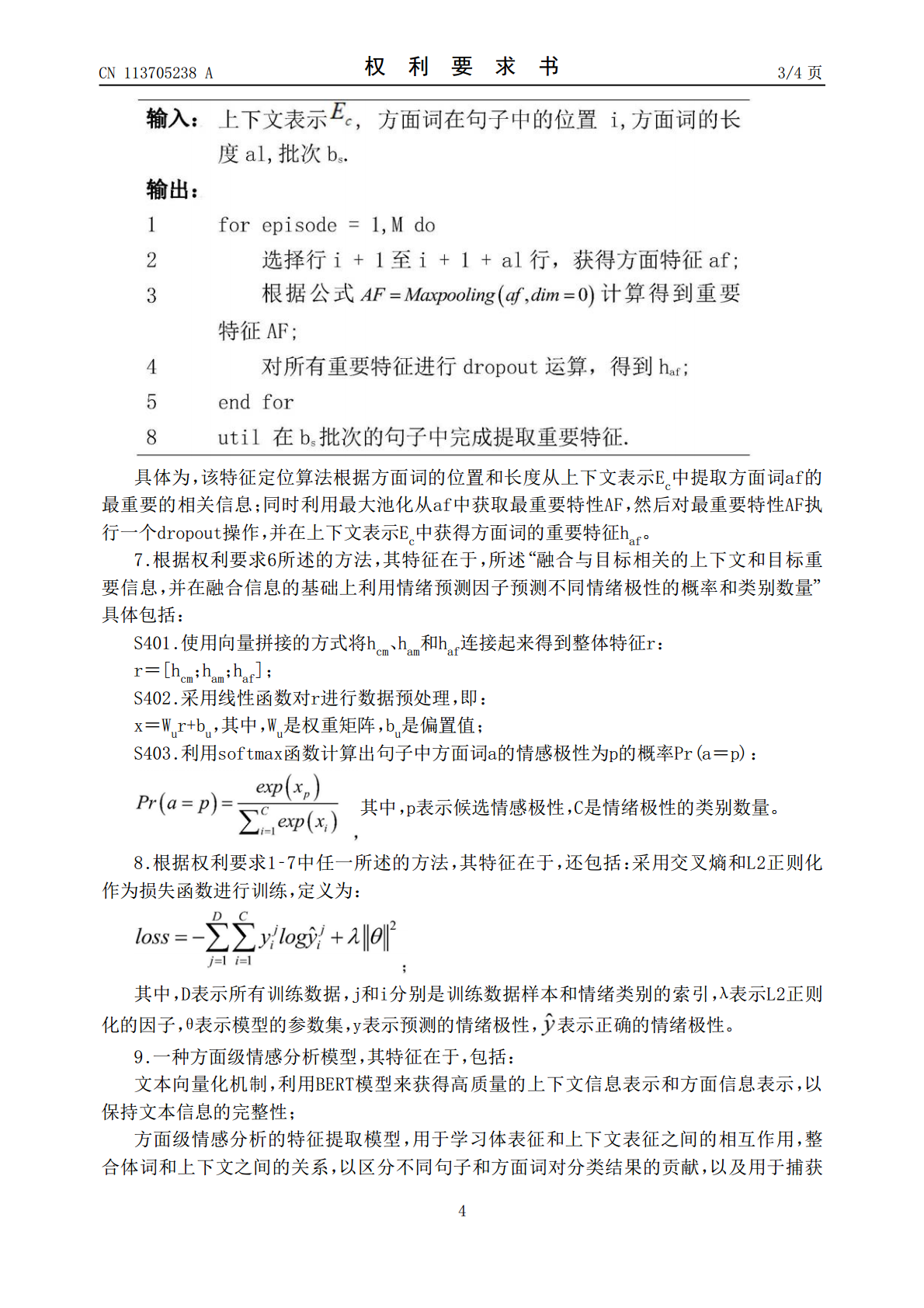

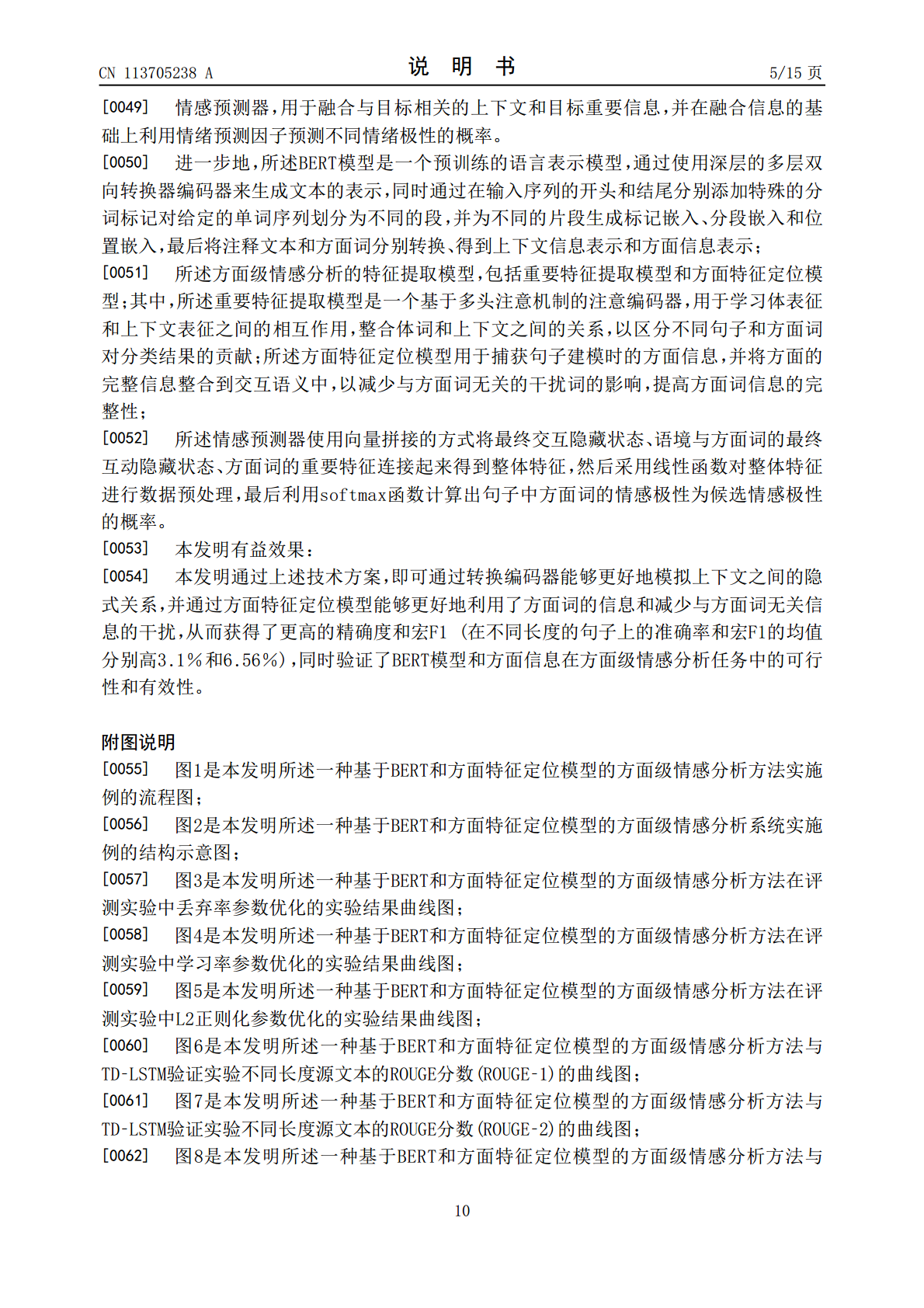

本发明涉及一种基于BERT和方面特征定位模型的方面级情感分析方法及模型,该方法包括:首先利用BERT模型来获得高质量的上下文信息表示和方面信息表示,以保持文本信息的完整性;接着构建一个基于多头注意机制的注意编码器来学习体表征和上下文表征之间的相互作用,整合体词和上下文之间的关系,进一步区分不同句子和方面词对分类结果的贡献;然后构造一个方面特征定位模型来捕获句子建模时的方面信息,并将方面的完整信息整合到交互语义中,以减少与方面词无关的干扰词的影响,提高方面词信息的完整性;最后融合与目标相关的上下文和目标重要

一种基于先验知识的BERT模型的方面级情感分析方法.pdf

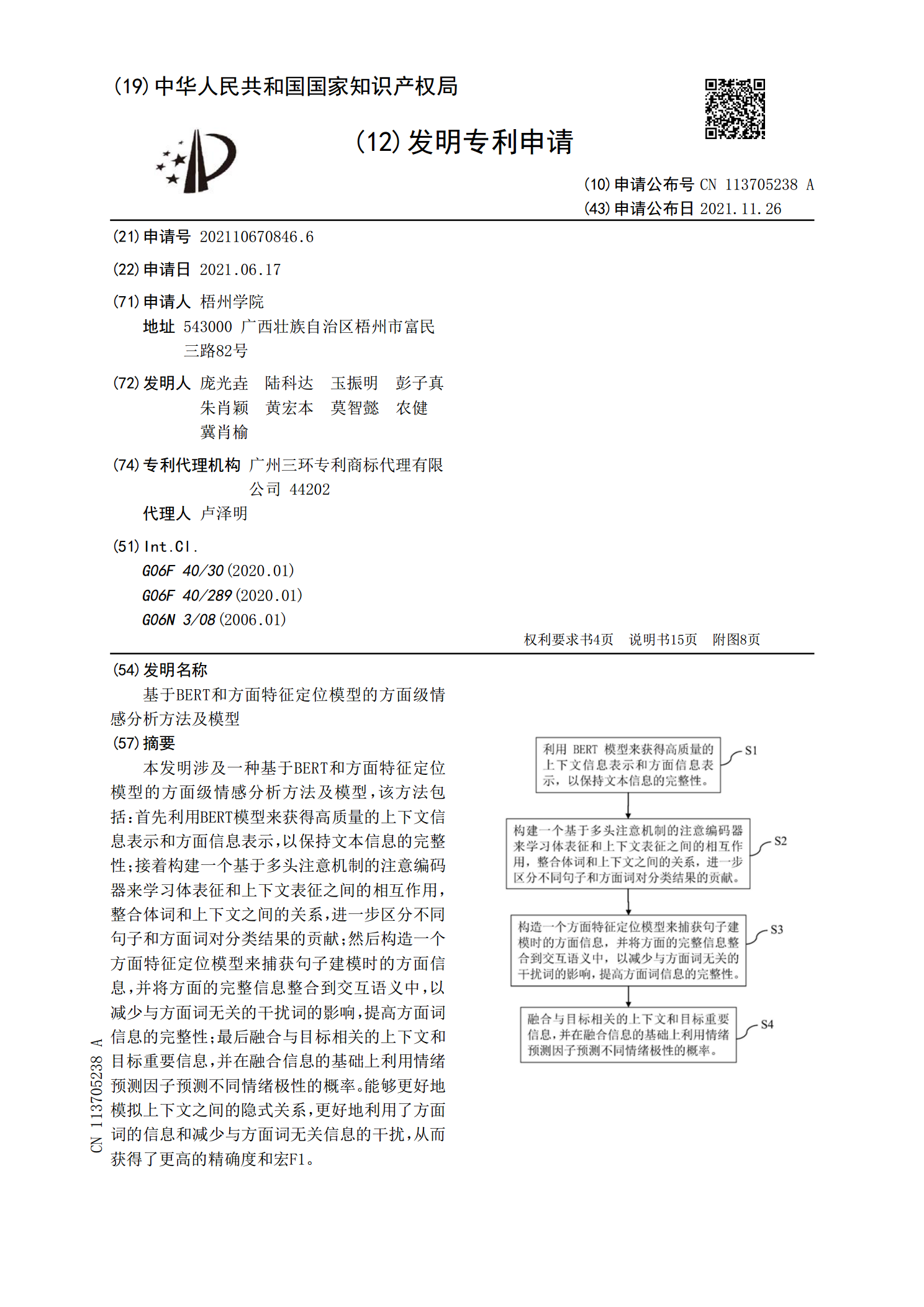

本发明提供了一种基于先验知识的BERT模型的方面级情感分析方法。该方法包括:获得多个方面情感对;将待分析语句和不同的方面情感对组合构成不同的输入文本;将每个输入文本输入方面级情感分析模型,方面级情感分析模型输出每个输入文本的情感分析结果,情感分析结果包括输入文本中待分析语句是否与方面情感对匹配的判断结果;方面级情感分析模型包括:词向量编码模块、第一全连接层、先验知识获取模块和特征融合模块。在方面级情感分析模型中加入先验知识获取模块获得先验知识向量,利用简单但有效的先验知识向量与语义特征向量相结合,让模型学

基于MHSA和GCN的方面级情感分析模型.docx

本文档只有word版,所有PDF版本都为盗版,侵权必究基于MHSA和GCN的方面级情感分析模型1.内容概览本文档主要介绍了基于MHSA(多头自注意力机制)和GCN(图卷积网络)的方面级情感分析模型。该模型旨在实现更为精准的情感分析,特别是针对产品评论或文本内容中的特定方面进行情感倾向判断。本文档概述了方面级情感分析的重要性和应用场景,介绍了MHSA和GCN的基本原理及其在情感分析中的应用。然后详细描述了该模型的结构设计、实现细节以及优化策略。本文档还讨论了模型的性能评估方法,包括实验设置、评估指标以及与其

基于词共现的方面级情感分析模型.pptx

汇报人:目录PARTONEPARTTWO词共现的概念方面级情感分析的定义模型的应用场景PARTTHREE数据预处理词共现关系的计算情感极性的判断方面级的情感分析PARTFOUR评估指标实验设置实验结果分析结果比较与讨论PARTFIVE数据增强模型融合特征选择与优化优化效果评估PARTSIX在产品评论中的应用在社交媒体分析中的应用在市场调查中的应用在客户服务中的应用THANKYOU

基于BERT和分层注意力网络的方面级情感分析.docx

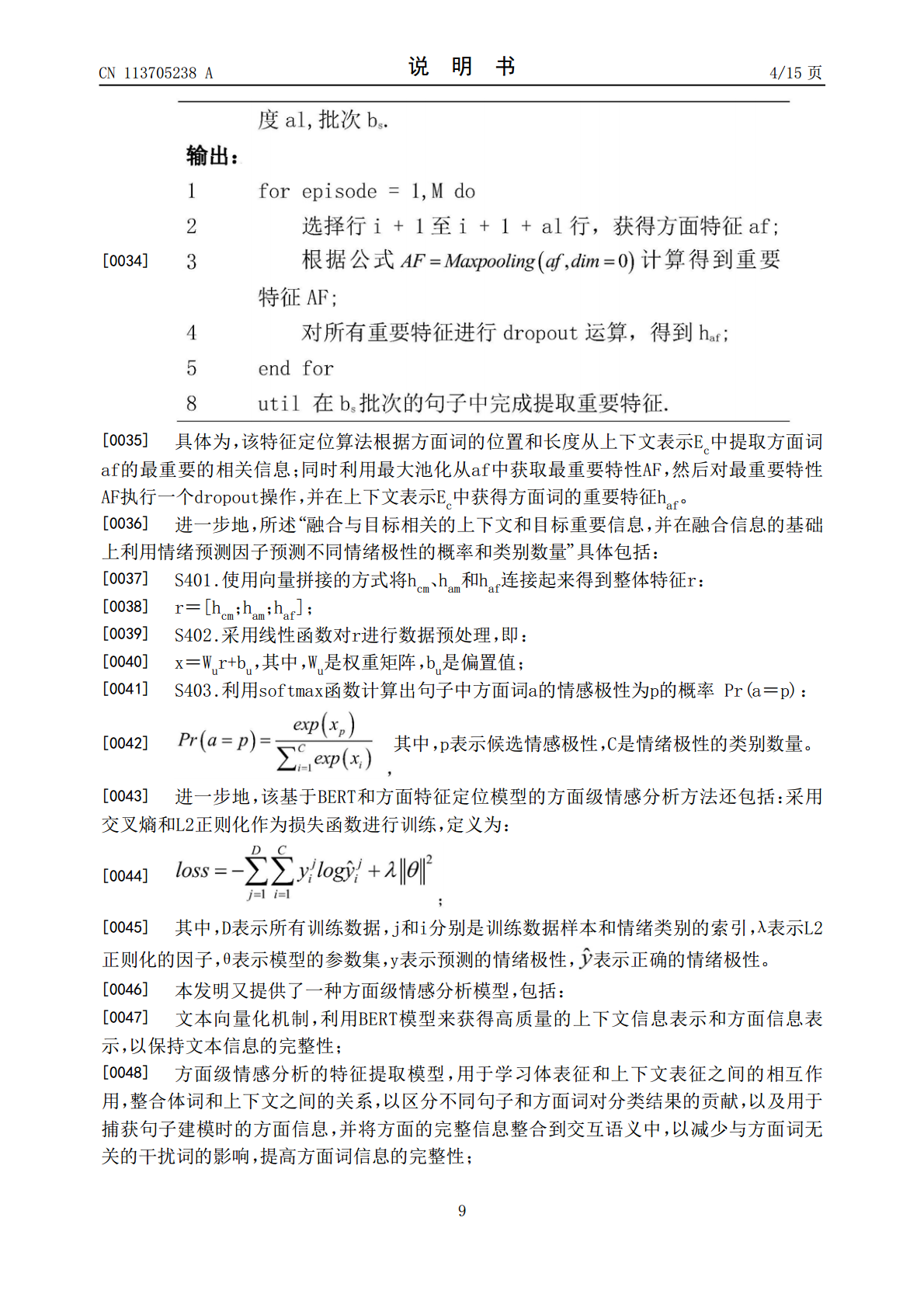

基于BERT和分层注意力网络的方面级情感分析标题:基于BERT和分层注意力网络的方面级情感分析摘要:方面级情感分析是对于文本中涉及到的不同方面进行情感分析的任务,该任务在情感分析领域具有重要的应用价值。本文提出了一种基于BERT(Bi-directionalEncoderRepresentationsfromTransformers)和分层注意力网络的方面级情感分析方法。首先,使用预训练的BERT模型将文本转换为高维表示,将情感分析任务转化为一个分类问题。同时,通过引入分层注意力网络来对文本进行方面级情感