一种基于图卷积网络的多场景单目相机位姿回归方法.pdf

玉环****找我

亲,该文档总共16页,到这已经超出免费预览范围,如果喜欢就直接下载吧~

相关资料

一种基于图卷积网络的多场景单目相机位姿回归方法.pdf

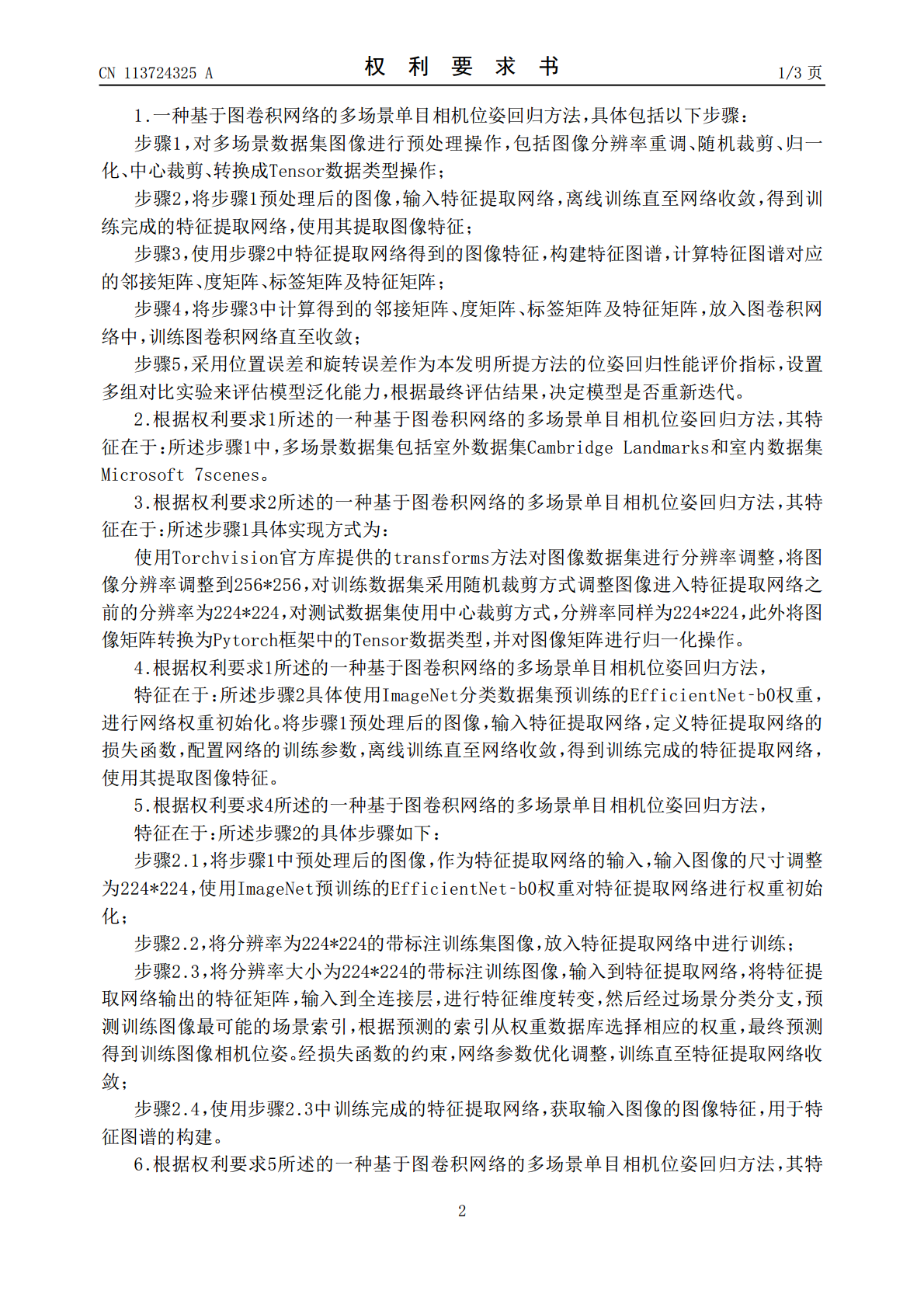

本发明公开了一种基于图卷积网络的多场景单目相机位姿回归方法。首先训练一个多场景的特征提取网络用于位姿回归。然后借助图卷积,优化学习图像特征间的隐藏信息。使用训练完成的特征提取网络得到图像特征,将图像特征构建特征图谱,作为图卷积网络的输入,回归得到优化后的相机位姿。本发明提出的方法结合了多场景单模型训练方式、图像特征构图及图卷积网络,增强了模型泛化能力,提高了位姿回归性能,改善了多场景模型训练时的参数爆炸问题。

基于运动轨迹的单目相机位姿自标定方法.docx

基于运动轨迹的单目相机位姿自标定方法基于运动轨迹的单目相机位姿自标定方法摘要:单目相机的位姿自标定方法在计算机视觉领域中具有重要意义。本文提出了一种基于运动轨迹的单目相机位姿自标定方法。该方法利用相机捕捉到的物体在连续帧中的运动轨迹来估计相机的位姿,通过最小二乘法求解位姿参数。实验结果表明,该方法能够有效地提高单目相机的位姿估计精度和稳定性。关键词:单目相机、位姿自标定、运动轨迹、最小二乘法一、引言在计算机视觉领域中,单目相机广泛应用于目标检测、姿态估计、三维重建等任务中。相机的位姿估计是这些应用中的关键

基于运动轨迹的单目相机位姿自标定方法.docx

基于运动轨迹的单目相机位姿自标定方法摘要:在计算机视觉和机器人领域,利用单目相机来进行目标检测和定位是一个非常重要的研究方向。在这个过程中,相机的位姿自标定是一个非常重要的步骤,因为它可以帮助我们估计出相机的内参和外参。在本文中,我们介绍一种基于运动轨迹的单目相机位姿自标定方法,该方法使用一些基本的运动轨迹如圆和直线以及一些特征点来估计位姿变化和相机参数。我们使用实际摄像头获取的数据进行实验,并且我们的实验结果表明,我们的方法非常有效。关键词:位姿自标定,单目相机,运动轨迹,特征点引言:单目相机在计算机视

单目相机位姿估计的稳健正交迭代方法.pptx

,CONTENTS01.02.定义与目标算法流程迭代公式收敛性分析03.正交迭代算法原理正交迭代算法步骤正交迭代算法收敛性分析04.稳健性定义算法鲁棒性分析算法稳定性分析实验验证05.位姿估计问题描述位姿估计方法分类算法适用场景与限制实验结果对比分析06.应用领域与实例算法优缺点总结未来研究方向与展望感谢您的观看!

基于密集卷积网络的单目图像深度估计方法.pptx

基于密集卷积网络的单目图像深度估计方法01添加章节标题密集卷积网络的基本原理卷积神经网络的基本结构密集卷积网络的特点和优势密集卷积网络在单目图像深度估计中的应用单目图像深度估计方法基于相机的单目深度估计方法基于视差的单目深度估计方法基于光流的单目深度估计方法基于深度学习的单目深度估计方法基于密集卷积网络的单目图像深度估计方法密集卷积网络在深度估计中的实现方式密集卷积网络在深度估计中的优化策略密集卷积网络在深度估计中的性能评估密集卷积网络在深度估计中的未来发展方向实验结果与分析实验数据集和实验环境介绍实验方