基于强化学习TD3算法的异构无线网络垂直切换方法.pdf

猫巷****熙柔

亲,该文档总共11页,到这已经超出免费预览范围,如果喜欢就直接下载吧~

相关资料

基于强化学习TD3算法的异构无线网络垂直切换方法.pdf

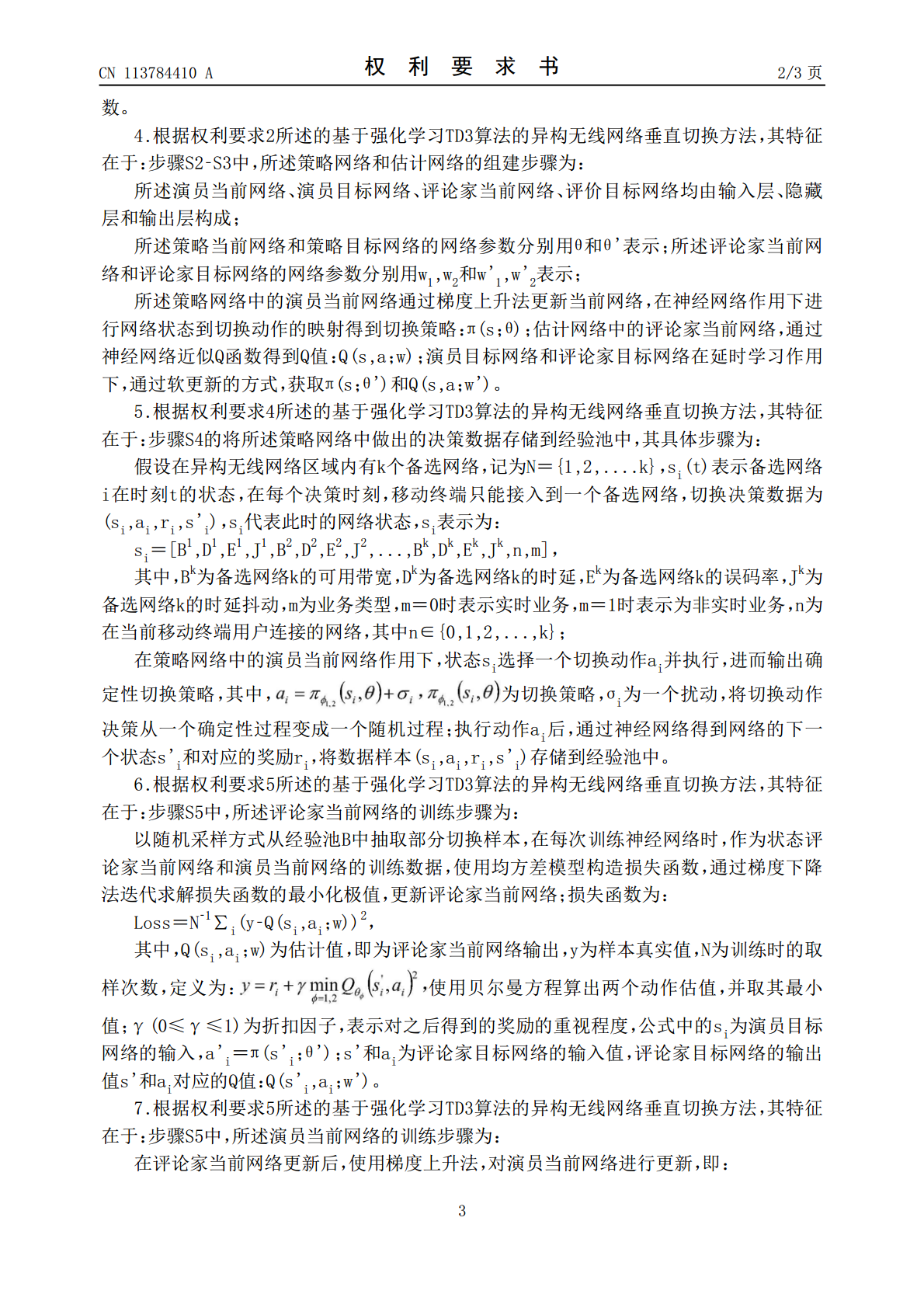

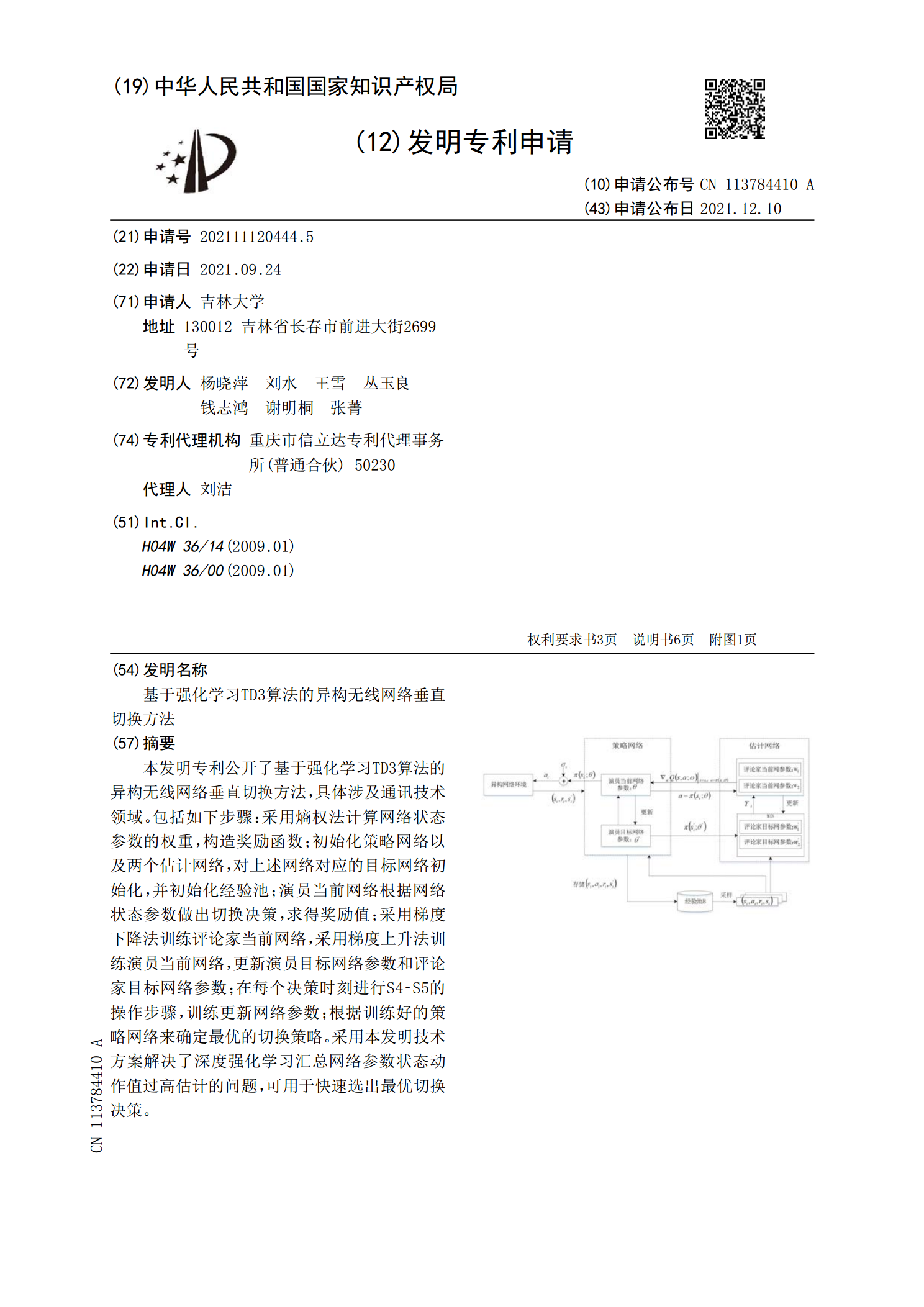

本发明专利公开了基于强化学习TD3算法的异构无线网络垂直切换方法,具体涉及通讯技术领域。包括如下步骤:采用熵权法计算网络状态参数的权重,构造奖励函数;初始化策略网络以及两个估计网络,对上述网络对应的目标网络初始化,并初始化经验池;演员当前网络根据网络状态参数做出切换决策,求得奖励值;采用梯度下降法训练评论家当前网络,采用梯度上升法训练演员当前网络,更新演员目标网络参数和评论家目标网络参数;在每个决策时刻进行S4‑S5的操作步骤,训练更新网络参数;根据训练好的策略网络来确定最优的切换策略。采用本发明技术方案

异构无线网络垂直切换算法研究.docx

异构无线网络垂直切换算法研究论文题目:异构无线网络垂直切换算法研究摘要:随着移动互联网的快速发展,异构无线网络成为实现无缝漫游、提高用户体验和网络容量的重要技术手段。垂直切换算法作为实现网络中无缝漫游的核心问题之一,针对不同的无线接入技术及其特点,本论文系统地分析了各种垂直切换算法,并对其优化进行了探讨。通过对算法的研究与比较,得出了结论,对于不同网络环境,适应性强的垂直切换算法能够更好地实现无缝漫游,提高网络性能。关键词:异构无线网络、垂直切换、无缝漫游、算法优化一、引言随着5G时代的到来,异构无线网络

异构无线网络垂直切换算法之MEW算法.docx

异构无线网络垂直切换算法之MEW算法随着无线网络技术的不断发展,各种不同类型的网络依次出现。这些网络按照不同的传输技术和分布方式划分为不同的类别,例如CDMA、Wi-Fi等。然而,这些网络由于各自的技术和局限性,不能完全满足用户的需求,因此根据用户的需求,同时使用异构无线网络成为了一种新趋势。但由于各异构无线网络之间存在着数之不尽的技术差异,很难将所有网络整合为一个简单的网络平台。然而,通过垂直切换技术,用户可以在不同的网络之间进行切换,并且获得额外的服务支持,这为用户提供了更好的体验。在实现垂直切换时,

异构无线网络中基于802.21标准的垂直切换算法研究.docx

异构无线网络中基于802.21标准的垂直切换算法研究摘要随着移动设备的普及和无线通信技术的不断发展,人们对无线网络覆盖面的需求越来越高,提高网络的可用性和平滑转移对于满足用户需求至关重要。基于这个需求,802.21标准被提出,可以实现异构无线网络的垂直切换。本文介绍了该标准的基本概念和算法,对垂直切换进行了详细分析和研究,并讨论了它的优缺点。关键词:无线网络,垂直切换,802.21标准引言异构无线网络是指由多个网络技术(如Wi-Fi、LTE等)组成的网络系统,这些技术在不同的无线通信环境下具有不同的优点和

基于博弈论的异构无线网络垂直切换算法的研究.docx

基于博弈论的异构无线网络垂直切换算法的研究基于博弈论的异构无线网络垂直切换算法的研究摘要:随着无线通信技术的不断发展,异构无线网络已成为实现高容量和高速率数据传输的关键技术。然而,由于不同无线网络之间的差异,用户在移动时可能会面临网络切换问题。为了解决此问题,本论文提出了一种基于博弈论的异构无线网络垂直切换算法,旨在为用户提供更好的服务质量和用户体验。该算法以博弈论为基础,考虑各个网络的负载和资源利用率,以及用户的移动速度和需求,通过决策和博弈过程来确定最佳的垂直切换策略。1.引言随着移动互联网的普及,无