基于人工智能的语音合成方法、装置、设备及存储介质.pdf

长春****主a

亲,该文档总共22页,到这已经超出免费预览范围,如果喜欢就直接下载吧~

相关资料

基于人工智能的语音合成方法、装置、设备及存储介质.pdf

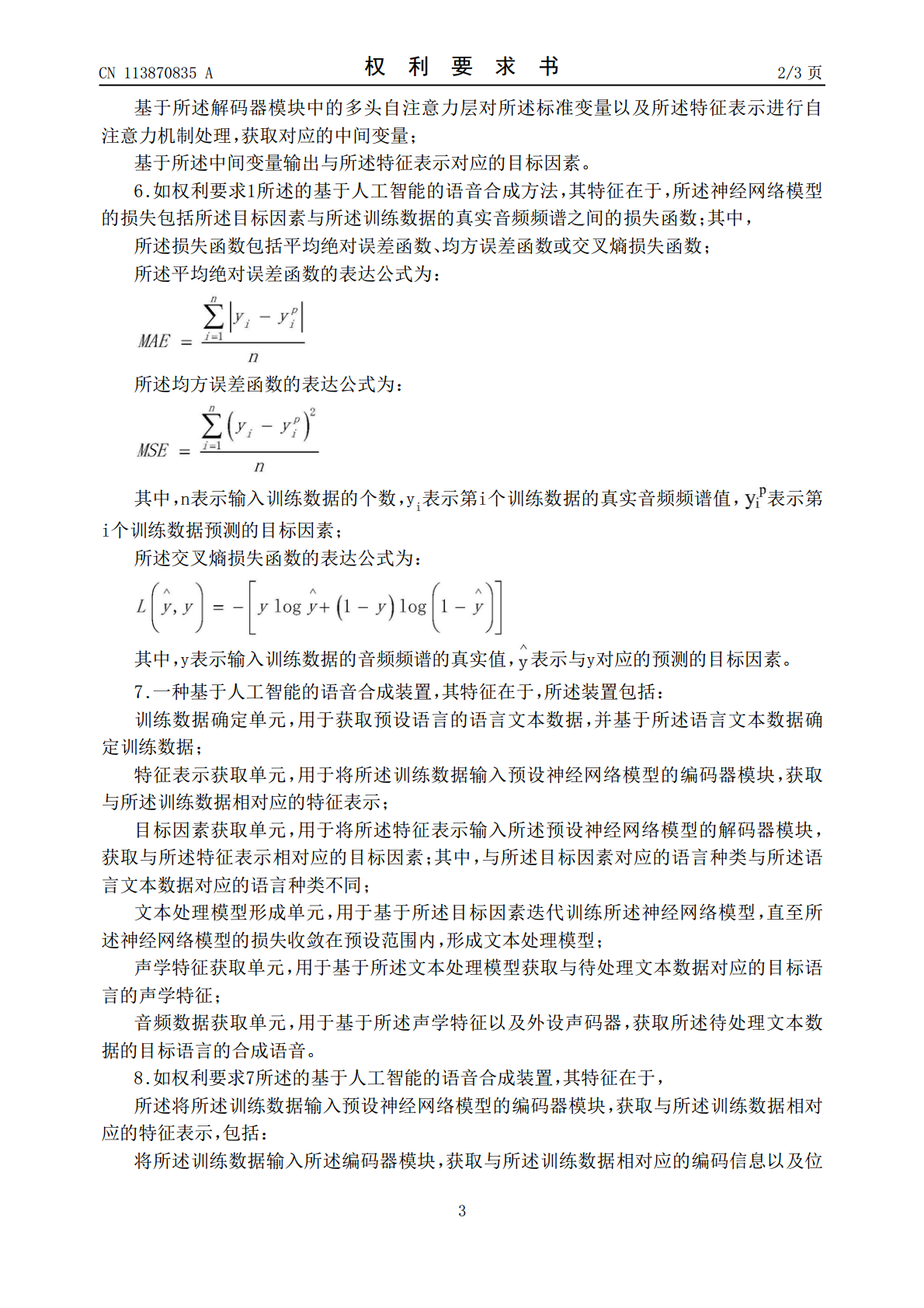

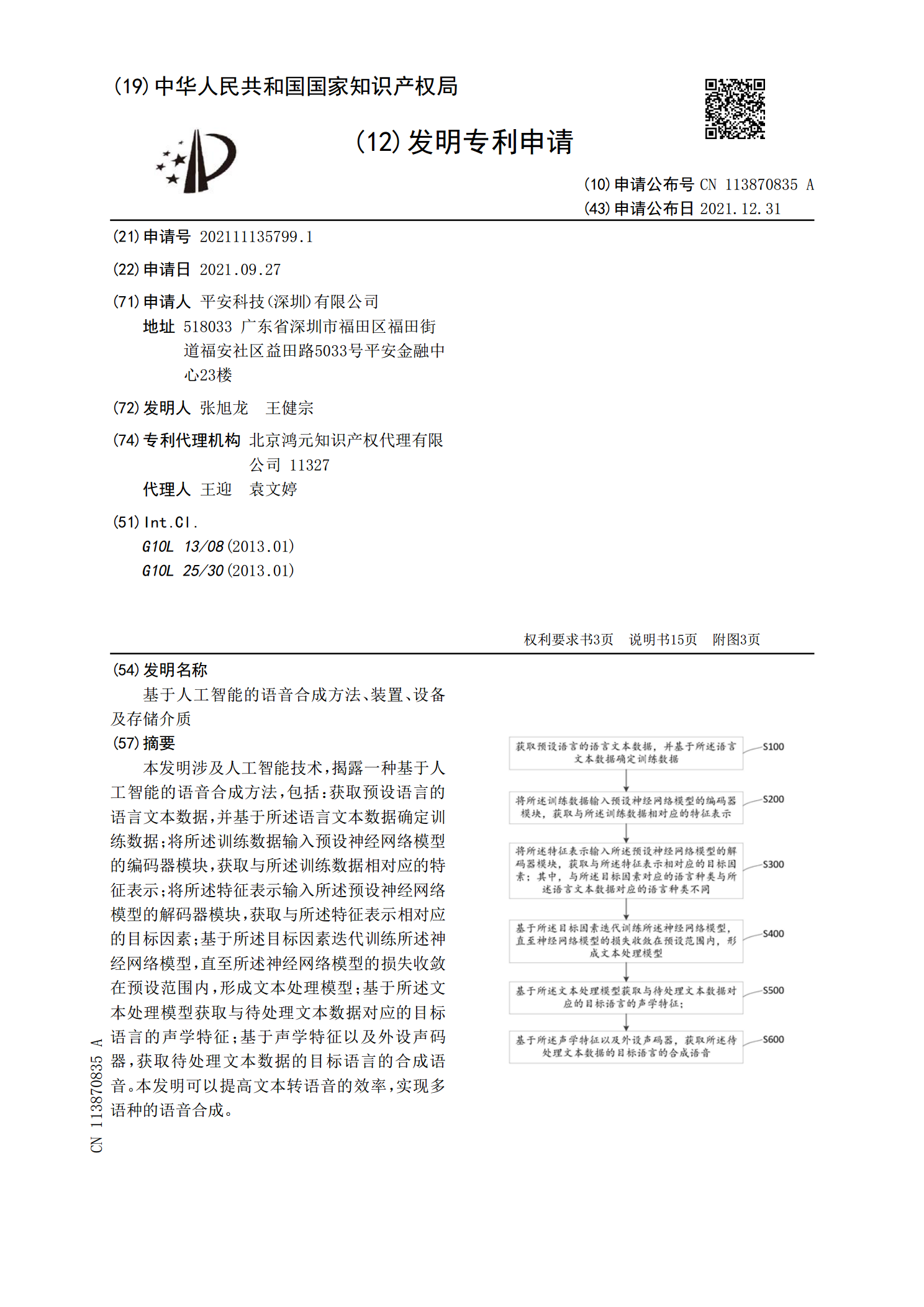

本发明涉及人工智能技术,揭露一种基于人工智能的语音合成方法,包括:获取预设语言的语言文本数据,并基于所述语言文本数据确定训练数据;将所述训练数据输入预设神经网络模型的编码器模块,获取与所述训练数据相对应的特征表示;将所述特征表示输入所述预设神经网络模型的解码器模块,获取与所述特征表示相对应的目标因素;基于所述目标因素迭代训练所述神经网络模型,直至所述神经网络模型的损失收敛在预设范围内,形成文本处理模型;基于所述文本处理模型获取与待处理文本数据对应的目标语言的声学特征;基于声学特征以及外设声码器,获取待处理

基于人工智能的语音合成方法、装置、设备及存储介质.pdf

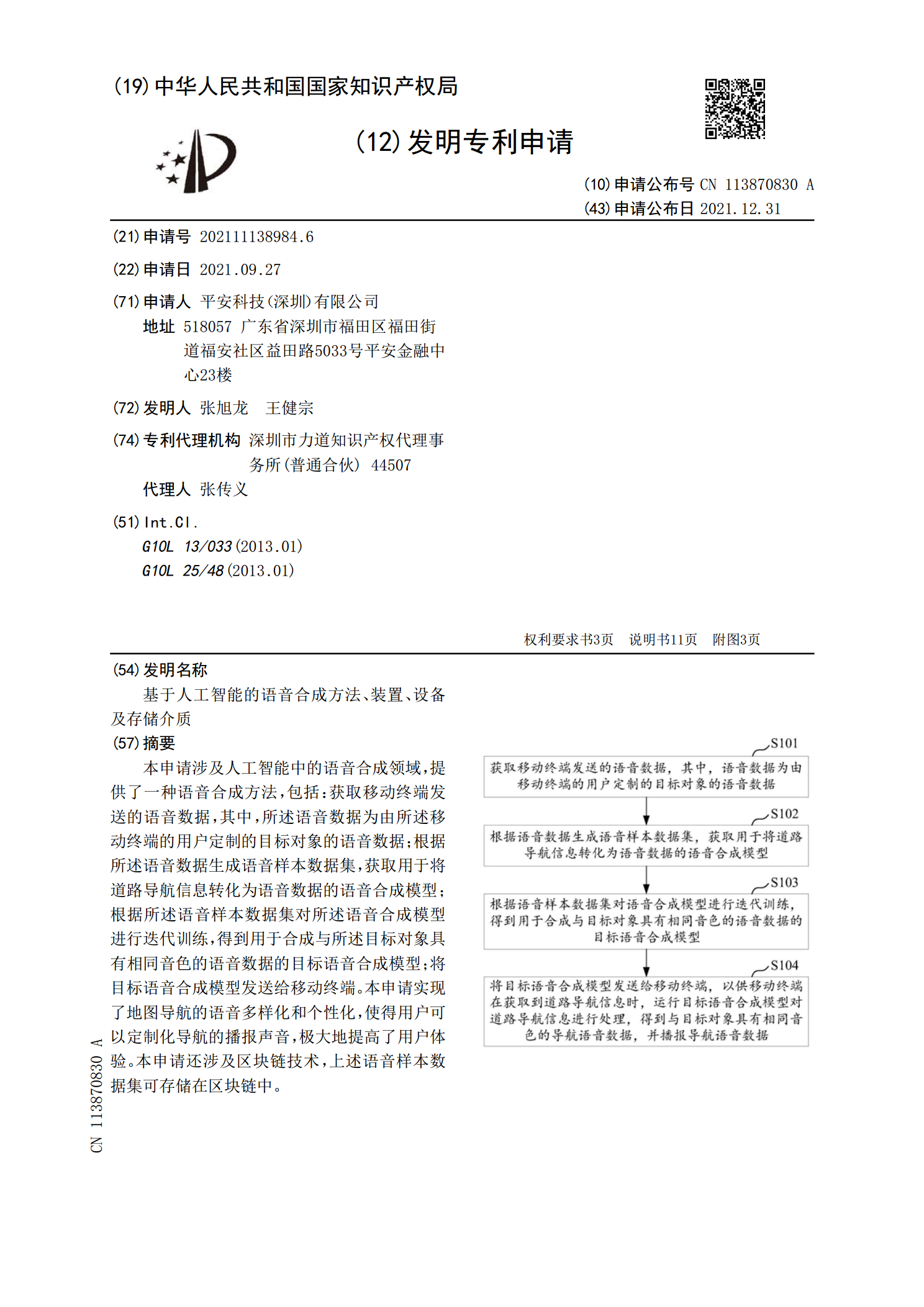

本申请涉及人工智能中的语音合成领域,提供了一种语音合成方法,包括:获取移动终端发送的语音数据,其中,所述语音数据为由所述移动终端的用户定制的目标对象的语音数据;根据所述语音数据生成语音样本数据集,获取用于将道路导航信息转化为语音数据的语音合成模型;根据所述语音样本数据集对所述语音合成模型进行迭代训练,得到用于合成与所述目标对象具有相同音色的语音数据的目标语音合成模型;将目标语音合成模型发送给移动终端。本申请实现了地图导航的语音多样化和个性化,使得用户可以定制化导航的播报声音,极大地提高了用户体验。本申请还

合成中文语音的方法、装置、设备及存储介质.pdf

本发明涉及人工智能领域的语言信号处理领域,公开了合成中文语音的方法、装置、设备及存储介质,用于减少训练时长,同时增强模型表现力和泛化能力,进一步提高合成的语音质量。本发明方法包括:获取初始梅尔频谱和目标向量;对目标向量进行处理得到第一序列,第一序列为二维张量;对初始梅尔频谱进行处理,得到目标梅尔频谱;确定第一序列与目标梅尔频谱在各个子空间中的目标对应关系;根据自注意力机制和目标对应关系进行语音合成,得到目标语音。

语音合成方法、装置、设备及存储介质.pdf

本发明涉及语义合成技术领域,公开了一种语音合成方法、装置、计算机设备及计算机可读存储介质,该方法包括:获取待合成文本,并通过语音合成模型将所述待合成文本转换为图嵌入向量信息,根据图编码器对所述图嵌入向量信息进行编码,生成对应的第一中间向量信息,根据所述第一中间向量信息生成对应的梅尔语谱信息,输出所述梅尔语谱信息对应的语音合成信息,实现通过图辅助编码器分析文本信息的具体语义信息来映射到不同的语音韵律节奏,使得韵律调节的过程成为一个全自动化的过程,提高了语音合成的准确率。同时,本发明还涉及区块链技术,且本发明

基于人工智能的语音识别方法、装置及存储介质.pdf

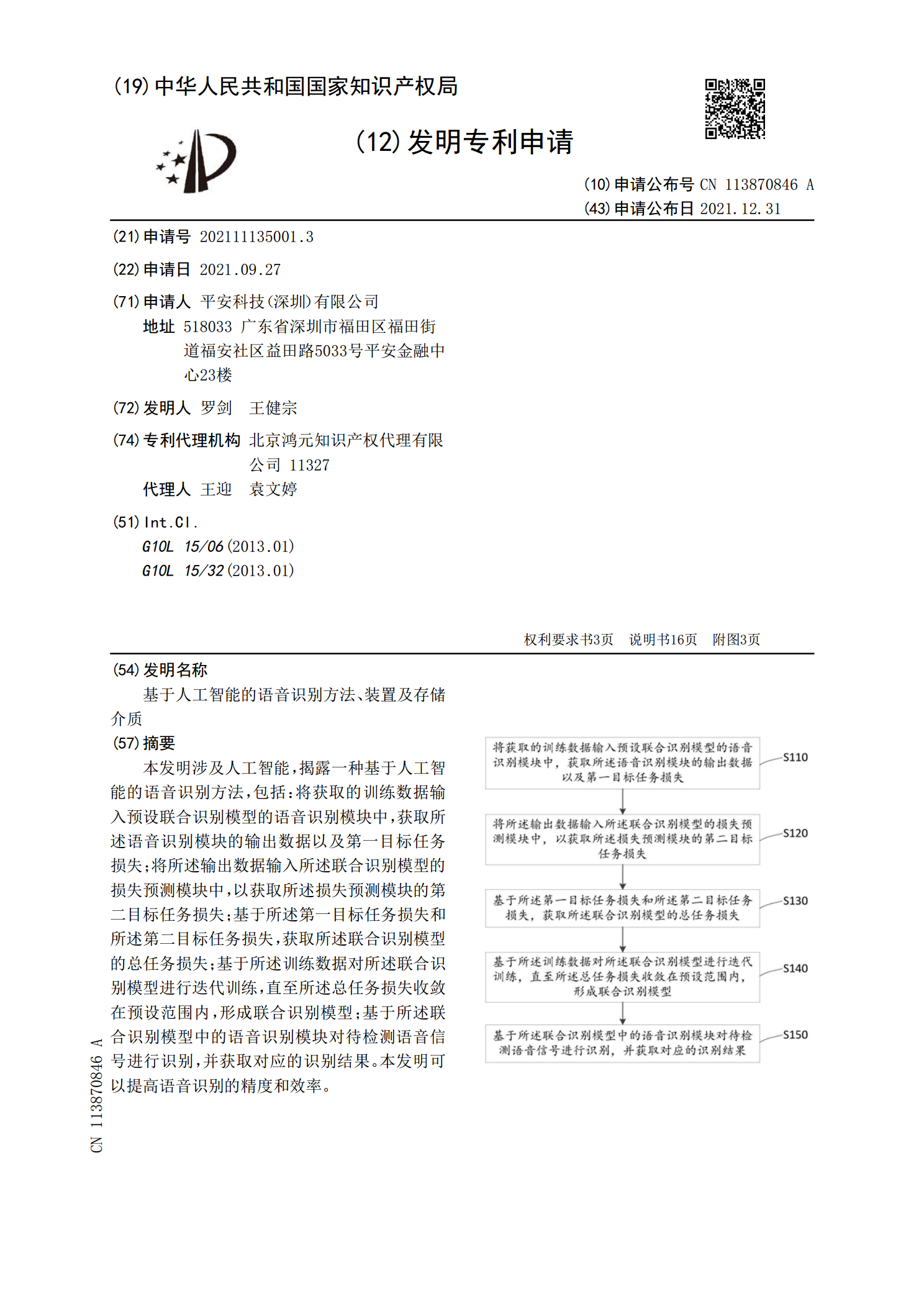

本发明涉及人工智能,揭露一种基于人工智能的语音识别方法,包括:将获取的训练数据输入预设联合识别模型的语音识别模块中,获取所述语音识别模块的输出数据以及第一目标任务损失;将所述输出数据输入所述联合识别模型的损失预测模块中,以获取所述损失预测模块的第二目标任务损失;基于所述第一目标任务损失和所述第二目标任务损失,获取所述联合识别模型的总任务损失;基于所述训练数据对所述联合识别模型进行迭代训练,直至所述总任务损失收敛在预设范围内,形成联合识别模型;基于所述联合识别模型中的语音识别模块对待检测语音信号进行识别,并