一种基于深度学习的双目窄对接焊缝检测方法.pdf

书生****66

亲,该文档总共15页,到这已经超出免费预览范围,如果喜欢就直接下载吧~

相关资料

一种基于深度学习的双目窄对接焊缝检测方法.pdf

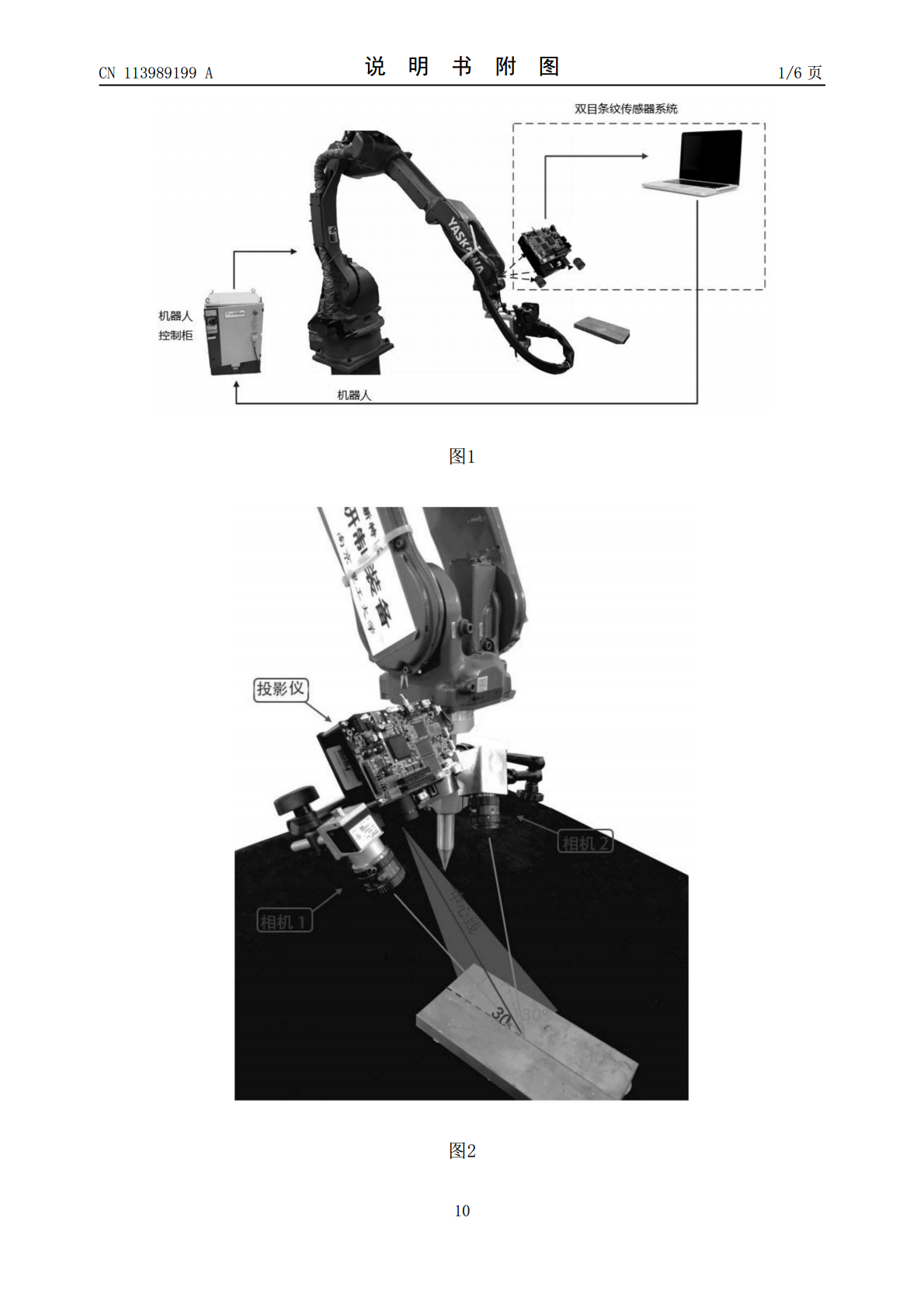

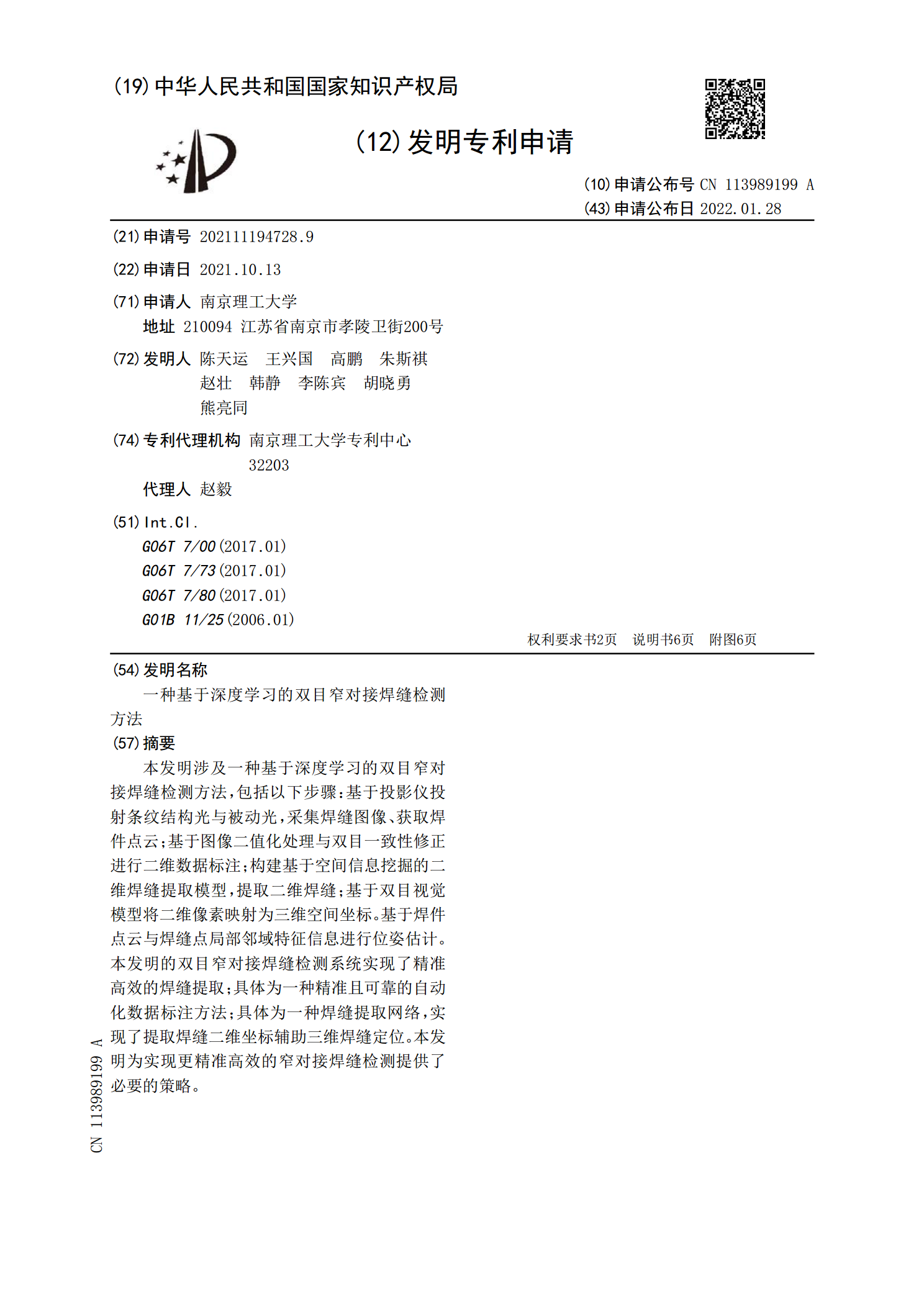

本发明涉及一种基于深度学习的双目窄对接焊缝检测方法,包括以下步骤:基于投影仪投射条纹结构光与被动光,采集焊缝图像、获取焊件点云;基于图像二值化处理与双目一致性修正进行二维数据标注;构建基于空间信息挖掘的二维焊缝提取模型,提取二维焊缝;基于双目视觉模型将二维像素映射为三维空间坐标。基于焊件点云与焊缝点局部邻域特征信息进行位姿估计。本发明的双目窄对接焊缝检测系统实现了精准高效的焊缝提取;具体为一种精准且可靠的自动化数据标注方法;具体为一种焊缝提取网络,实现了提取焊缝二维坐标辅助三维焊缝定位。本发明为实现更精准

基于视觉的微细对接焊缝检测方法.docx

基于视觉的微细对接焊缝检测方法基于视觉的微细对接焊缝检测方法摘要:随着制造业的快速发展和自动化生产的需求增加,对焊接质量的要求也逐渐提高。焊接过程中,焊缝的精确检测对于确保焊接质量至关重要。本论文提出了一种基于视觉的微细对接焊缝检测方法,旨在利用计算机视觉和图像处理技术,通过对焊缝图像的处理和分析,实现焊缝的自动检测和评估。引言:随着制造工艺技术的改进和机器人技术的发展,焊接技术被广泛应用于制造业各个领域。然而,焊接质量的稳定性和一致性一直是制约焊接技术发展的关键因素之一。而焊缝的微细对接是焊接质量的保证

一种基于深度学习的射线图像焊缝缺陷检测方法.pdf

本发明所提供的一种基于深度学习的射线图像焊缝缺陷检测方法,利用FasterRCNN网络对射线图像进行目标检测,在传统FasterRCNN的基础上,本发明增加背景减去网络层,得到五个模块的FasterRCNN网络结构,该背景减去网络层具有带更新的参数,能随着网络训练不断优化降低背景的效果,突出缺陷特点,同时,利用三支路区域推荐网络层代替传统区域推荐网络,它具有的两个回归分支使预测缺陷位置信息的任务得到细分,一个分支负责预测缺陷的中心点横坐标和宽,一个分支负责预测缺陷的中心点纵坐标和高,增强缺陷位置预测

基于深度学习的管道环焊缝目标检测方法.pptx

汇报人:目录PARTONEPARTTWO深度学习在目标检测中的重要性基于深度学习的管道环焊缝目标检测方法概述深度学习在管道环焊缝目标检测中的优势PARTTHREE卷积神经网络(CNN)是一种深度学习算法,广泛应用于图像处理和识别领域。2卷积神经网络(CNN)在管道环焊缝目标检测中的应用2卷积神经网络(CNN)在管道环焊缝目标检测中的应用卷积神经网络(CNN)是一种深度学习算法,广泛应用于图像处理和识别领域。***N具有强大的特征提取能力,可以自动学习到图像中的特征,从而提高检测精度。***N在管道环焊缝目

一种新的TOFD检测平板对接焊缝缺陷深度的计算方法.docx

一种新的TOFD检测平板对接焊缝缺陷深度的计算方法TOFD(Time-of-FlightDiffraction)是一种非破坏性检测技术,可以用于检测焊缝缺陷的大小和深度。TOFD检测具有非常高的检测灵敏度和精度,因此在工业生产中得到了广泛的应用。TOFD检测对于平板对接焊缝的缺陷检测尤为重要。但是,由于焊缝的复杂性和不均匀性,检测过程中存在一定的误差,尤其是在测量焊缝缺陷的深度时。因此,研究一种新的TOFD检测平板对接焊缝缺陷深度的计算方法非常必要。本文提出了一种新的TOFD检测平板对接焊缝缺陷深度计算方