移动边缘网络中基于FDQL的多维资源协同优化方法.pdf

努力****凌芹

亲,该文档总共22页,到这已经超出免费预览范围,如果喜欢就直接下载吧~

相关资料

移动边缘网络中基于FDQL的多维资源协同优化方法.pdf

现有技术中,移动边缘网络呈现出智能化、多元化、综合化的趋势,使得多维资源最优分配面临诸多挑战。为了提升多维资源优化的精确性,本发明提出一种移动边缘网络中基于FDQL的多维资源协同优化方法。本方法以最小化MOS为优化目标来构建多维资源分配模型,并设计一种双层的决策方案。首先,底层的基站利用双深度Q学习DDQL进行局部模型训练以获得短周期内最优决策;然后,上层的边缘节点利用联邦深度学习FDQL进行全局模型训练以降低长周期内分布式决策的偏差。实验结果表明,所提算法在降低内容服务时延和提高用户体验质量方面都优于其

边缘-云协同系统中基于学习优化方法的虚拟网络功能放置方法.pdf

本发明提出了一种边云协同系统中基于学习优化方法的虚拟网络功能放置决策方法,包括以下步骤:S1,获取边缘云和第三方云数据;S2,根据获取的边缘云和第三方云数据进行优化放置决策。本发明首先建立了基于代价的虚拟网络功能放置的优化决策问题,然后将该模型以马尔可夫决策模型进行描述;通过把深度强化学习与组合优化求解相结合提出了基于“行动?判别”的虚拟网络功能放置双重放置框架,提出的网络功能放置算法在不同规模的边云场景下中均具有良好的适应性,并且能够通过合理的虚拟化类型选择和放置位置决策获得更低的系统开销,并为需求方用

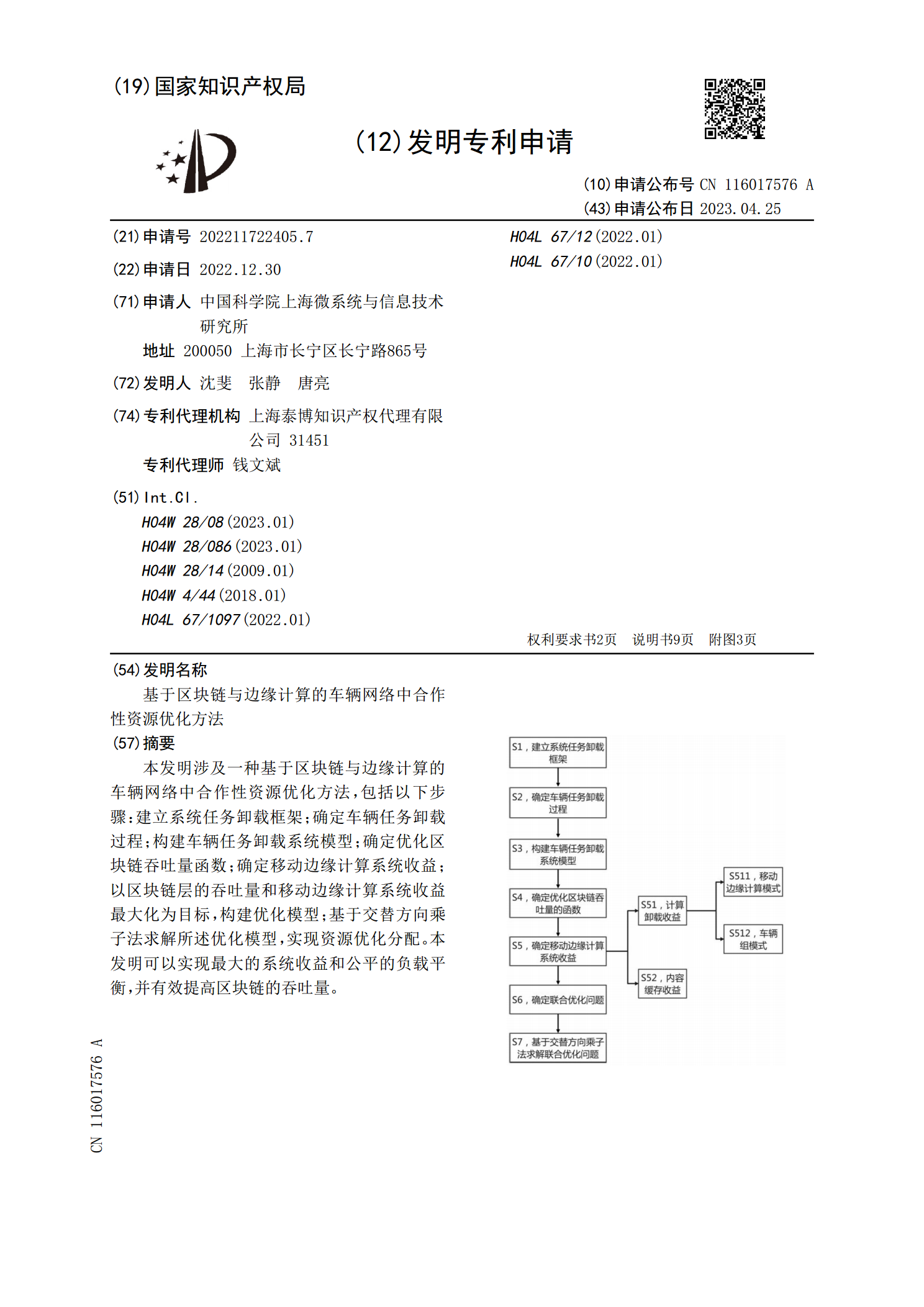

基于区块链与边缘计算的车辆网络中合作性资源优化方法.pdf

本发明涉及一种基于区块链与边缘计算的车辆网络中合作性资源优化方法,包括以下步骤:建立系统任务卸载框架;确定车辆任务卸载过程;构建车辆任务卸载系统模型;确定优化区块链吞吐量函数;确定移动边缘计算系统收益;以区块链层的吞吐量和移动边缘计算系统收益最大化为目标,构建优化模型;基于交替方向乘子法求解所述优化模型,实现资源优化分配。本发明可以实现最大的系统收益和公平的负载平衡,并有效提高区块链的吞吐量。

移动边缘网络中基于双深度Q学习的高能效资源分配方法.pptx

移动边缘网络中基于双深度Q学习的高能效资源分配方法目录添加目录项标题双深度Q学习算法介绍深度Q学习算法原理双深度Q学习算法的提出双深度Q学习算法的优势双深度Q学习算法的应用场景移动边缘网络资源分配问题移动边缘网络资源分配的重要性资源分配问题的挑战与难点基于双深度Q学习的高能效资源分配方法方法优势与效果评估双深度Q学习算法实现细节数据预处理与特征提取神经网络结构设计与训练经验回放机制与参数优化算法收敛性与稳定性分析实验验证与结果分析实验设置与数据集描述实验结果展示与分析与其他算法的对比分析性能提升与应用前景

基于边缘计算的移动网络缓存和转发优化研究.docx

基于边缘计算的移动网络缓存和转发优化研究随着移动互联网的不断普及,移动网络的流量也在持续增长。然而,当前移动网络的带宽和容量却无法跟上移动流量爆发式增长的步伐,导致移动终端用户的网络体验受到了严重的影响。因此,如何提高移动网络的质量和性能,成为当前移动网络领域的一个热门研究方向。其中,基于边缘计算的移动网络缓存和转发优化技术成为了研究的重点。边缘计算是一种新兴的计算模式,它将计算和存储资源部署在网络的边缘,以更好地满足用户需求。当前的互联网基础设施已经不再满足全球互联的需求,而边缘计算为互联网提供了更快、