一种基于轻量化预训练语言模型的文本分类方法.pdf

一只****呀盟

亲,该文档总共47页,到这已经超出免费预览范围,如果喜欢就直接下载吧~

相关资料

一种基于轻量化预训练语言模型的文本分类方法.pdf

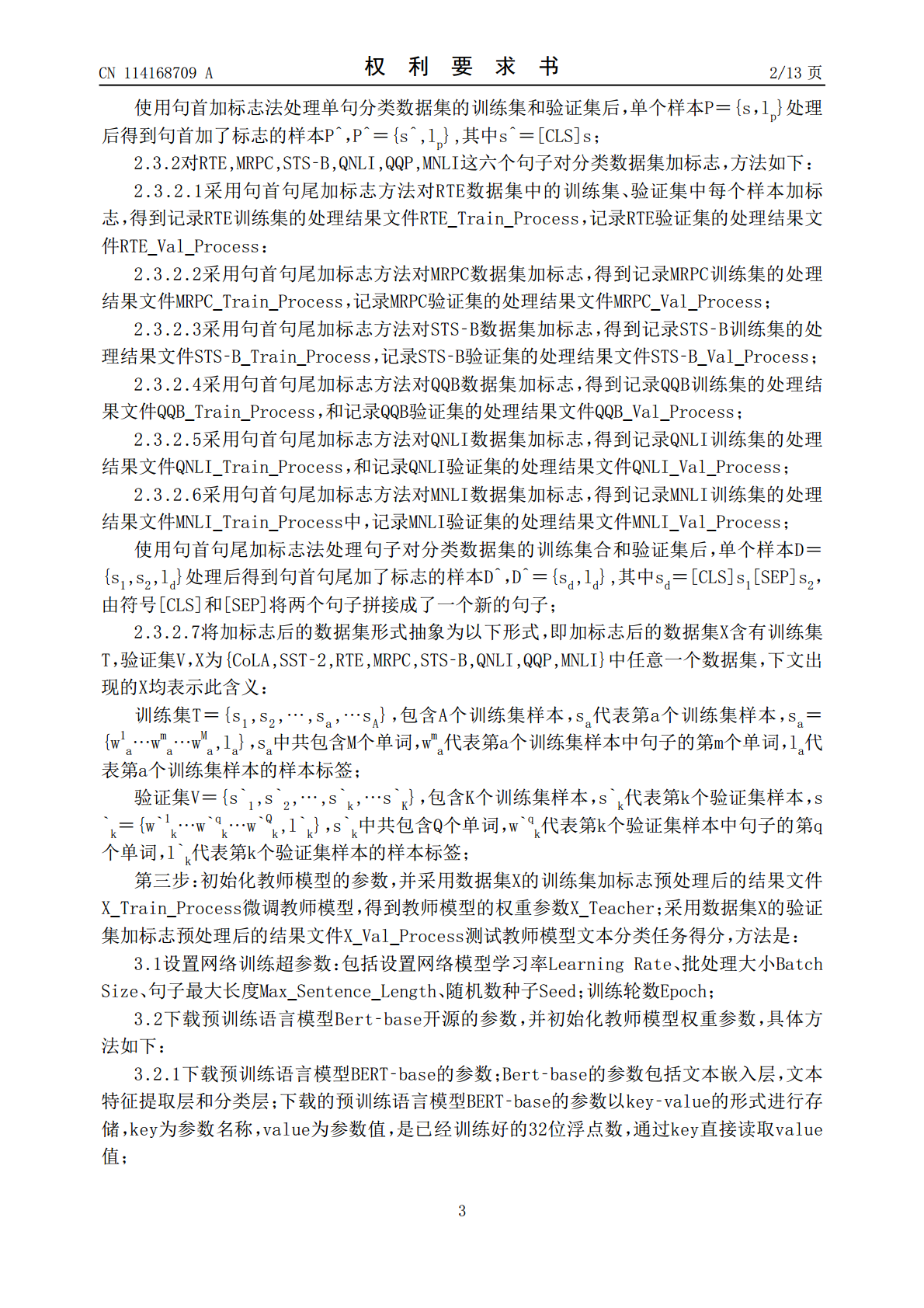

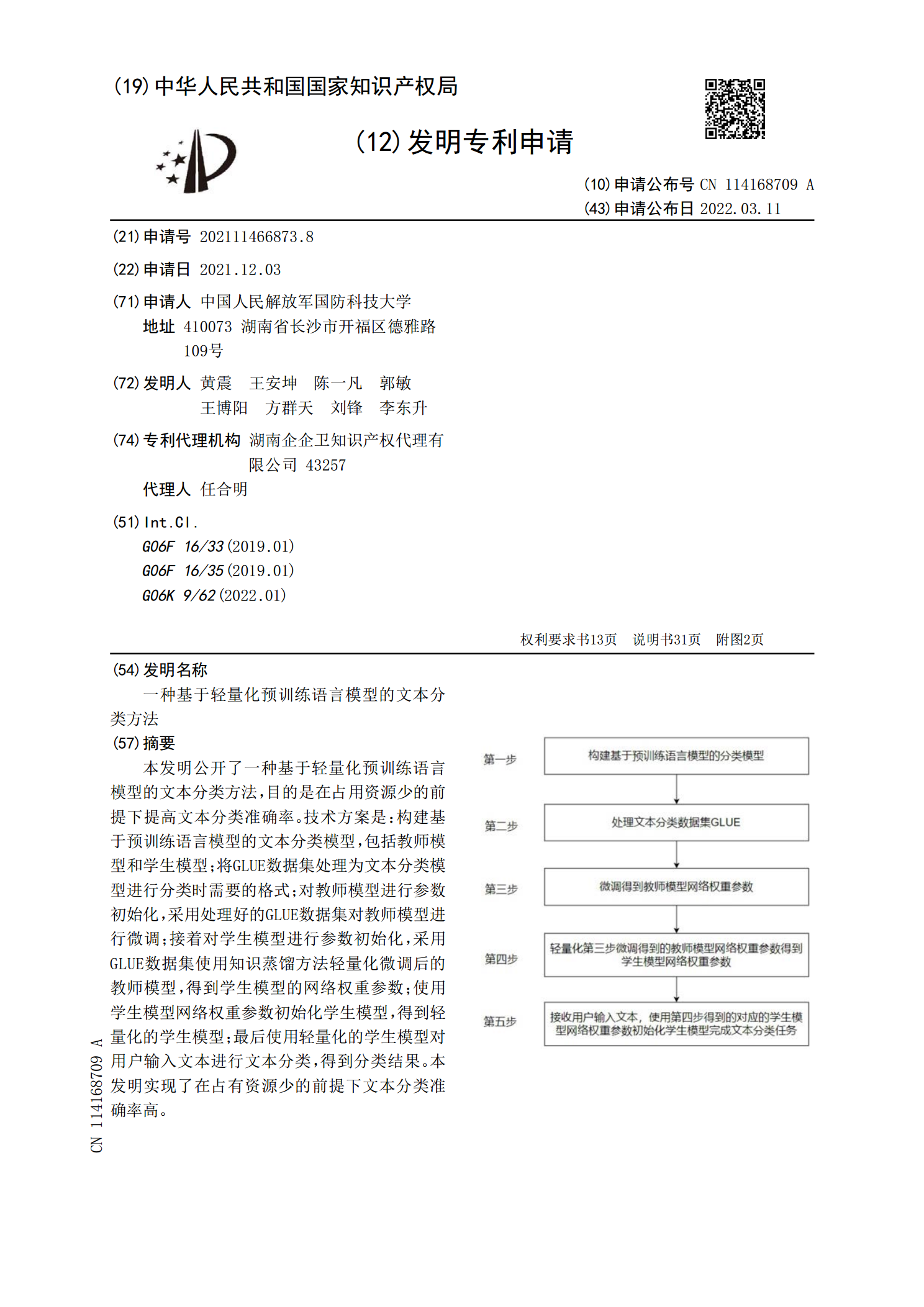

本发明公开了一种基于轻量化预训练语言模型的文本分类方法,目的是在占用资源少的前提下提高文本分类准确率。技术方案是:构建基于预训练语言模型的文本分类模型,包括教师模型和学生模型;将GLUE数据集处理为文本分类模型进行分类时需要的格式;对教师模型进行参数初始化,采用处理好的GLUE数据集对教师模型进行微调;接着对学生模型进行参数初始化,采用GLUE数据集使用知识蒸馏方法轻量化微调后的教师模型,得到学生模型的网络权重参数;使用学生模型网络权重参数初始化学生模型,得到轻量化的学生模型;最后使用轻量化的学生模型对用

基于预训练模型变种的新闻文本分类方法及系统.pdf

本发明公开了一种基于预训练模型变种的新闻文本分类方法及系统,属于文本分类领域。本发明采用BERT和RNN复合模型对数据集中的特征进行有效提取,对于已经经过预训练的BERT模型,其广泛适用于下游任务的各个集合,不需要利用重复数据进行训练,同时基于self‑attention机制可以有效的可以不仅可以得到源端与目标端词与词之间的依赖关系,同时还可以有效获取源端或目标端自身词与词之间的依赖关系。在此基础上,引入了RNN模型,用于捕捉长距离文本依赖上信息丢失的问题,对结果进行特征融合,在新闻文本分类上取得了较为理

基于知识蒸馏的语言模型训练方法、文本分类方法及装置.pdf

本公开是关于一种基于知识蒸馏的语言模型训练方法、文本分类方法、基于知识蒸馏的语言模型训练装置、文本分类装置、电子设备及非临时性计算机可读存储介质。基于知识蒸馏的语言模型训练方法,包括:第一词向量层参数确定步骤和语言模型训练步骤。文本分类方法包括:获取待分类文本;基于待分类文本,通过提取得到待分类文本的关键词编码列表;根据关键词编码列表,通过语言模型,得到待分类文本对应的各关键词的词向量;进而通过文本分类层,得到待分类文本的分类结果。采用知识蒸馏的方法,保留模型准确性的同时,减少了对标注样本的依赖,且通过简

一种基于轻量化分类模型的分类检测方法及装置.pdf

本申请提供一种基于轻量化分类模型的分类检测方法及装置。方法包括获取训练样本图像,并确定训练样本图像的类别;根据类别对训练样本图像进行分类标记,得到样本标记图像;将样本标记图像输入至轻量化分类模型中进行训练,得到训练好的轻量化分类模型;将待评价样本图像输入至训练好的轻量化分类模型中,判断并输出待评价样本图像的所属类别。本申请的轻量化分类模型主干中的模型基本单元采用简洁的双分支结构,在增加模型基本单元数量的同时保留待评价样本图像数据的传递,使用输出通道数等于卷积组数的卷积层可以轻量化参数空间,模型的初始化宽度

基于预训练模型的长文本排序方法研究的开题报告.docx

基于预训练模型的长文本排序方法研究的开题报告一、选题背景随着互联网数据的日益增多,长文本排序成为信息检索和推荐系统中的热点问题。长文本排序是指将一个文本集合进行排序,使得某个问题的答案排在最前面。例如在搜索引擎中,当用户输入一个查询词时,排序算法通过计算查询词与文档之间的相似度,来为用户呈现合适的搜索结果。在推荐系统中,长文本排序被应用于推荐电商商品、新闻、音乐、视频等内容。长文本排序算法的性能往往决定了信息检索和推荐系统的效果和用户体验。目前,大部分的长文本排序算法都是基于传统机器学习方法,例如SVM、