音频信号处理方法及装置.pdf

萌运****魔王

亲,该文档总共24页,到这已经超出免费预览范围,如果喜欢就直接下载吧~

相关资料

音频信号处理方法、音频信号处理装置及存储介质.pdf

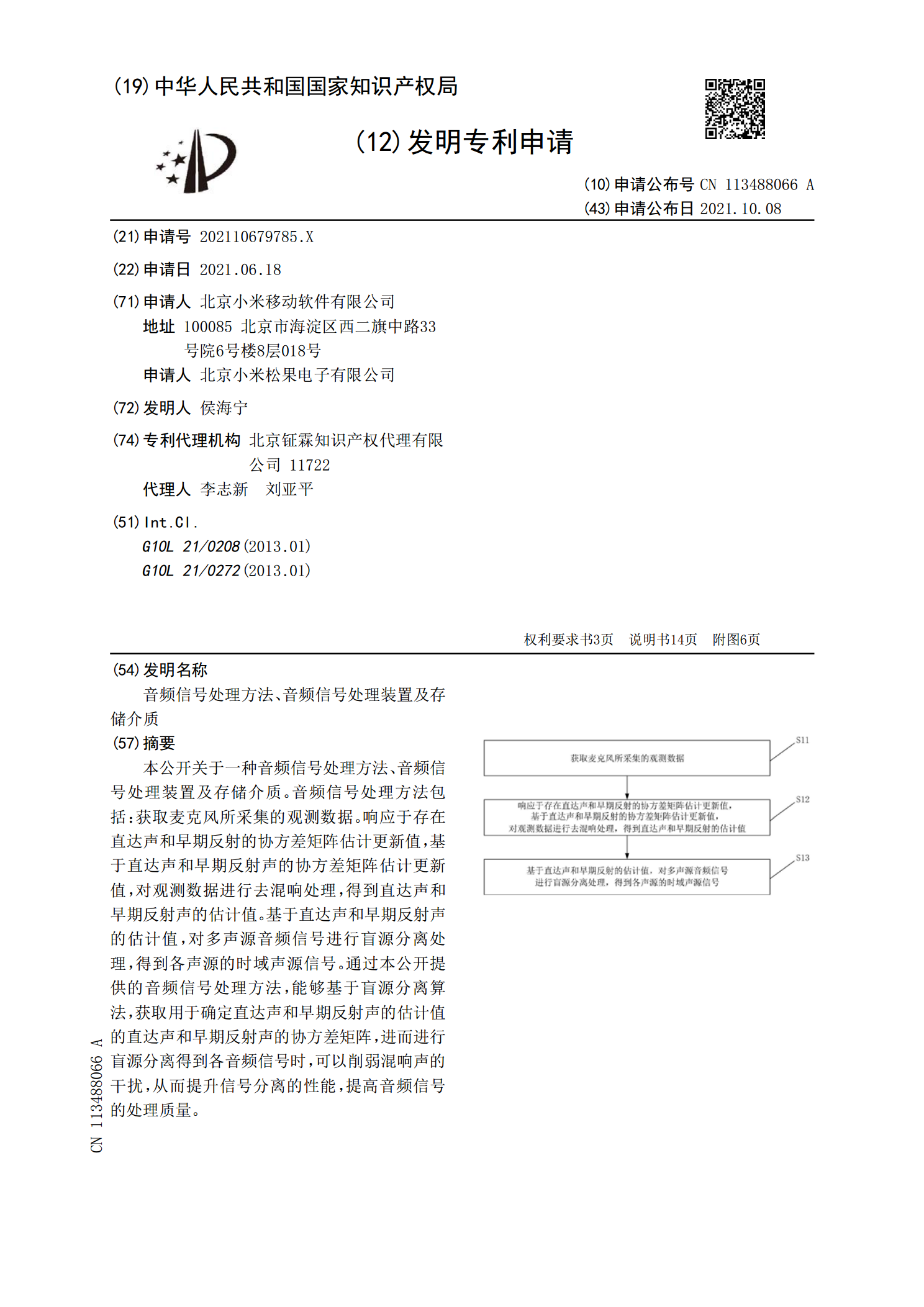

本公开关于一种音频信号处理方法、音频信号处理装置及存储介质。音频信号处理方法包括:获取麦克风所采集的观测数据。响应于存在直达声和早期反射的协方差矩阵估计更新值,基于直达声和早期反射声的协方差矩阵估计更新值,对观测数据进行去混响处理,得到直达声和早期反射声的估计值。基于直达声和早期反射声的估计值,对多声源音频信号进行盲源分离处理,得到各声源的时域声源信号。通过本公开提供的音频信号处理方法,能够基于盲源分离算法,获取用于确定直达声和早期反射声的估计值的直达声和早期反射声的协方差矩阵,进而进行盲源分离得到各音频

音频信号处理方法及装置.pdf

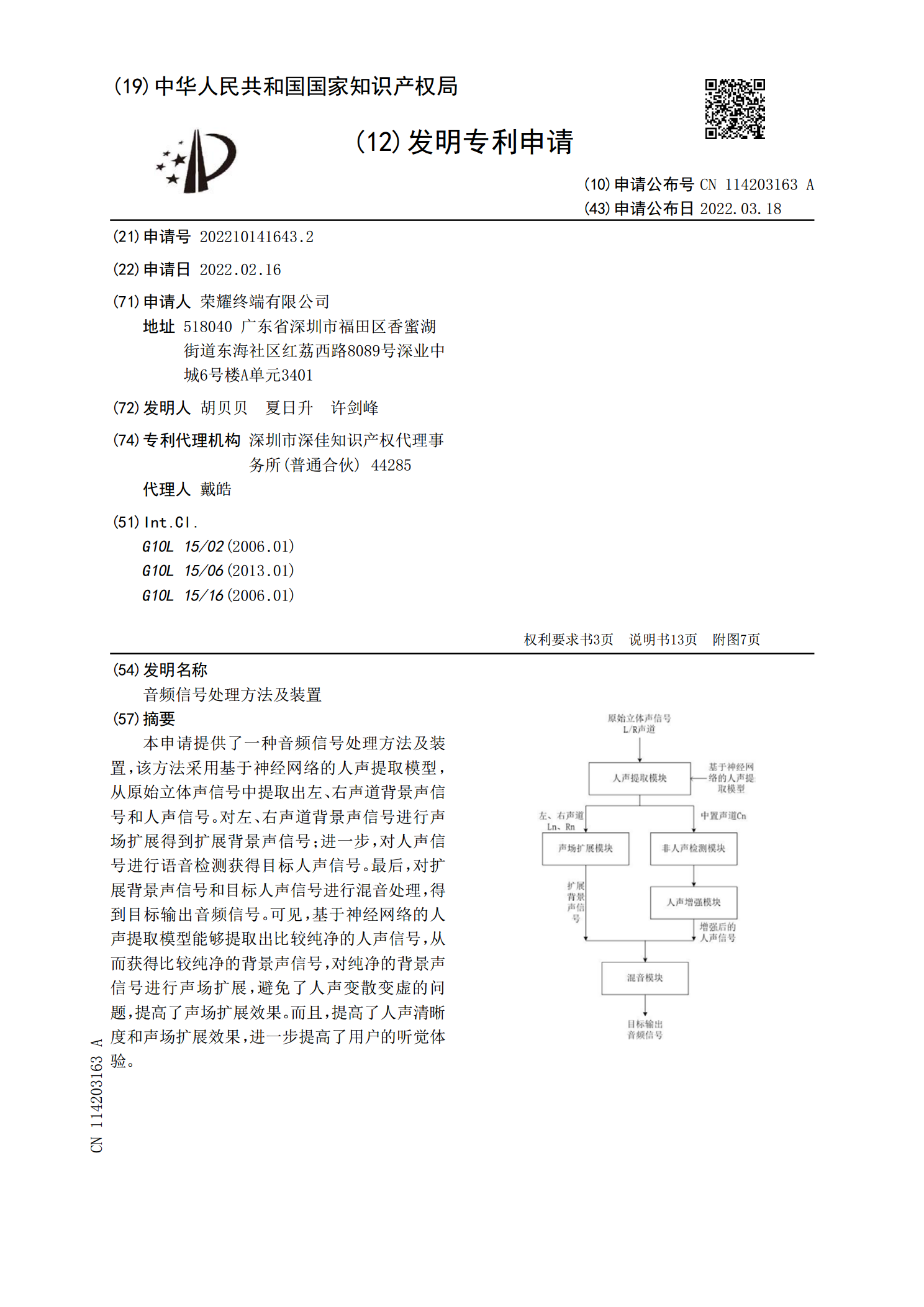

本申请提供了一种音频信号处理方法及装置,该方法采用基于神经网络的人声提取模型,从原始立体声信号中提取出左、右声道背景声信号和人声信号。对左、右声道背景声信号进行声场扩展得到扩展背景声信号;进一步,对人声信号进行语音检测获得目标人声信号。最后,对扩展背景声信号和目标人声信号进行混音处理,得到目标输出音频信号。可见,基于神经网络的人声提取模型能够提取出比较纯净的人声信号,从而获得比较纯净的背景声信号,对纯净的背景声信号进行声场扩展,避免了人声变散变虚的问题,提高了声场扩展效果。而且,提高了人声清晰度和声场扩展

音频信号处理方法及装置.pdf

本公开涉及空间音频技术领域,具体涉及一种音频信号处理方法及装置。一种音频信号处理方法,包括:获取穿戴设备发生转动时的第一转动信息以及与所述穿戴设备连接的移动设备发生转动时的第二转动信息;根据所述第一转动信息和所述第二转动信息,确定所述穿戴设备与所述移动设备的相对位置信息;根据所述相对位置信息对音频信号处理得到由所述穿戴设备播放的播放音频。本公开实施方式方法提高空间音频效果。

一种音频信号处理方法及音频信号处理装置.pdf

本发明公开了一种音频信号处理方法,包括:获取用户在运动过程中产生的步频参数;从终端中获取待处理的音频信号;根据步频参数对音频信号的节拍频率进行修改,使得修改后音频信号的节拍频率与步频参数之差小于预设阈值;输出修改后的音频信号。本发明还提供一种可以实现上述音频信号处理方法的终端。本发明能够保持音乐节拍频率与用户运动步频一致。

对音频信号处理的装置和对时域音频信号进行处理的方法.pdf

本文涉及对音频信号处理的装置和对时域音频信号进行处理的方法。一种用于对音频信号进行处理的装置包括:包括M个分析滤波器的低延迟抽选分析滤波器组,其中,M大于1,并且其中,M个分析滤波器基于长度为N的不对称原型滤波器p