基于帕累托优化的多目标强化学习方法和装置.pdf

是你****馨呀

亲,该文档总共14页,到这已经超出免费预览范围,如果喜欢就直接下载吧~

相关资料

基于帕累托优化的多目标强化学习方法和装置.pdf

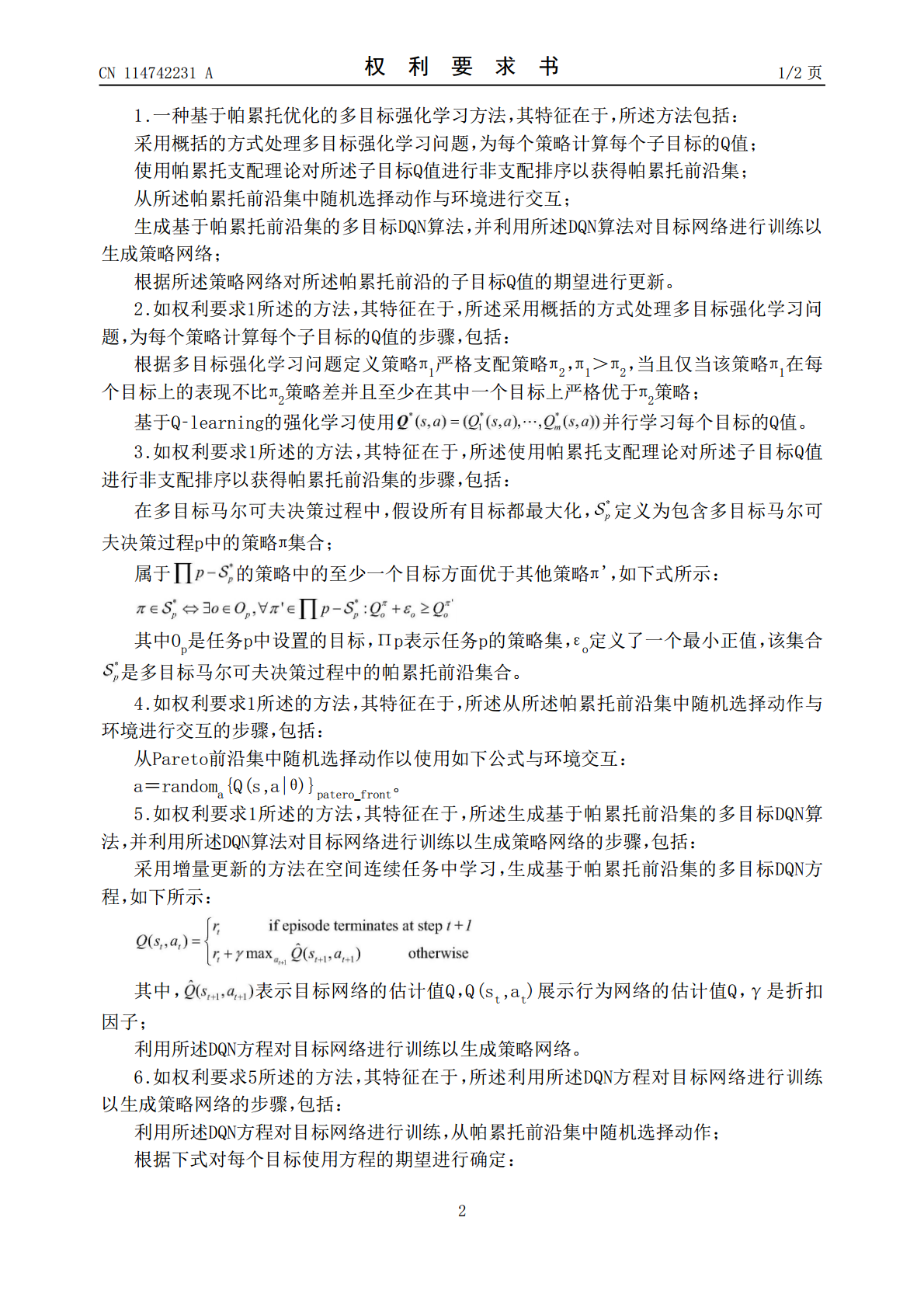

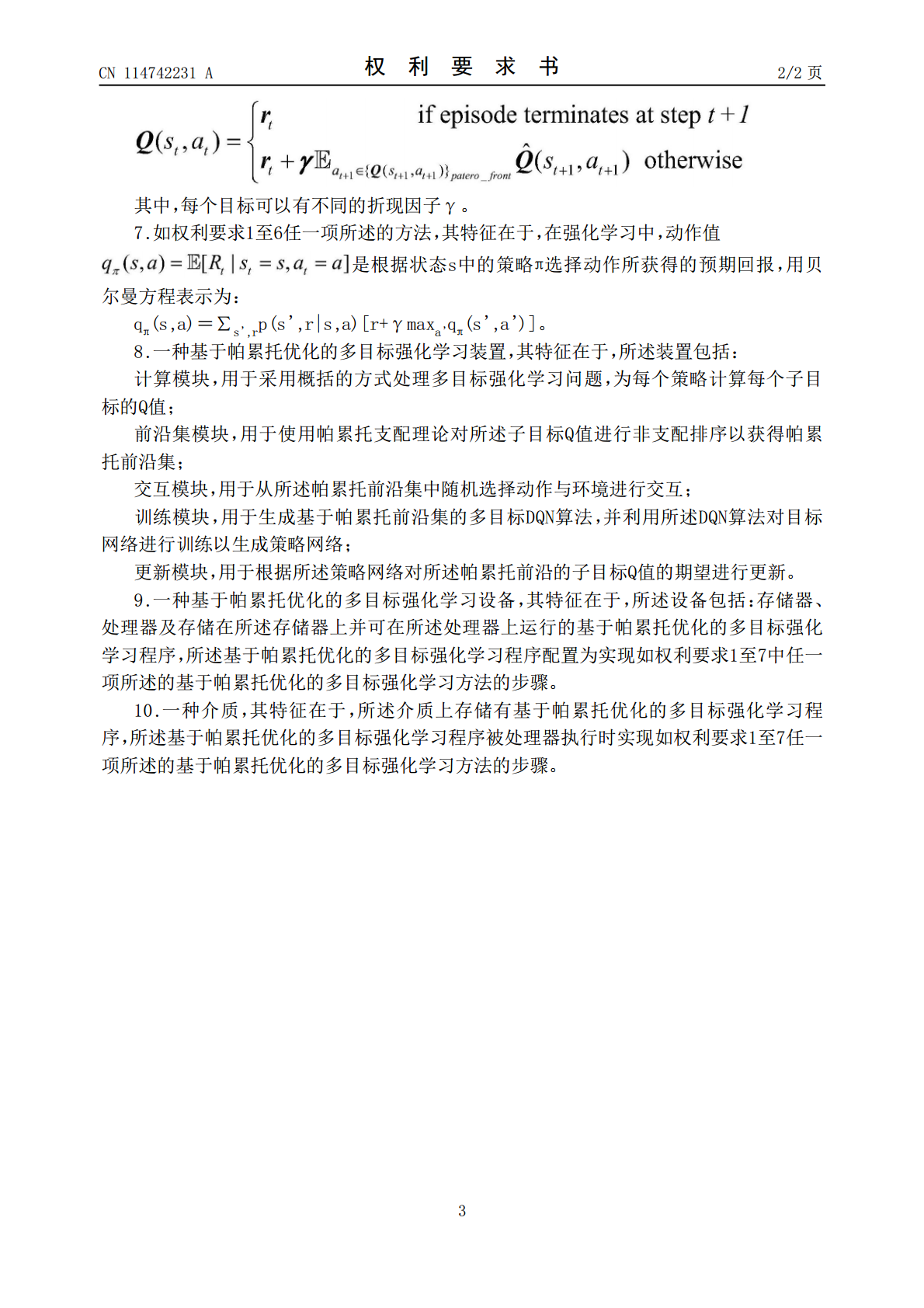

本发明涉及强化学习领域,公开了一种基于帕累托优化的多目标强化学习方法和装置,本发明通过采用概括的方式处理多目标强化学习问题,为每个策略计算每个子目标的Q值;使用帕累托支配理论对所述子目标Q值进行非支配排序以获得帕累托前沿集;从所述帕累托前沿集中随机选择动作与环境进行交互;生成基于帕累托前沿集的多目标DQN算法,并利用所述DQN算法对目标网络进行训练以生成策略网络;根据所述策略网络对所述帕累托前沿的子目标Q值的期望进行更新,通过将深度Q网络直接推广到多目标来逼近所有帕累托最优确定性策略的集合,表现出更好的性

基于帕累托优化的IES多目标运行优化方法.docx

基于帕累托优化的IES多目标运行优化方法基于帕累托优化的IES多目标运行优化方法摘要:随着能源消耗问题的日益严重,建筑能源管理变得越来越重要。能源模型以及相应的建筑系统是实现高效节能运行的关键因素之一。在过去的几十年里,建筑能源模型在智能建筑领域发挥着重要的作用,但是传统的能源优化方法常常以单一目标进行优化,缺乏考虑多目标的能力。本文介绍了一种基于帕累托优化的IES(IntelligentEnergySystem)多目标运行优化方法,旨在通过考虑多个目标函数,寻找建筑能源模型的非劣解集,从而实现能耗与室内

基于帕累托优化的IES多目标运行优化方法的任务书.docx

基于帕累托优化的IES多目标运行优化方法的任务书任务书:基于帕累托优化的IES多目标运行优化方法背景介绍:建筑节能对于减少能源消耗,提高生态环境质量,缓解能源供需矛盾,具有重要的意义。目前,建筑节能有两个主要方面:一是设计节能,即在建筑设计阶段就通过分析与计算,设计出能满足基本的节能标准的建筑;二是运行节能,即建筑的实际运行过程中采取的各种管理与技术手段来控制室内环境和能源消耗,从而降低建筑能耗和运行成本。在运行节能方面,建筑的实际运行条件往往有着复杂的非线性关系,同时涉及到多个目标优化问题,如保持室内环

基于帕累托最优的电力CPS多目标防御策略研究.docx

基于帕累托最优的电力CPS多目标防御策略研究基于帕累托最优的电力CPS多目标防御策略研究摘要:随着信息技术和电力系统的融合发展,电力网络逐渐进化为电力物联网,也被称为电力Cyber-PhysicalSystem(CPS)。然而,电力CPS的安全问题成为一个日益严峻的挑战。为了应对这些安全威胁,本文提出了一种基于帕累托最优的电力CPS多目标防御策略。通过综合考虑多个冲突的目标,该策略能够有效地提高电力CPS的安全性和鲁棒性。1.引言随着电力系统中的计算和通信技术的普及,电力CPS已经变得复杂且高度互联。然而

用于产品外形多目标优化设计的改进强度帕累托进化算法.pdf

本发明公开一种用于产品外形多目标优化设计的改进强度帕累托进化算法,包括设计分析和产品外形多目标优化设计,包含产品外形数据和产品感性意象数据,采用椭圆傅立叶分析技术获取产品外形轮廓主成分得分数据,用感性意象分析技术得到目标形容词感性意象评价均值数据;产品外形多目标优化设计部分算法步骤为,用遗传算法优化神经网络技术建立主成分得分和目标形容词的感性意象评价均值之间的非线性映射网络,利用椭圆傅立叶分析技术获得的主成分得分和目标形容词的感性意象评价均值之间的一致性相关关系提出修正算子,将该算子与改进交叉算子和改进自