多任务联邦学习系统中设备调度方法.pdf

一吃****昕靓

亲,该文档总共21页,到这已经超出免费预览范围,如果喜欢就直接下载吧~

相关资料

多任务联邦学习系统中设备调度方法.pdf

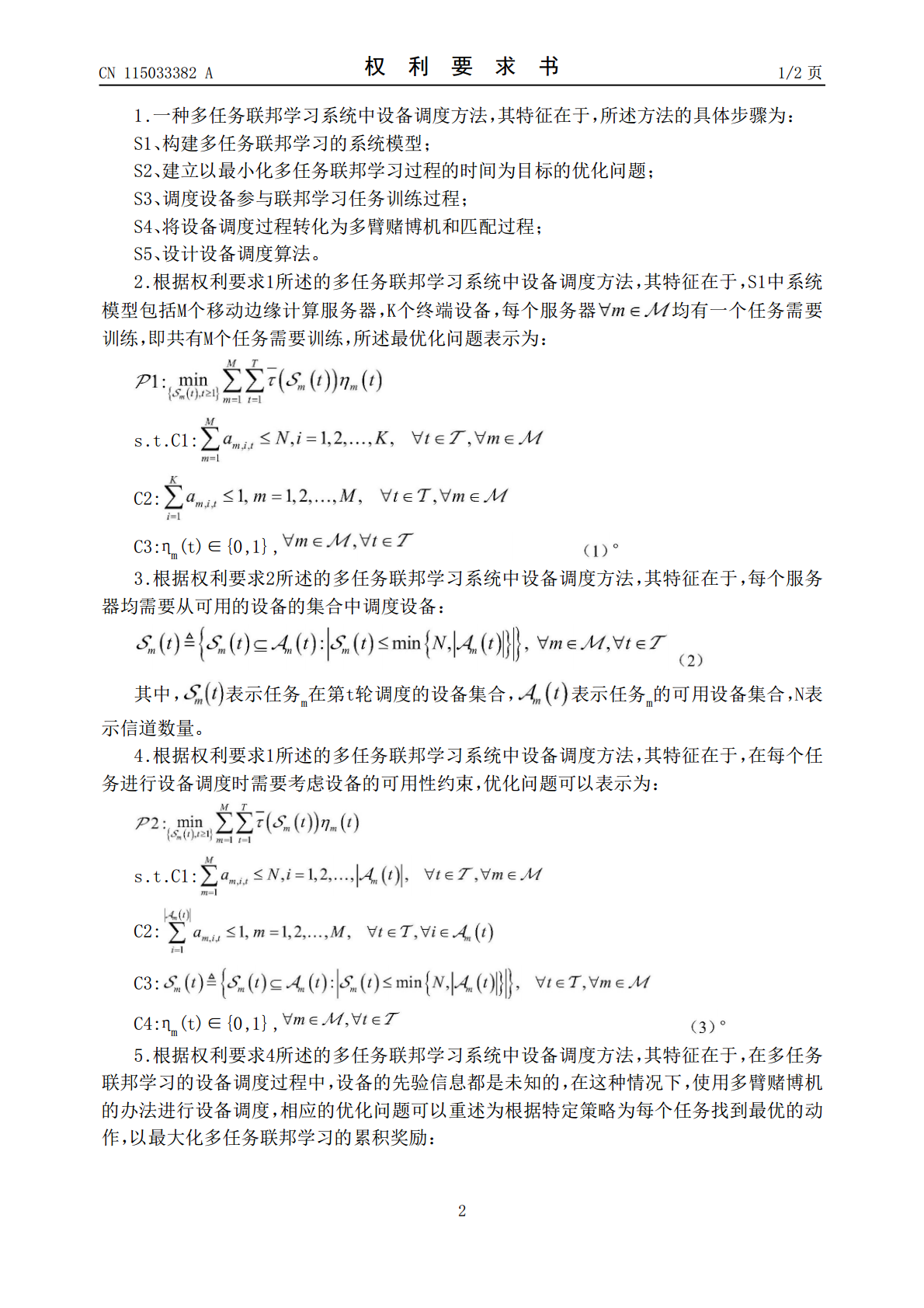

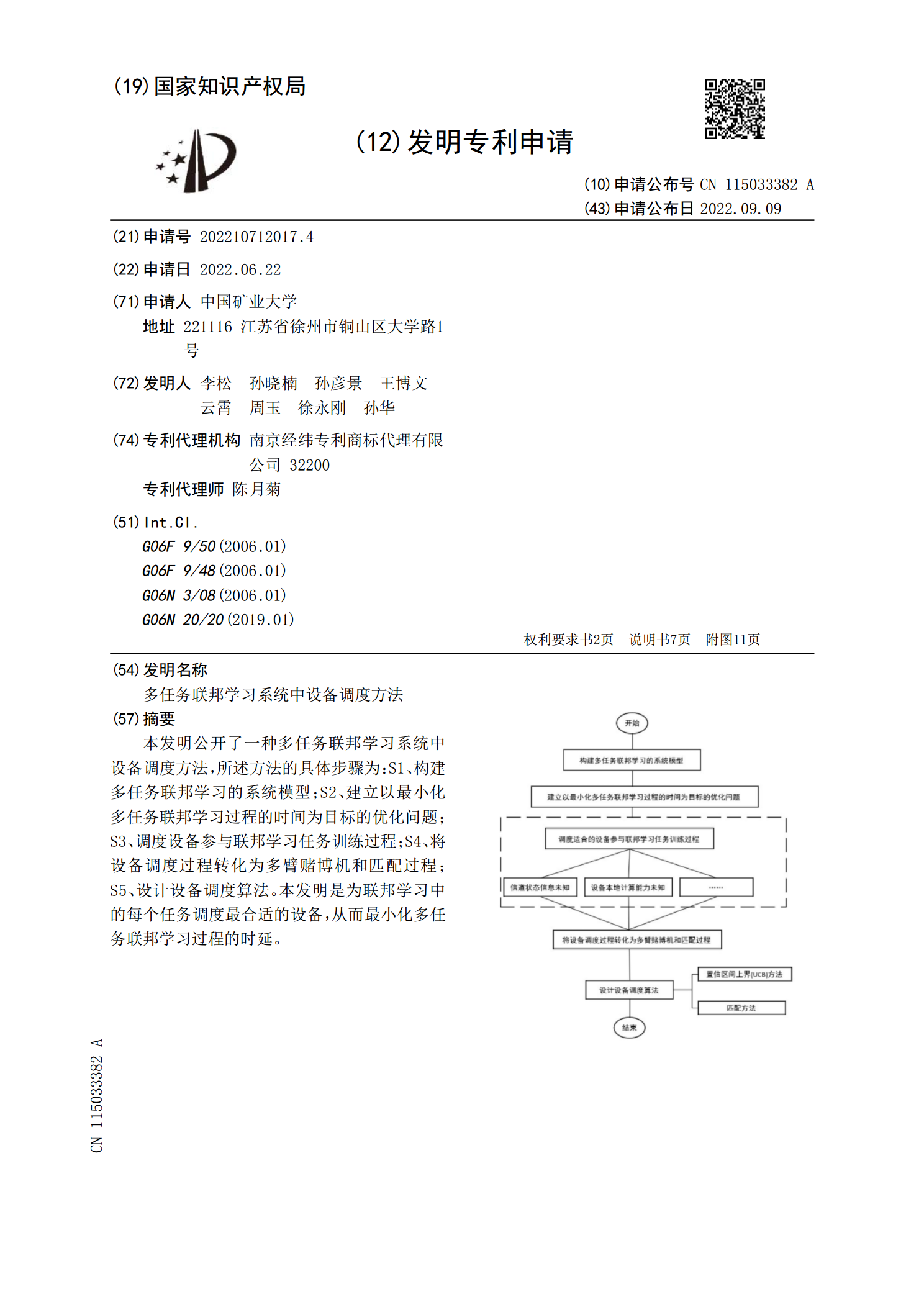

本发明公开了一种多任务联邦学习系统中设备调度方法,所述方法的具体步骤为:S1、构建多任务联邦学习的系统模型;S2、建立以最小化多任务联邦学习过程的时间为目标的优化问题;S3、调度设备参与联邦学习任务训练过程;S4、将设备调度过程转化为多臂赌博机和匹配过程;S5、设计设备调度算法。本发明是为联邦学习中的每个任务调度最合适的设备,从而最小化多任务联邦学习过程的时延。

联邦学习方法、联邦学习装置及联邦学习系统.pdf

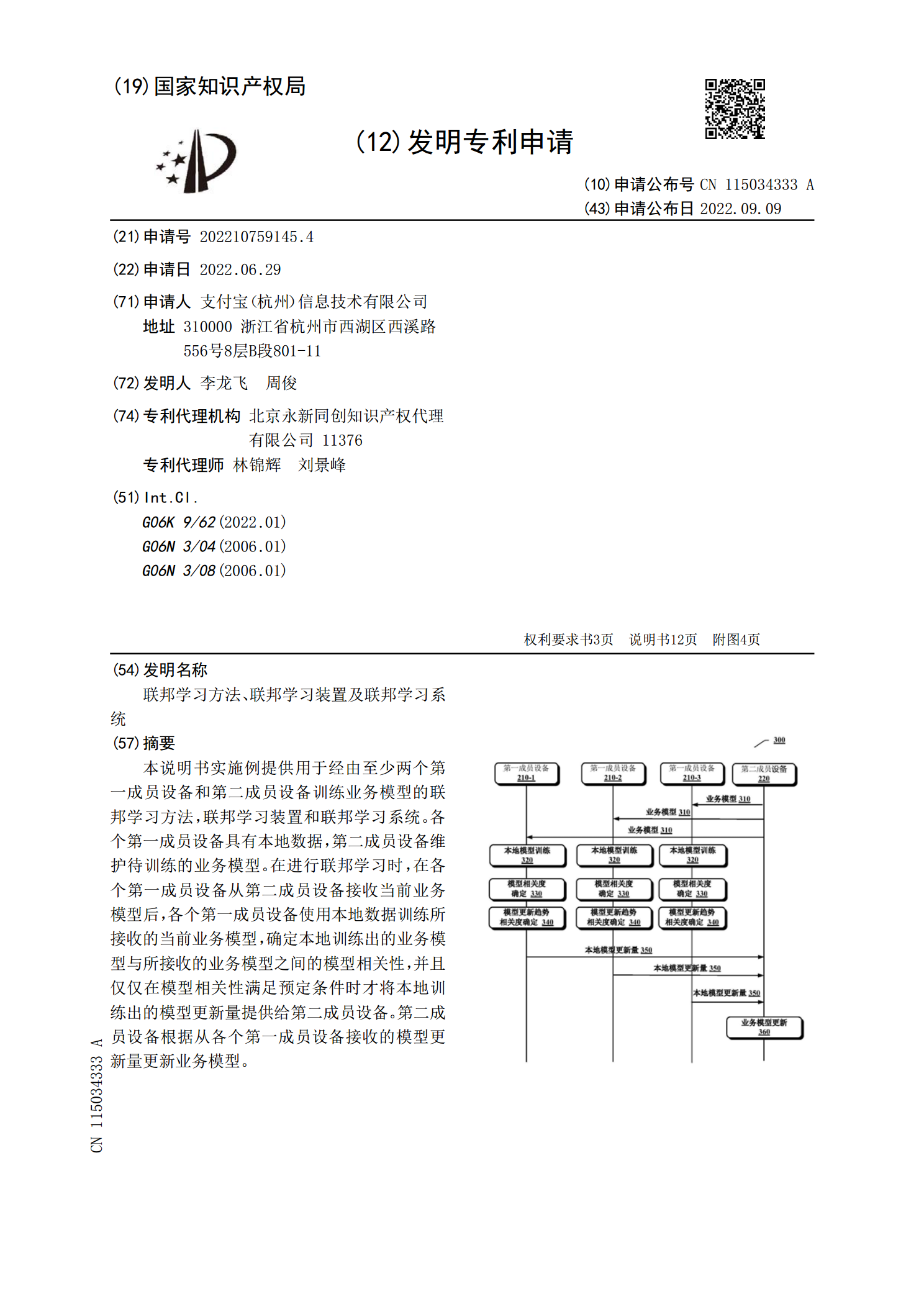

本说明书实施例提供用于经由至少两个第一成员设备和第二成员设备训练业务模型的联邦学习方法,联邦学习装置和联邦学习系统。各个第一成员设备具有本地数据,第二成员设备维护待训练的业务模型。在进行联邦学习时,在各个第一成员设备从第二成员设备接收当前业务模型后,各个第一成员设备使用本地数据训练所接收的当前业务模型,确定本地训练出的业务模型与所接收的业务模型之间的模型相关性,并且仅仅在模型相关性满足预定条件时才将本地训练出的模型更新量提供给第二成员设备。第二成员设备根据从各个第一成员设备接收的模型更新量更新业务模型。

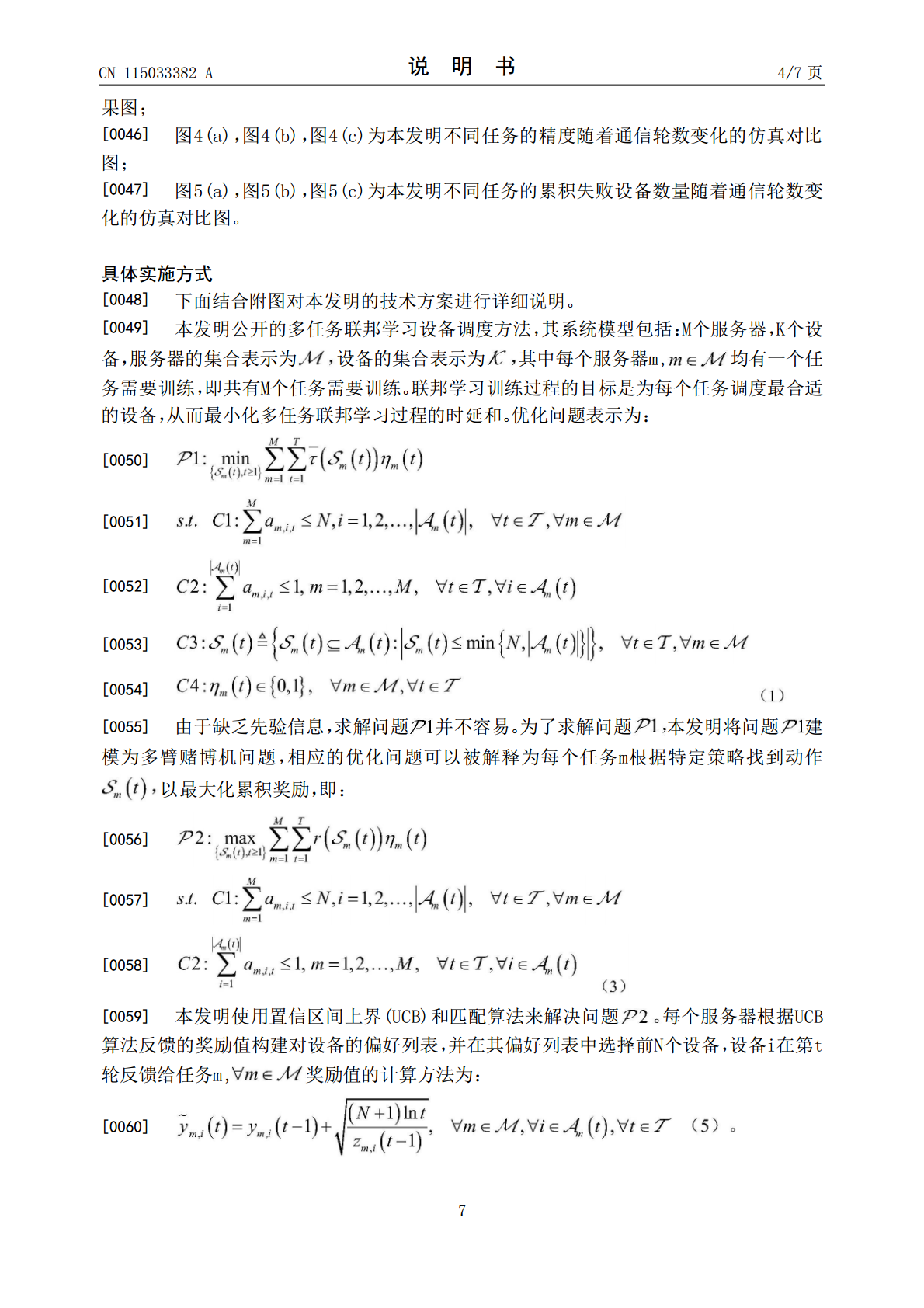

联邦学习方法、联邦学习装置及联邦学习系统.pdf

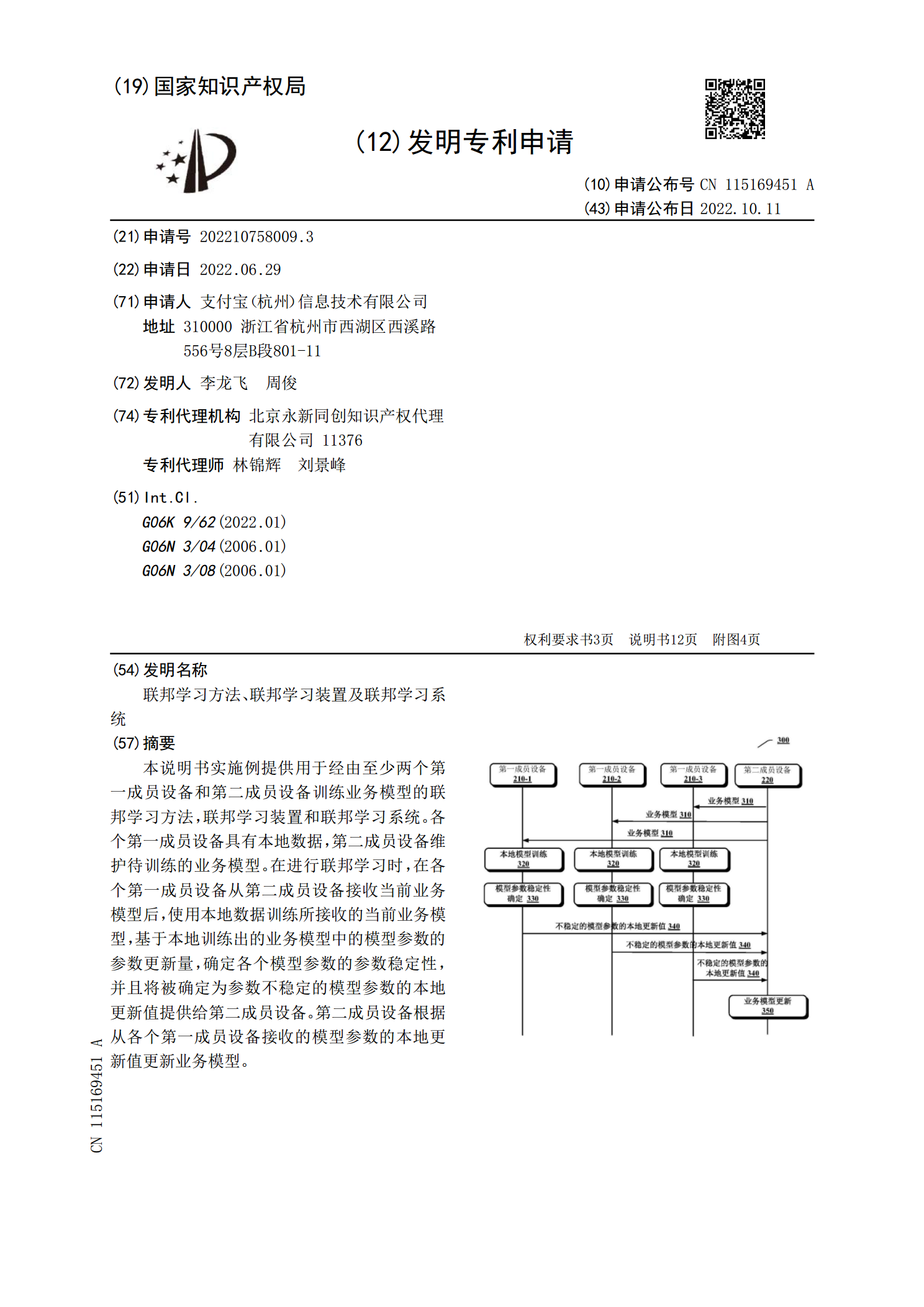

本说明书实施例提供用于经由至少两个第一成员设备和第二成员设备训练业务模型的联邦学习方法,联邦学习装置和联邦学习系统。各个第一成员设备具有本地数据,第二成员设备维护待训练的业务模型。在进行联邦学习时,在各个第一成员设备从第二成员设备接收当前业务模型后,使用本地数据训练所接收的当前业务模型,基于本地训练出的业务模型中的模型参数的参数更新量,确定各个模型参数的参数稳定性,并且将被确定为参数不稳定的模型参数的本地更新值提供给第二成员设备。第二成员设备根据从各个第一成员设备接收的模型参数的本地更新值更新业务模型。

联邦学习方法、装置及联邦学习系统.pdf

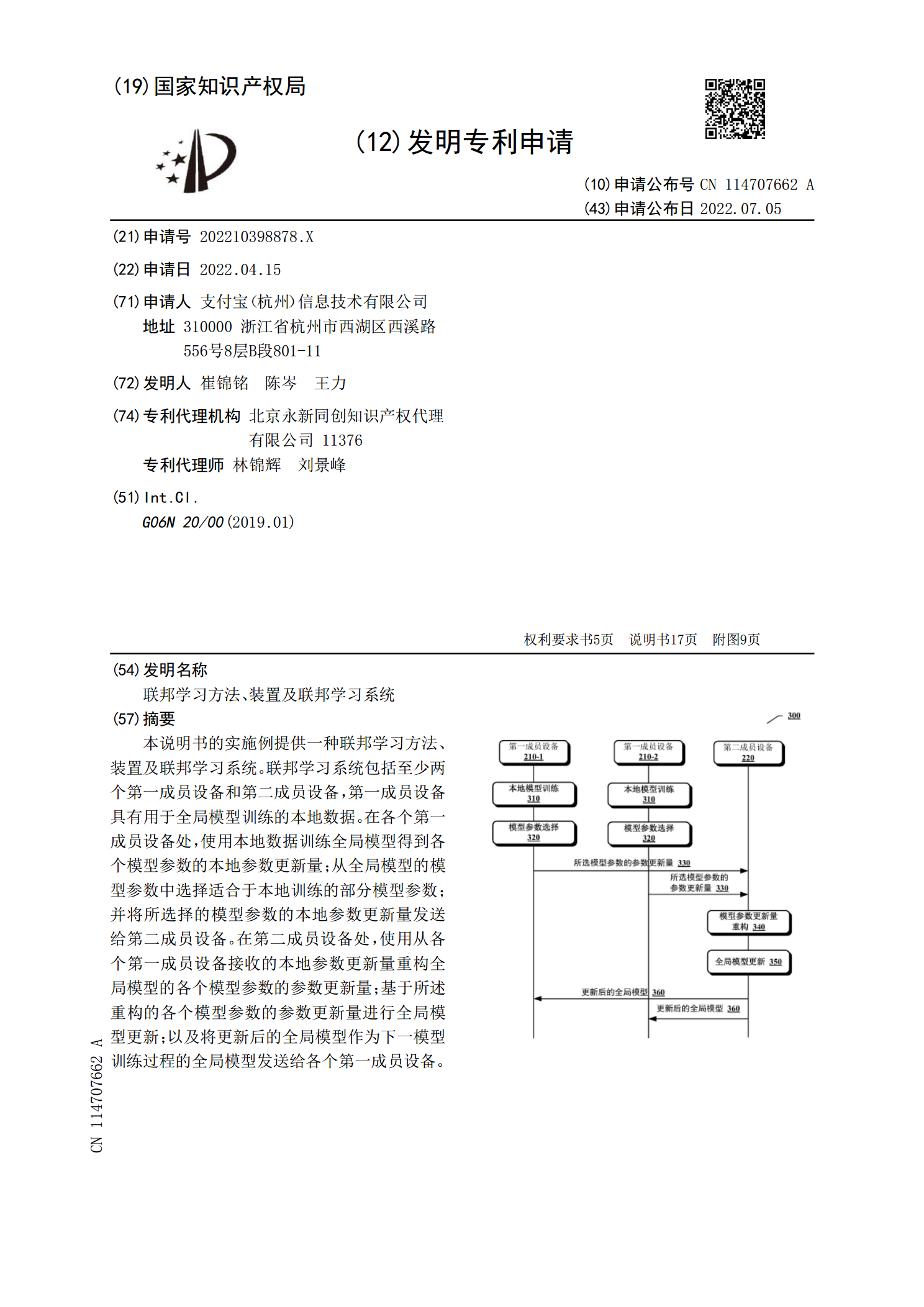

本说明书的实施例提供一种联邦学习方法、装置及联邦学习系统。联邦学习系统包括至少两个第一成员设备和第二成员设备,第一成员设备具有用于全局模型训练的本地数据。在各个第一成员设备处,使用本地数据训练全局模型得到各个模型参数的本地参数更新量;从全局模型的模型参数中选择适合于本地训练的部分模型参数;并将所选择的模型参数的本地参数更新量发送给第二成员设备。在第二成员设备处,使用从各个第一成员设备接收的本地参数更新量重构全局模型的各个模型参数的参数更新量;基于所述重构的各个模型参数的参数更新量进行全局模型更新;以及将更

多任务调度方法、装置、设备以及存储介质.pdf

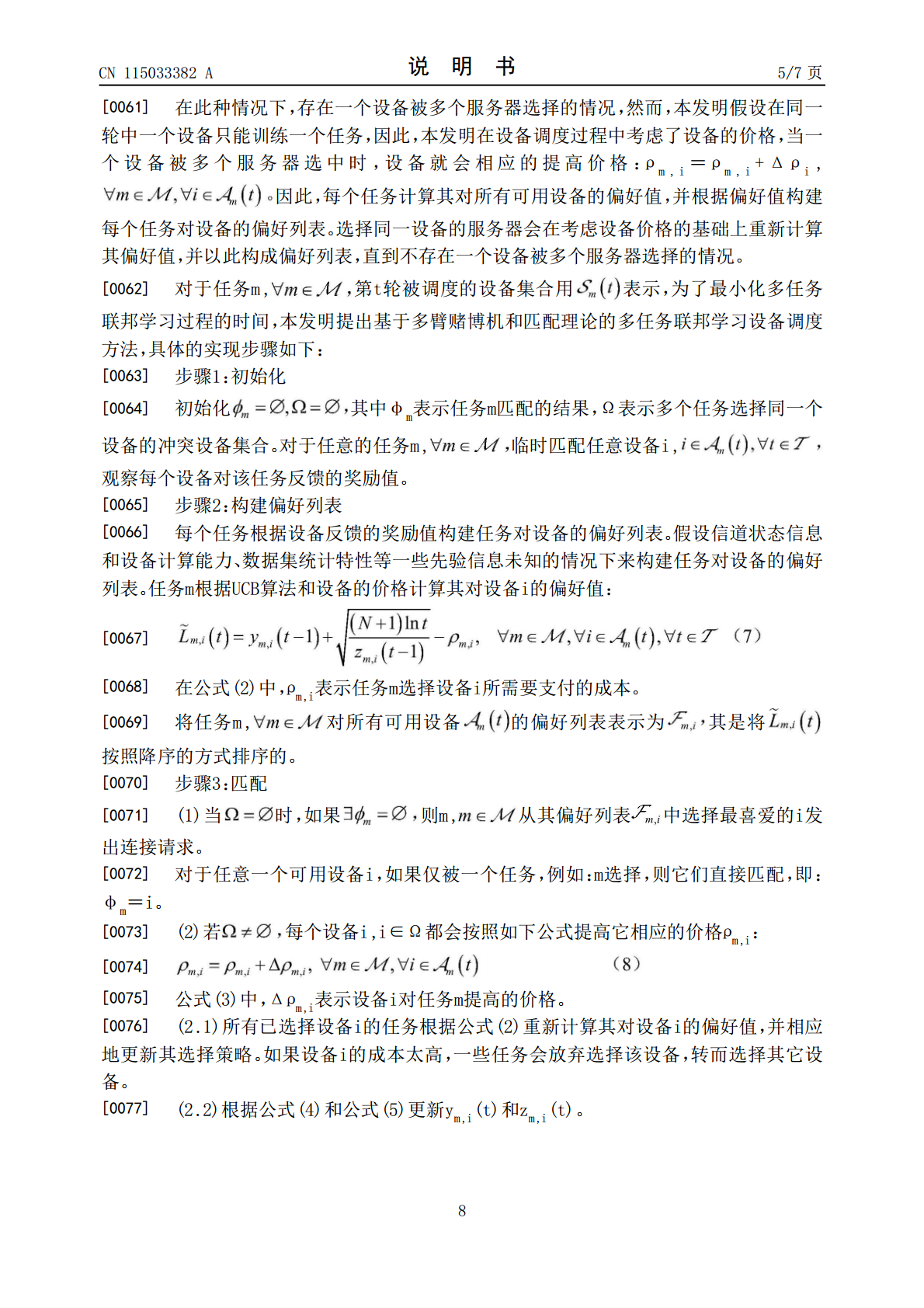

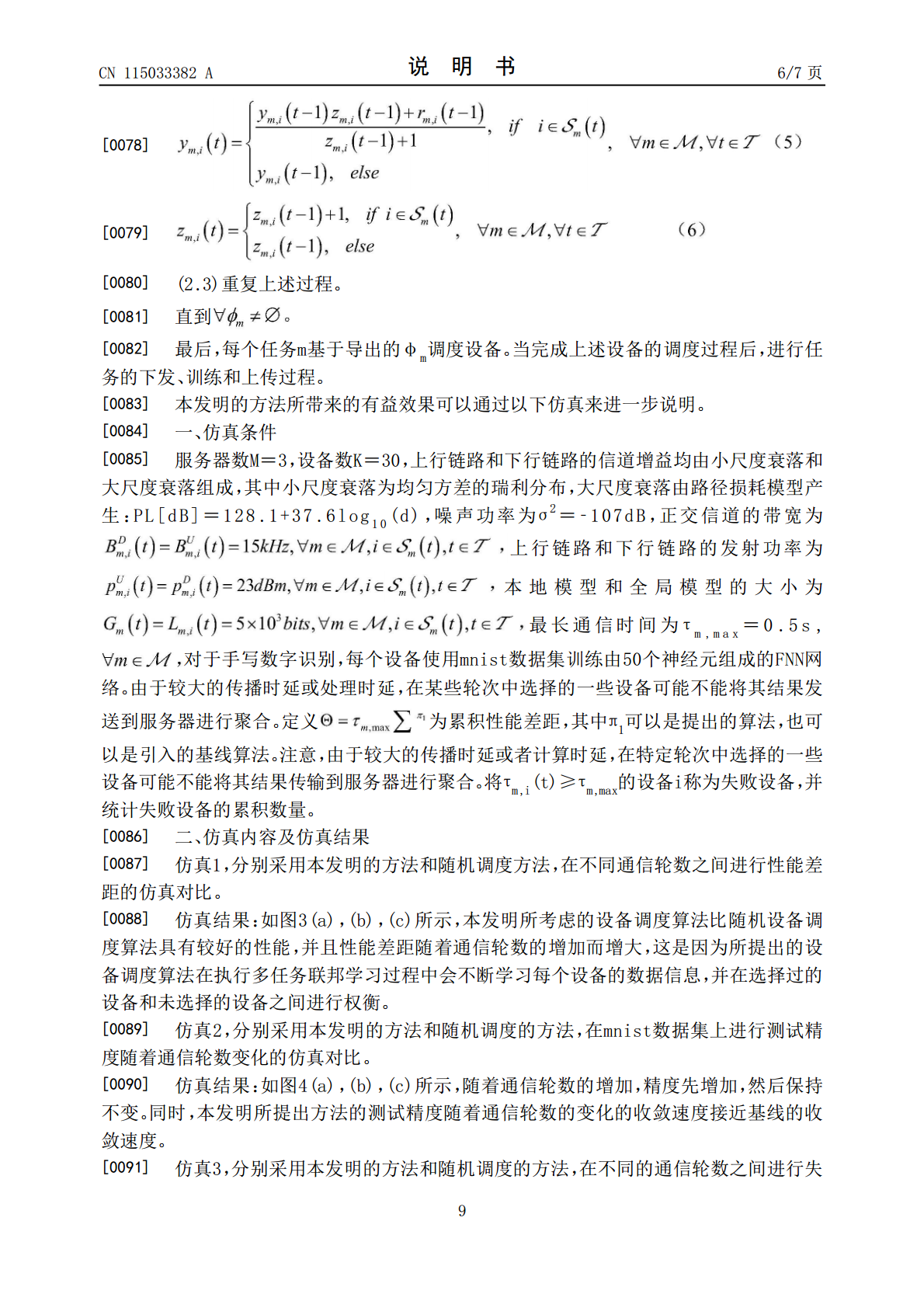

本公开提供了一种多任务调度方法、装置、设备以及存储介质,涉及人工智能领域中的分布式计算技术。该方法包括:初始化候选调度方案列表,其中,候选调度方案用于为多个机器学习任务中的每个机器学习任务分配用于训练的终端设备;对于候选调度方案列表中的每个候选调度方案,对候选调度方案进行扰动,生成新的调度方案;基于候选调度方案的适应值以及新的调度方案的适应值,确定是否以新的调度方案替换候选调度方案,生成新的调度方案列表;基于新的调度方案列表中的每个新的调度方案的适应值,确定目标调度方案。本公开提供的多任务调度方法提高了服