一种基于Hadoop的并行关联规则算法.pdf

qw****27

在线预览结束,喜欢就下载吧,查找使用更方便

相关资料

一种基于Hadoop的并行关联规则算法.pdf

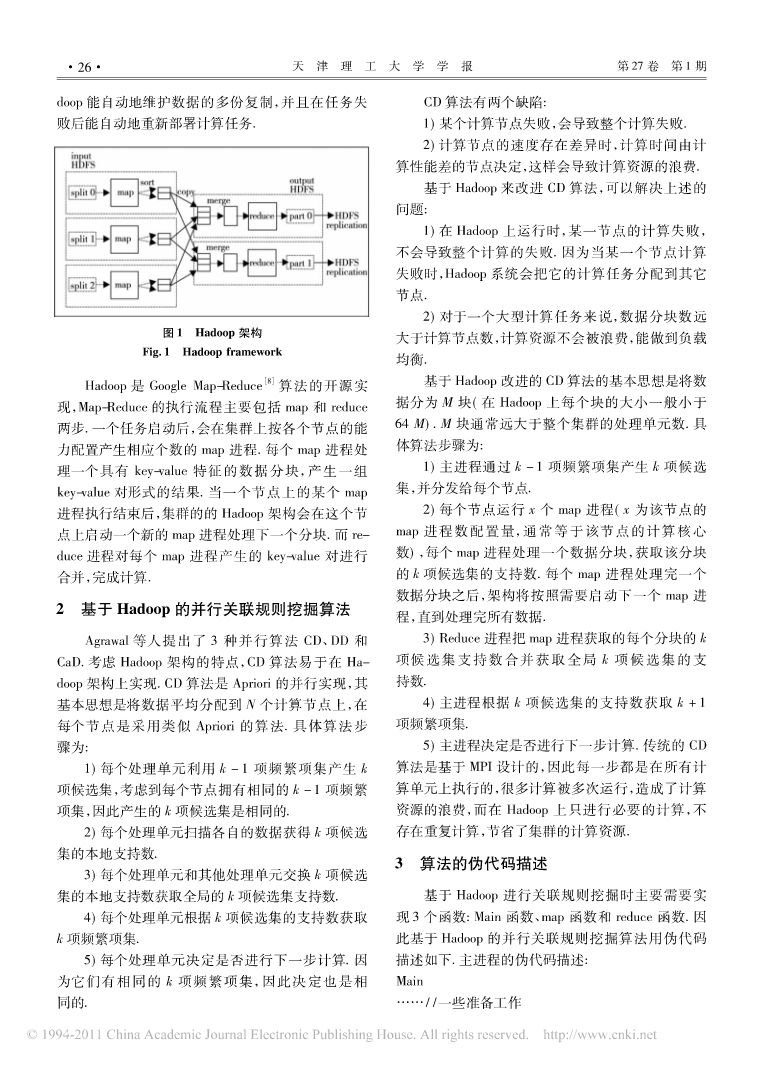

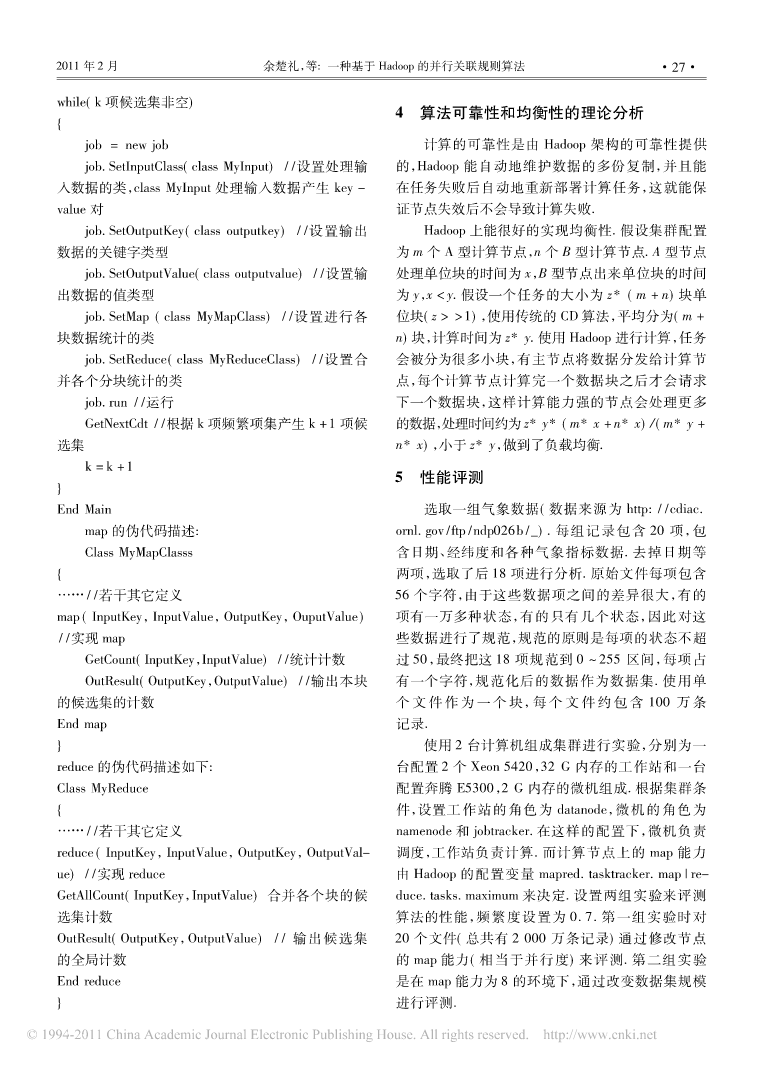

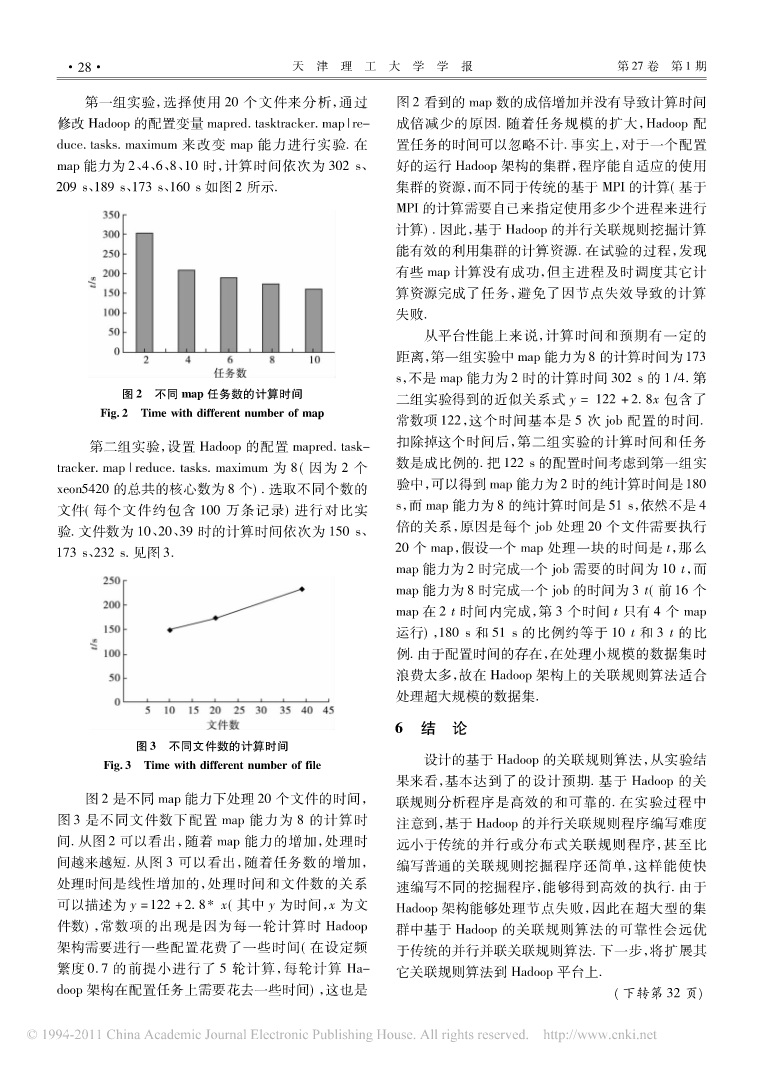

第27卷第1期天津理工大学学报Vol.27No.12011年2月JOURNALOFTIANJINUNIVERSITYOFTECHNOLOGYFeB.2011文章编号:1673-095X(2011)01-0025-04一种基于Hadoop的并行关联规则算法余楚礼1,肖迎元1,尹波2(1.天津理工大学计算机与通信工程学院,天津300384;2.21世纪恒丰环保节能工程有限公司,天津300384)摘要:在挖掘大型数据库的关联规则时,使用并行计算是必需的.针对传统的并行计算,存在不能处理节点失效,难以处理负载均衡

基于HADOOP平台的并行关联规则算法研究.docx

基于HADOOP平台的并行关联规则算法研究基于Hadoop平台的并行关联规则算法研究摘要关联规则算法是数据挖掘领域的重要算法之一,可以用于发现数据集中的关联关系。然而,随着数据规模的不断增大,传统的关联规则算法在效率和可扩展性方面面临着挑战。为了解决这一问题,本文基于Hadoop平台,研究了并行关联规则算法。首先,介绍了Hadoop平台的基本原理和特点。然后,详细阐述了关联规则算法的基本原理和实现过程。接着,提出了一种基于Hadoop平台的并行关联规则算法,包括数据预处理、数据划分和并行计算等步骤。最后,

基于Hadoop的FP-Growth关联规则并行改进算法.docx

基于Hadoop的FP-Growth关联规则并行改进算法摘要:随着数据量的不断增加和数据分析应用的迅速发展,寻找有效的挖掘方法和提高算法效率已经成为数据分析领域的热点问题。关联规则挖掘(AssociationRules)是其中一个热门领域,它通过寻找数据内部的相关性来进行数据分析和预测。在大数据时代,如何有效地进行关联规则挖掘成为一项挑战。本文提出了基于Hadoop的FP-Growth关联规则并行改进算法,通过利用Hadoop平台的分布式计算特性实现了对关联规则挖掘算法的优化,提升了算法效率。关键词:关联

基于Hadoop平台的并行关联规则挖掘算法研究综述报告.docx

基于Hadoop平台的并行关联规则挖掘算法研究综述报告随着大数据时代的到来,数据规模呈现出爆炸式增长。因此,如何高效地从海量的数据中挖掘有价值的信息已成为了人们所关注的焦点。关联规则挖掘是一种重要的数据挖掘方法,它能够发掘数据集中的有用关系和模式。在实际应用中,关联规则挖掘已经成为了数据挖掘领域最基础和最常用的技术之一。然而,在处理大规模数据时,传统的关联规则挖掘方法的效率很低。为了解决这个问题,学者们开始研究如何在Hadoop平台上进行并行化的关联规则挖掘算法。本文将对基于Hadoop平台的并行关联规则

一种基于Hadoop的关联规则挖掘算法.docx

一种基于Hadoop的关联规则挖掘算法随着社会和经济的快速发展,数据的规模和复杂性也在迅速增加。如何从海量的数据中获取有价值的信息,发掘出数据背后的隐藏规律,成为了数据挖掘领域面临的重要挑战之一。关联规则挖掘是数据挖掘领域中的一个重要分支,其可以从大规模数据集中发现不同特征之间的相关性。本文描述了一种基于Hadoop的关联规则挖掘算法,其使用分布式计算框架对大规模数据集进行分析和处理。一、介绍关联规则是指包含一个或多个项集的规则,表示这些项集之间存在着某种关系。例如,在一个超市的销售数据中,我们可以发现“