一种基于生成对抗网络端到端的模糊图像盲复原方法.pdf

一吃****春晓

亲,该文档总共15页,到这已经超出免费预览范围,如果喜欢就直接下载吧~

相关资料

一种基于生成对抗网络端到端的模糊图像盲复原方法.pdf

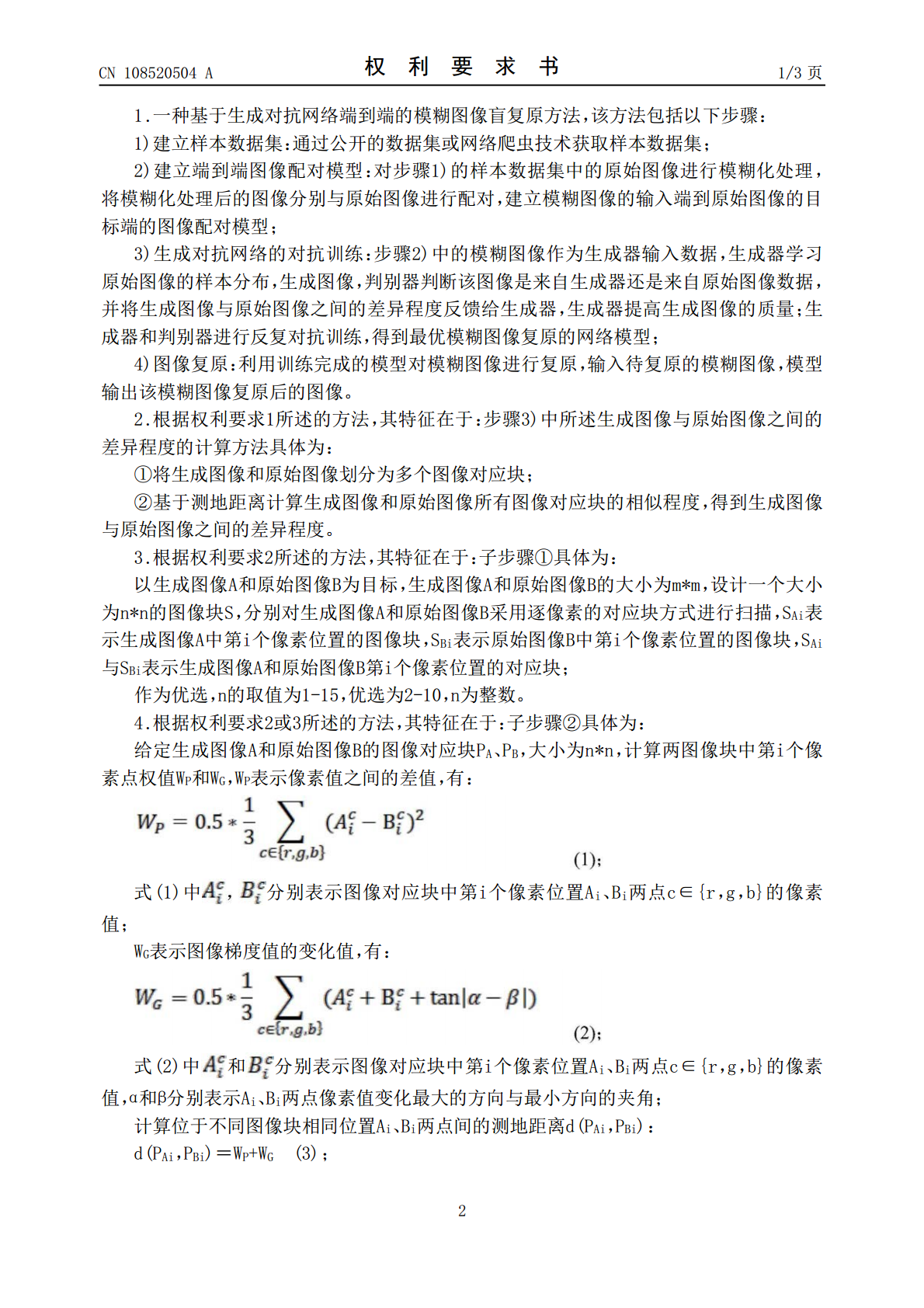

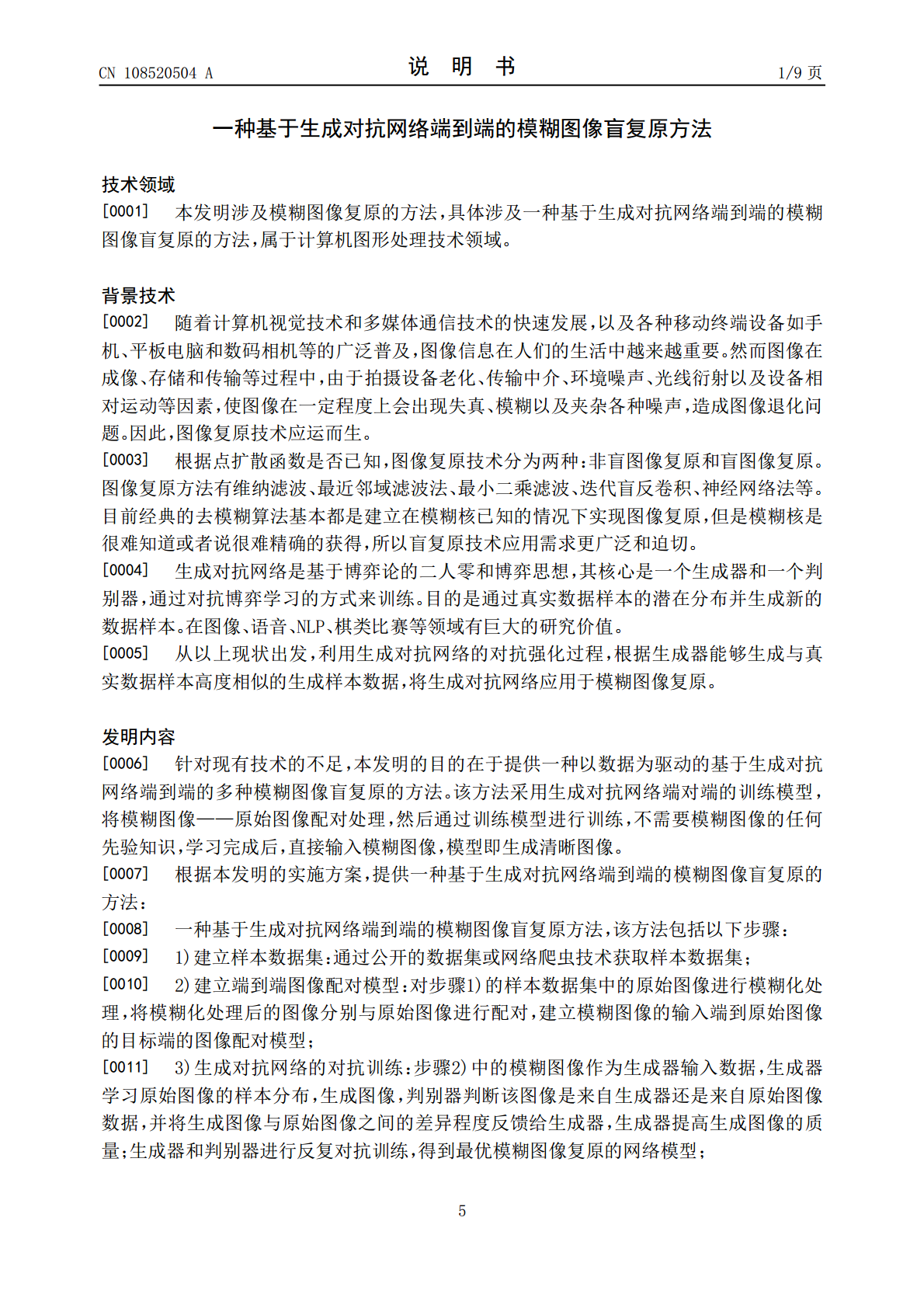

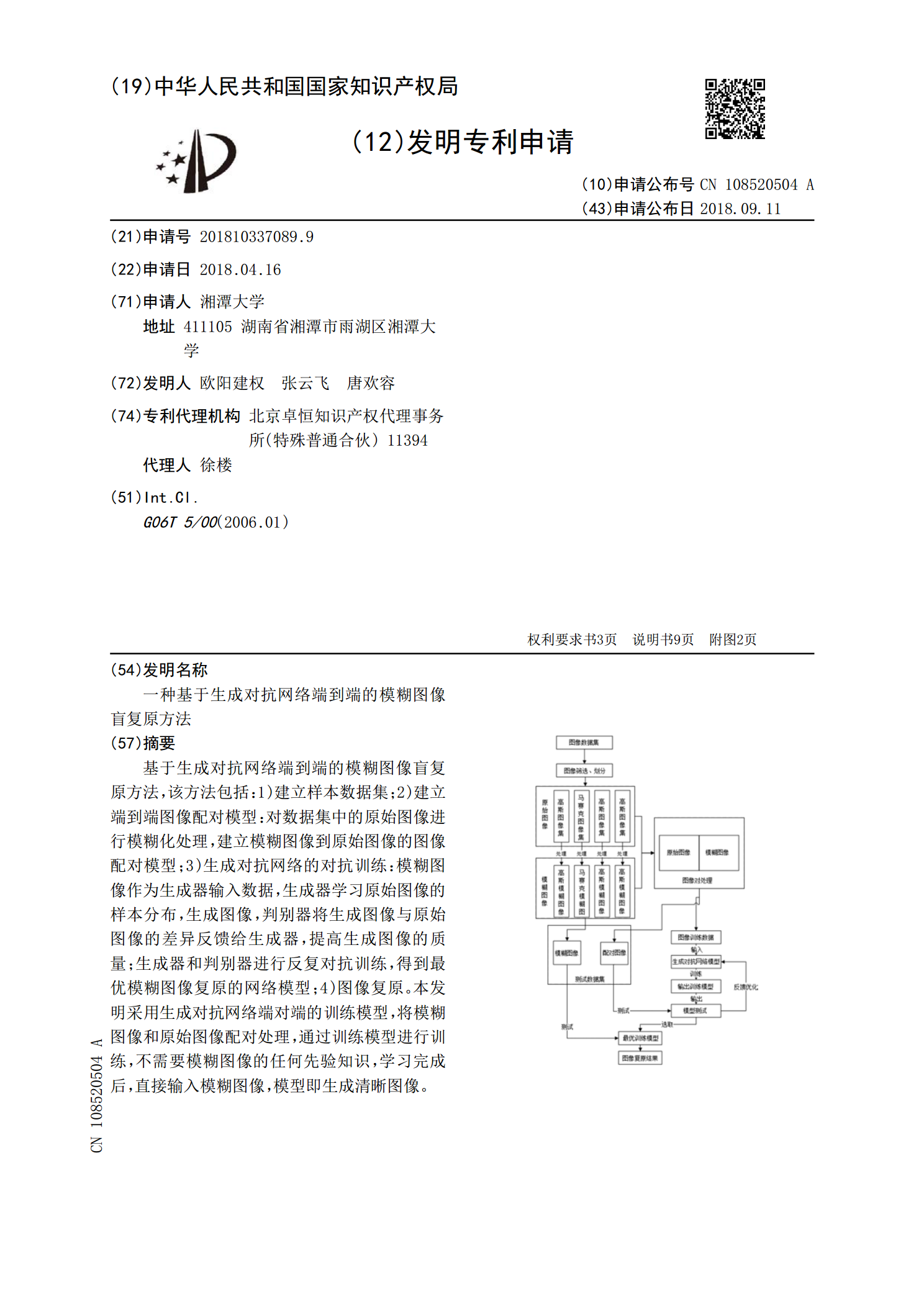

基于生成对抗网络端到端的模糊图像盲复原方法,该方法包括:1)建立样本数据集;2)建立端到端图像配对模型:对数据集中的原始图像进行模糊化处理,建立模糊图像到原始图像的图像配对模型;3)生成对抗网络的对抗训练:模糊图像作为生成器输入数据,生成器学习原始图像的样本分布,生成图像,判别器将生成图像与原始图像的差异反馈给生成器,提高生成图像的质量;生成器和判别器进行反复对抗训练,得到最优模糊图像复原的网络模型;4)图像复原。本发明采用生成对抗网络端对端的训练模型,将模糊图像和原始图像配对处理,通过训练模型进行训练,

一种基于改进生成对抗网络的模糊图像复原方法.pdf

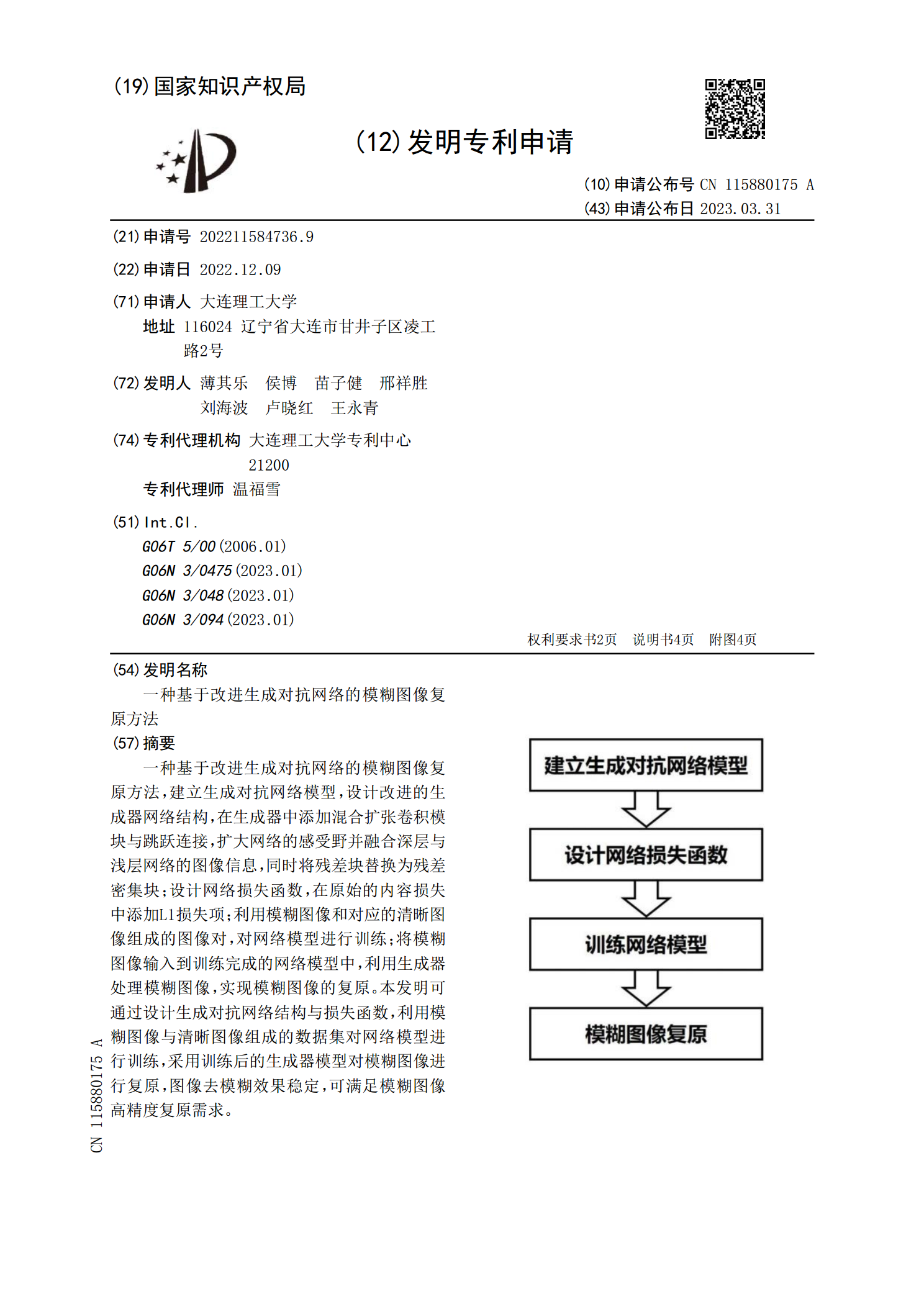

一种基于改进生成对抗网络的模糊图像复原方法,建立生成对抗网络模型,设计改进的生成器网络结构,在生成器中添加混合扩张卷积模块与跳跃连接,扩大网络的感受野并融合深层与浅层网络的图像信息,同时将残差块替换为残差密集块;设计网络损失函数,在原始的内容损失中添加L1损失项;利用模糊图像和对应的清晰图像组成的图像对,对网络模型进行训练;将模糊图像输入到训练完成的网络模型中,利用生成器处理模糊图像,实现模糊图像的复原。本发明可通过设计生成对抗网络结构与损失函数,利用模糊图像与清晰图像组成的数据集对网络模型进行训练,采用

一种基于生成对抗网络的图像盲去模糊方法.pdf

本发明提供一种基于生成对抗网络的图像盲去模糊方法。本发明首先建立用于网络训练的损失函数,包括对抗损失项(AdversarialLoss)和内容损失项(ContentLoss);然后进行生成对抗网络结构的搭建;再采用基于随机轨迹的的运动模糊数据集生成方法,生成清晰‑模糊图像对;最后采用生成的清晰‑模糊图像对,训练生成对抗网络网络。本发明在低计算资源消耗的情况下,能做到相对较快的图像去模糊速度,并明显快于其他去模糊方法,本发明提出了一种基于随机轨迹的运动模糊数据集生成方法,可以任意生成大量的清晰‑模糊图像

基于多流注意对抗网络的动态场景模糊图像盲复原方法.pdf

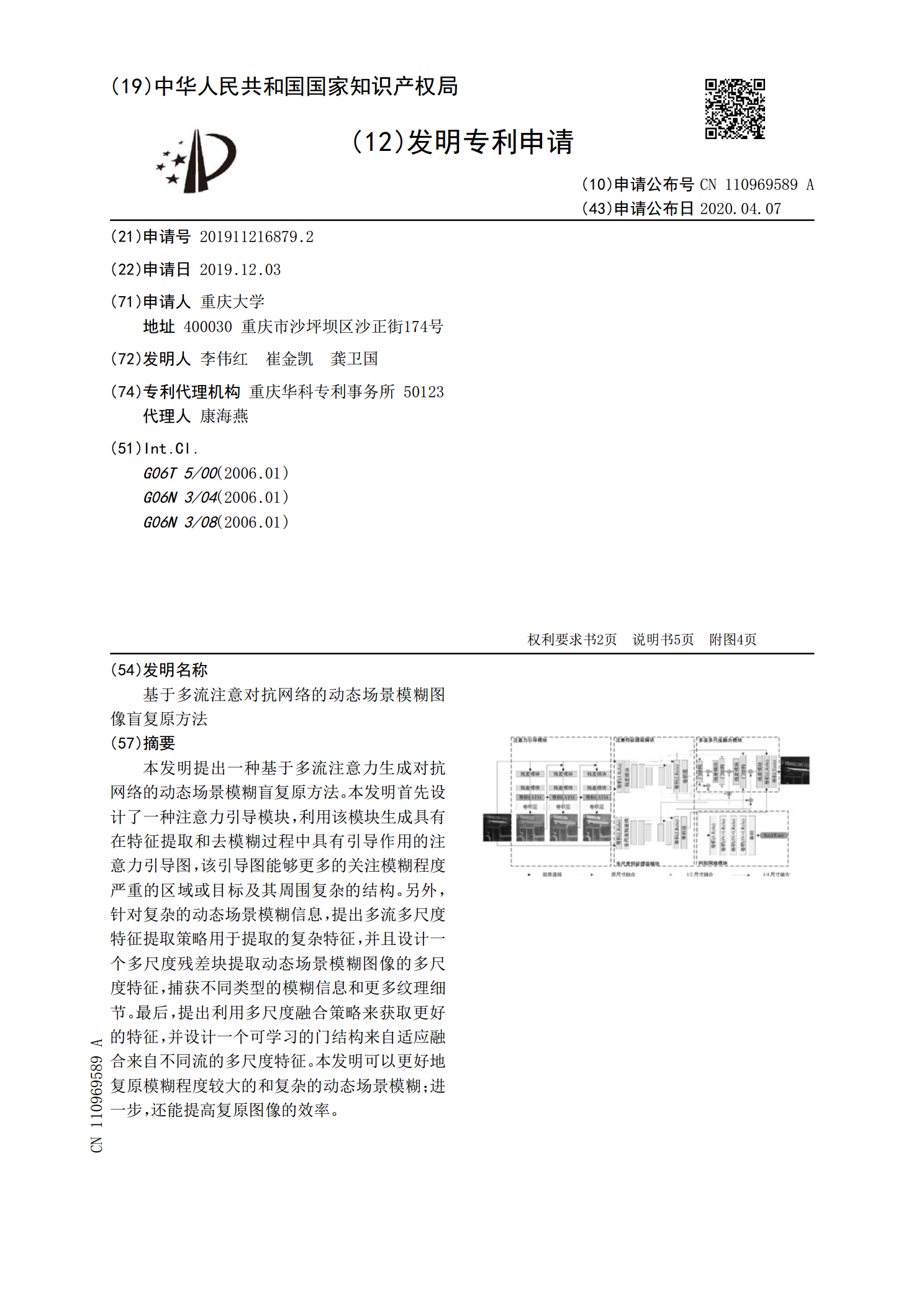

本发明提出一种基于多流注意力生成对抗网络的动态场景模糊盲复原方法。本发明首先设计了一种注意力引导模块,利用该模块生成具有在特征提取和去模糊过程中具有引导作用的注意力引导图,该引导图能够更多的关注模糊程度严重的区域或目标及其周围复杂的结构。另外,针对复杂的动态场景模糊信息,提出多流多尺度特征提取策略用于提取的复杂特征,并且设计一个多尺度残差块提取动态场景模糊图像的多尺度特征,捕获不同类型的模糊信息和更多纹理细节。最后,提出利用多尺度融合策略来获取更好的特征,并设计一个可学习的门结构来自适应融合来自不同流的多

一种基于生成对抗网络的图像运动模糊盲去除方法.pdf

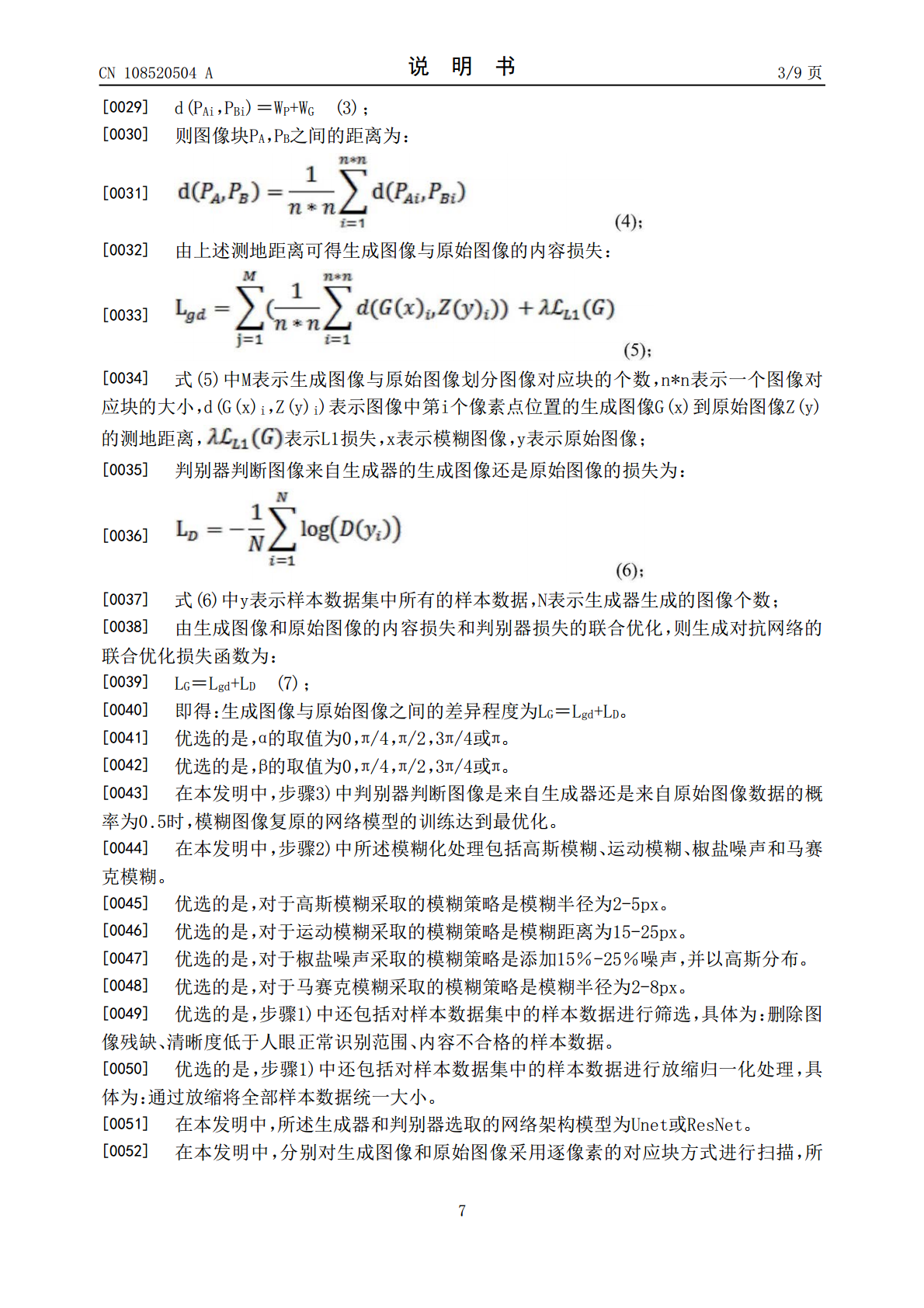

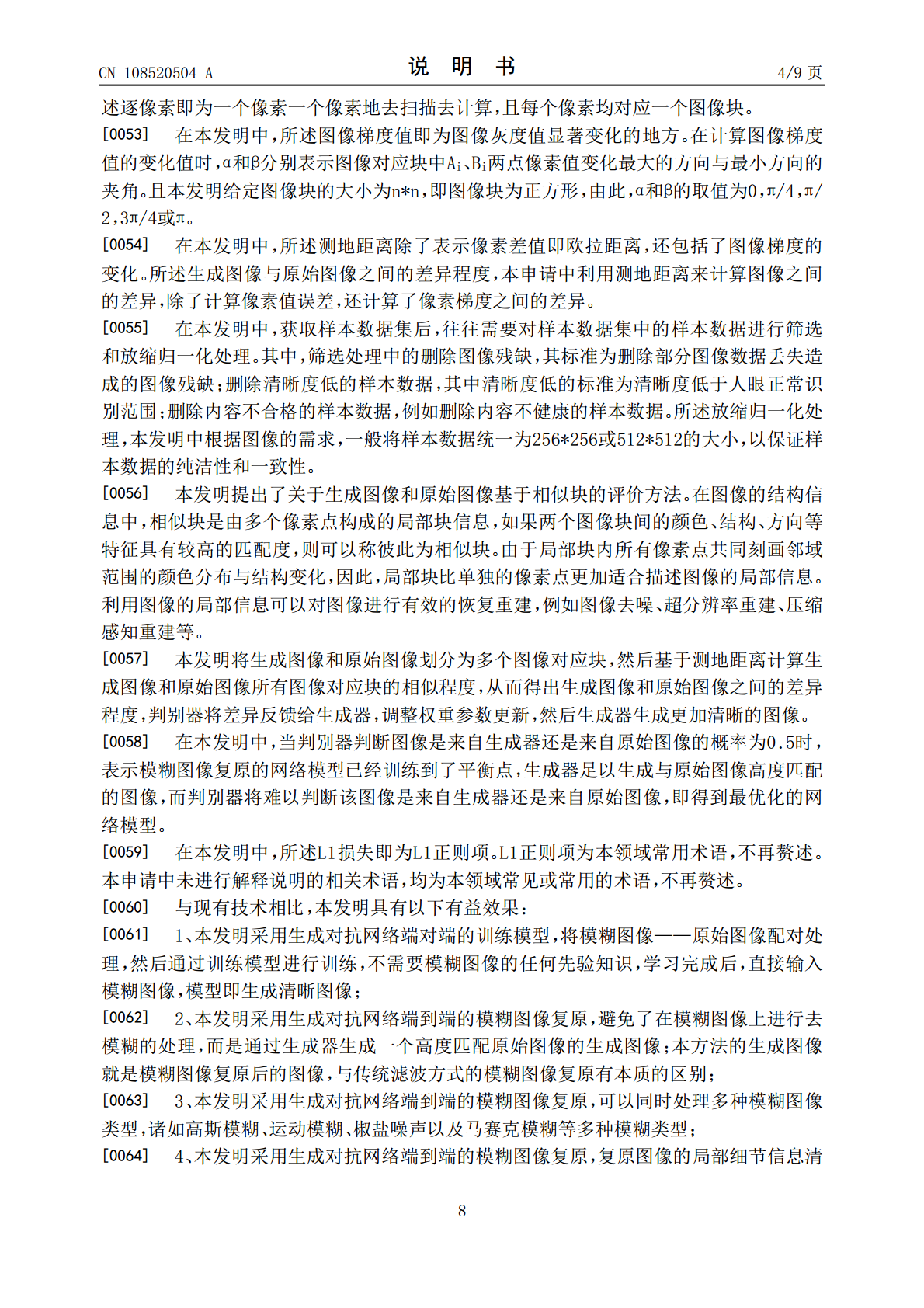

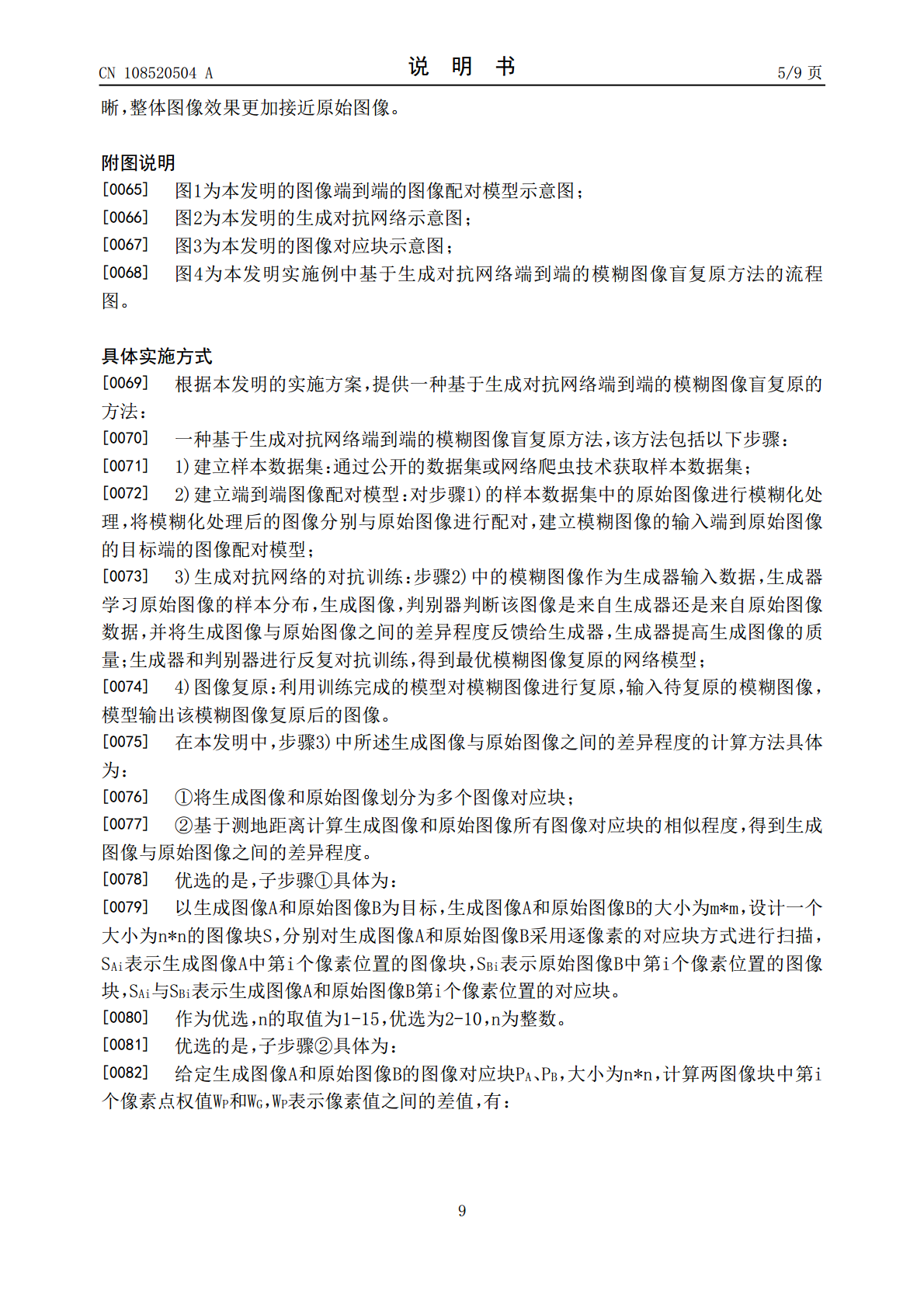

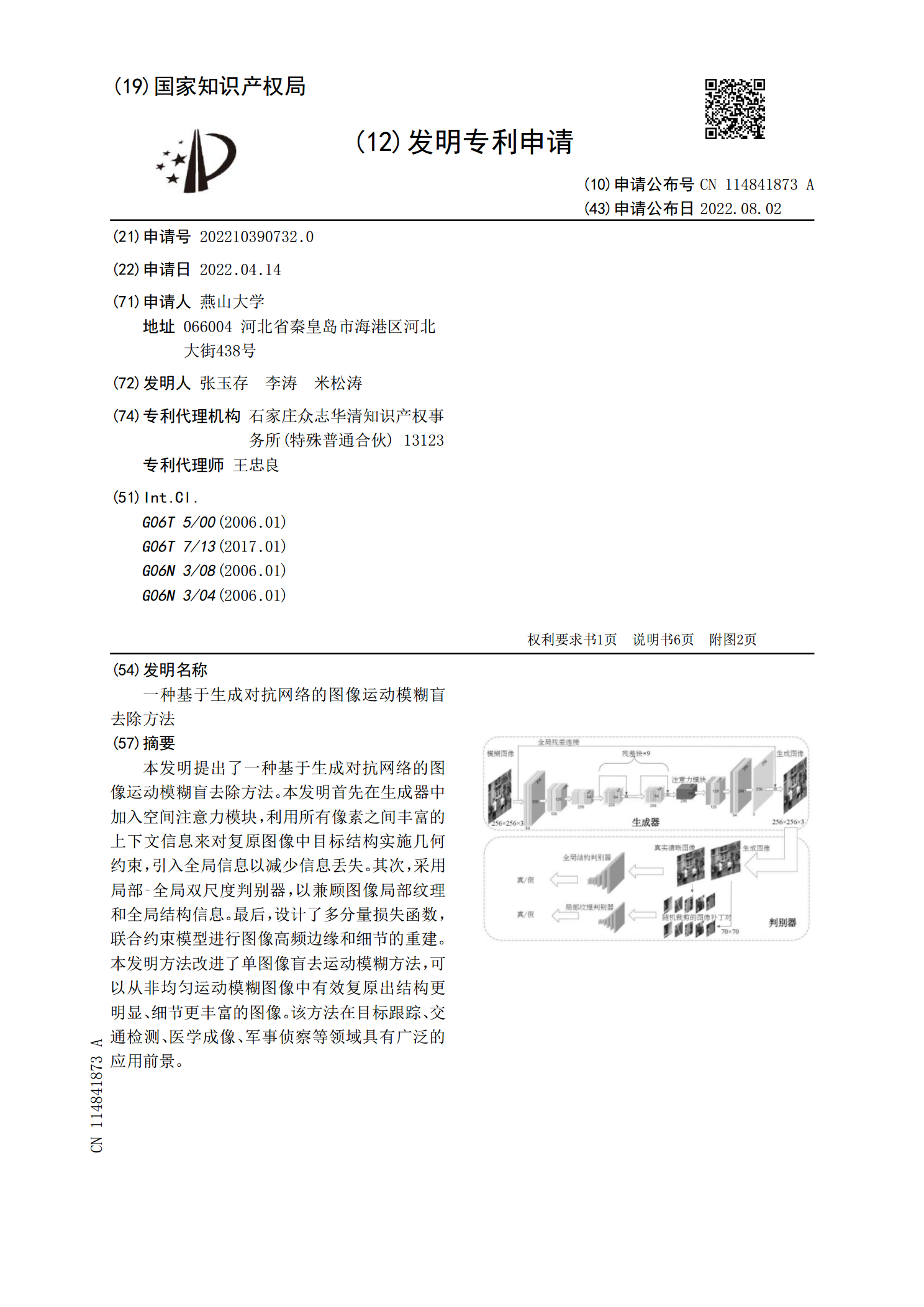

本发明提出了一种基于生成对抗网络的图像运动模糊盲去除方法。本发明首先在生成器中加入空间注意力模块,利用所有像素之间丰富的上下文信息来对复原图像中目标结构实施几何约束,引入全局信息以减少信息丢失。其次,采用局部‑全局双尺度判别器,以兼顾图像局部纹理和全局结构信息。最后,设计了多分量损失函数,联合约束模型进行图像高频边缘和细节的重建。本发明方法改进了单图像盲去运动模糊方法,可以从非均匀运动模糊图像中有效复原出结构更明显、细节更丰富的图像。该方法在目标跟踪、交通检测、医学成像、军事侦察等领域具有广泛的应用前景。