一种图像拍摄方法、装置、设备以及存储介质.pdf

靖烟****魔王

亲,该文档总共20页,到这已经超出免费预览范围,如果喜欢就直接下载吧~

相关资料

一种图像拍摄方法、装置、设备以及存储介质.pdf

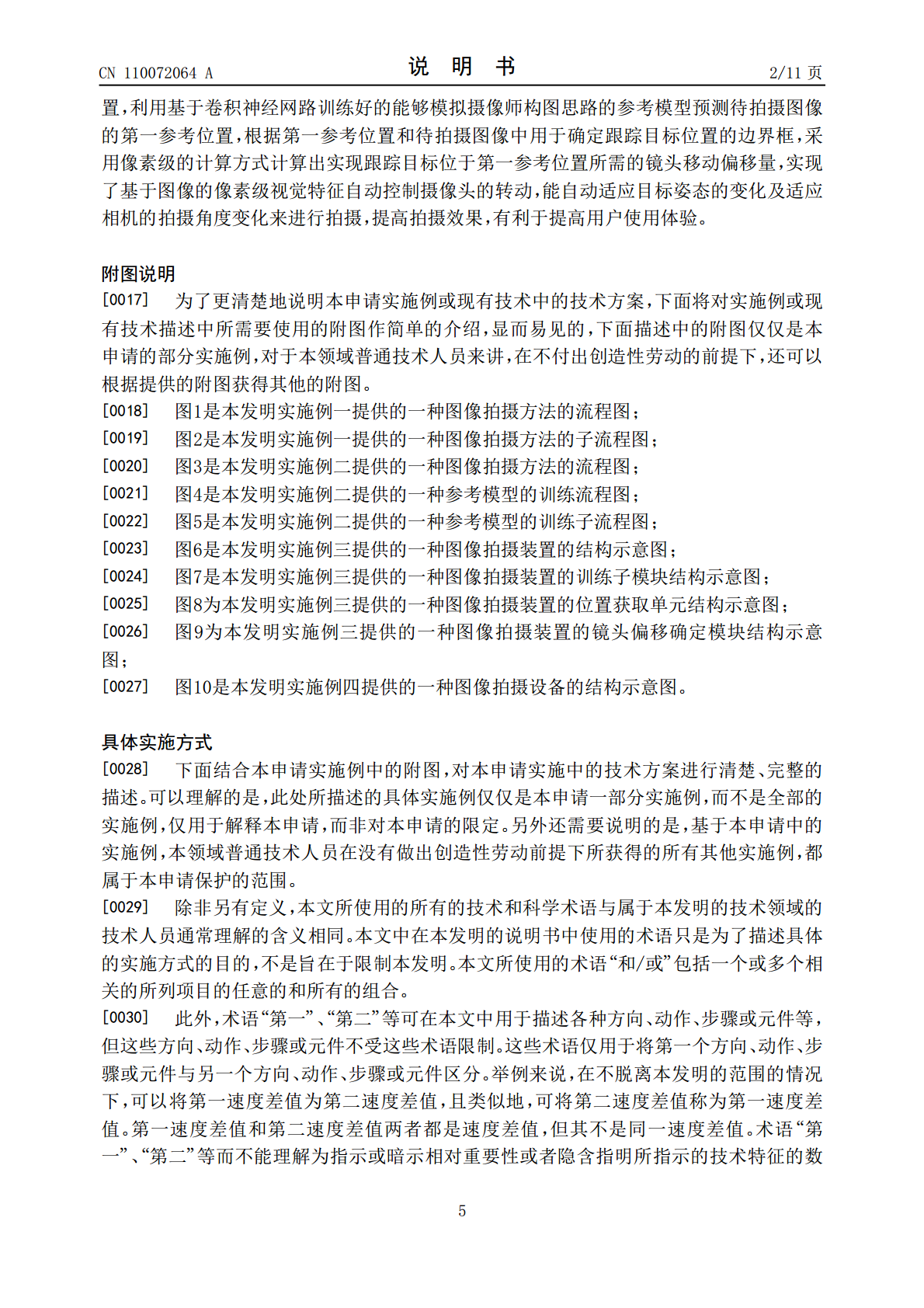

本发明公开了一种图像拍摄方法、装置、设备以及存储介质,该方法包括:获取待拍摄图像内镜头跟踪目标的边界框;利用预先训练好的参考模型预测待拍摄图像的第一参考位置;根据边界框内每个像素位置和第一参考位置确定镜头移动偏移量。本发明利用训练好的模型预测的第一参考位置确定镜头移动偏移量,无需人为控制摄像头的转动,能自动适应目标姿态的变化及适应相机的拍摄角度变化来进行拍摄,提高拍摄效果,提高了用户使用体验。

一种图像拍摄方法、装置、设备和存储介质.pdf

本发明实施例公开了一种图像拍摄方法、装置、设备和存储介质。该方法包括:基于预设曝光参数值,对拍摄场景中的目标物体进行拍摄,获得目标物体对应的第一目标图像;对第一目标图像进行特征提取,确定第一目标图像对应的目标图像特征信息;基于目标图像特征信息和预先建立的样本图像特征信息与正常曝光参数值之间的对应关系,从正常曝光参数值中确定出目标曝光参数值;基于目标曝光参数值,对当前目标物体进行再次拍摄,获得目标物体对应的曝光正常的第二目标图像。通过本发明实施例的技术方案,可以保证拍摄出的每个目标物体均具有正常的曝光效果,

拍摄方法、装置以及存储介质.pdf

本公开是关于一种拍摄方法、装置及存储介质,其中,所述方法还包括:预测采集的预览画面中目标对象的运动状态;基于所述运动状态,对所述目标对象进行对焦,并确定与所述运动状态相匹配的拍摄参数;在检测到拍摄指令时,基于所述拍摄参数,对所述目标对象进行对焦拍摄,生成目标图像。这样,通过预测目标对象的运动状态来对焦的方式,可以提升对焦的准确率,与此同时通过运动状态来匹配拍摄参数,还可以提升拍摄速度,如此,可以同时解决运动状态下对目标对象的对焦和抓拍问题。

图像拍摄装置的参数标定方法、设备及存储介质.pdf

本申请提供了一种图像拍摄装置的参数标定方法、设备及计算机存储介质,通过获取图像拍摄装置的网络成像模型,并将在世界坐标系下位于目标对象上呈预设分布关系的输入点集的第一坐标作为成像网络模型的输入数据,以及基于输入点集的预设分布关系确定成像网络模型的输出点集需要满足的约束关系,以根据该约束关系构建成像网络模型的损失函数,有效的减小了成像网络模型在训练过程中的计算量,整个参数标定过程简单,容易实现。

一种图像处理方法、装置、设备以及存储介质.pdf

本申请提供一种图像处理方法、装置、设备以及存储介质,所述图像处理方法,包括:控制曝光单元对待采集目标进行第N次曝光处理,得到第N次曝光图,其中,N大于或等于1;根据取图指令从所述曝光单元读取所述第N次曝光图;对读取到的所述第N次曝光图进行图像处理,同时,N累加1,返回所述控制曝光单元对待采集目标进行第N次曝光处理的步骤。在一定程度上降低了采图时间。