基于解耦特征引导的多模态文本页面分类方法.pdf

一只****ua

亲,该文档总共12页,到这已经超出免费预览范围,如果喜欢就直接下载吧~

相关资料

基于解耦特征引导的多模态文本页面分类方法.pdf

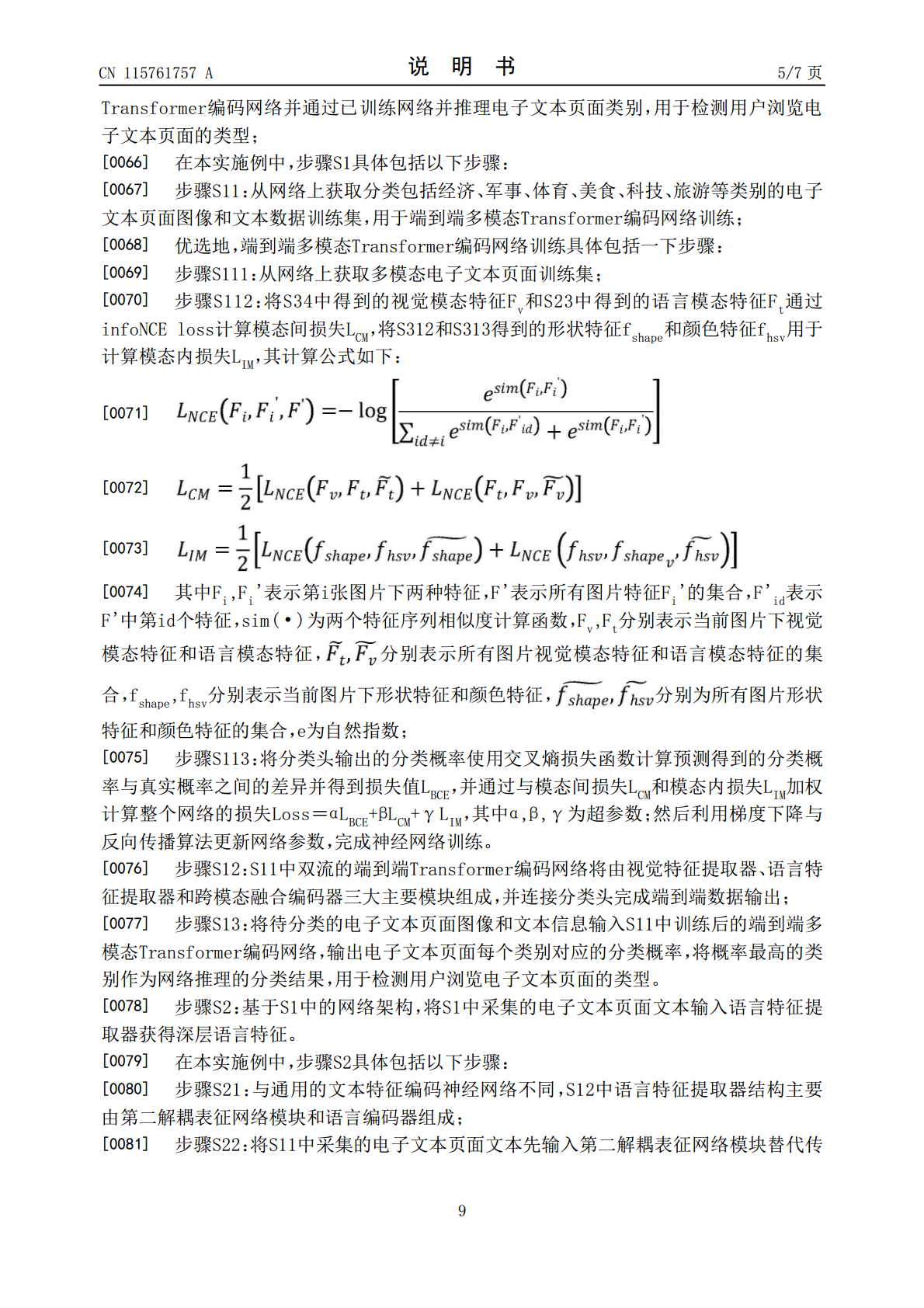

本发明涉及一种基于解耦特征引导的多模态文本页面分类方法,包括以下步骤:获取电子文本页面数据构建训练集,并基于训练集训练双流的端到端Transformer编码网络,所述双流的端到端Transformer编码网络包括视觉特征提取器、语言特征提取器和跨模态融合编码器;将待分类的电子文本页面的文本数据输入语言特征提取器获得深层语言特征;将待分类的电子文本页面的图像数据输入视觉特征提取器获得深层视觉特征;将得到的深层语言特征和深层视觉特征共同输入跨模态融合编码器获得多模态特征,并用于分类网络进行分类。本发明能够有效

基于多模态特征的业务问题单分类方法及装置.pdf

本发明公开了一种基于多模态特征的业务问题单分类方法及装置,涉及人工智能领域,该方法包括:获取业务问题单,所述业务问题单中包括图像、文本和测试代码,从每个业务问题单中提取图像特征、文本特征和测试代码特征;获取每个业务问题单涉及的测试轮次,对测试轮次进行特征提取,获得测试轮次特征;将每个业务问题单的图像特征、文本特征、测试代码特征和测试轮次特征进行特征融合得到特征向量;将两个业务问题单对应的特征向量进行相似度检验,基于检验结果对业务问题单进行分类。本发明根据实际情况,加入了图像特征、字符类特征如验证代码、统计

基于多模态特征表示的课程分类方法、装置、设备及介质.pdf

本发明涉及人工智能领域,提供一种基于多模态特征表示的课程分类方法、装置、设备及介质,能够在增强弱模态语义特征的同时,保留弱模态语义特征的特性,有效避免特征丢失,根据模态的语义强弱进行不同模态权重的自适应学习,在视频、音频、文本多个维度上根据权重对特征进行融合,使得到的特征同时具有三个维度的信息,优化了视频课程的特征表示方式,进而提升了课程类别预测的精度,利用每个样本的融合特征训练预设分类网络,得到视频课程分类模型,利用视频课程分类模型对待分类视频课程进行分类,得到分类结果,实现对课程的准确分类。本发明还涉

基于解耦分类和回归特征最优层技术的害虫目标检测方法.pdf

本发明涉及基于解耦分类和回归特征最优层技术的害虫目标检测方法,与现有技术相比解决了灭虫灯内虫体尺寸差异大导致害虫识别率低的缺陷。本发明包括以下步骤:训练样本集的获取;害虫目标检测网络的构建;害虫目标检测网络的训练;待检测害虫图像样本的获取;害虫目标的检测定位。本发明可以根据常用特征层设置将分类和回归任务分派到不同的特征层分别进行后得到最终的检测结果,从而针对灭虫灯环境下虫体差异大进行差异化检测,提高了灭虫灯环境下虫体检测识别率,满足了实际应用的需要。

一种基于多模态特征融合的证照分类方法及系统.pdf

本发明提供了一种基于多模态特征融合的证照分类方法及系统,该方法充分考虑证照图像含有视觉特征、文本语义特征、文本位置特征等多模态信息的特点,充分利用多模态信息,以及各个模态之间的相互关系,通过构建卷积神经网络提取视觉特征,转化成视觉特征向量;根据证照中独特的文本信息训练语言模型,将证照图像中的文本转化为文本信息向量,对得到的视觉特征向量和文本信息向量进行多模态融合,既能保留原始单模态视觉特征和文本信息,同时也能利用两种模态之间的相互作用,作为分类的依据。本发明不仅考虑证照图像的视觉特征,同时充分考虑文本信息