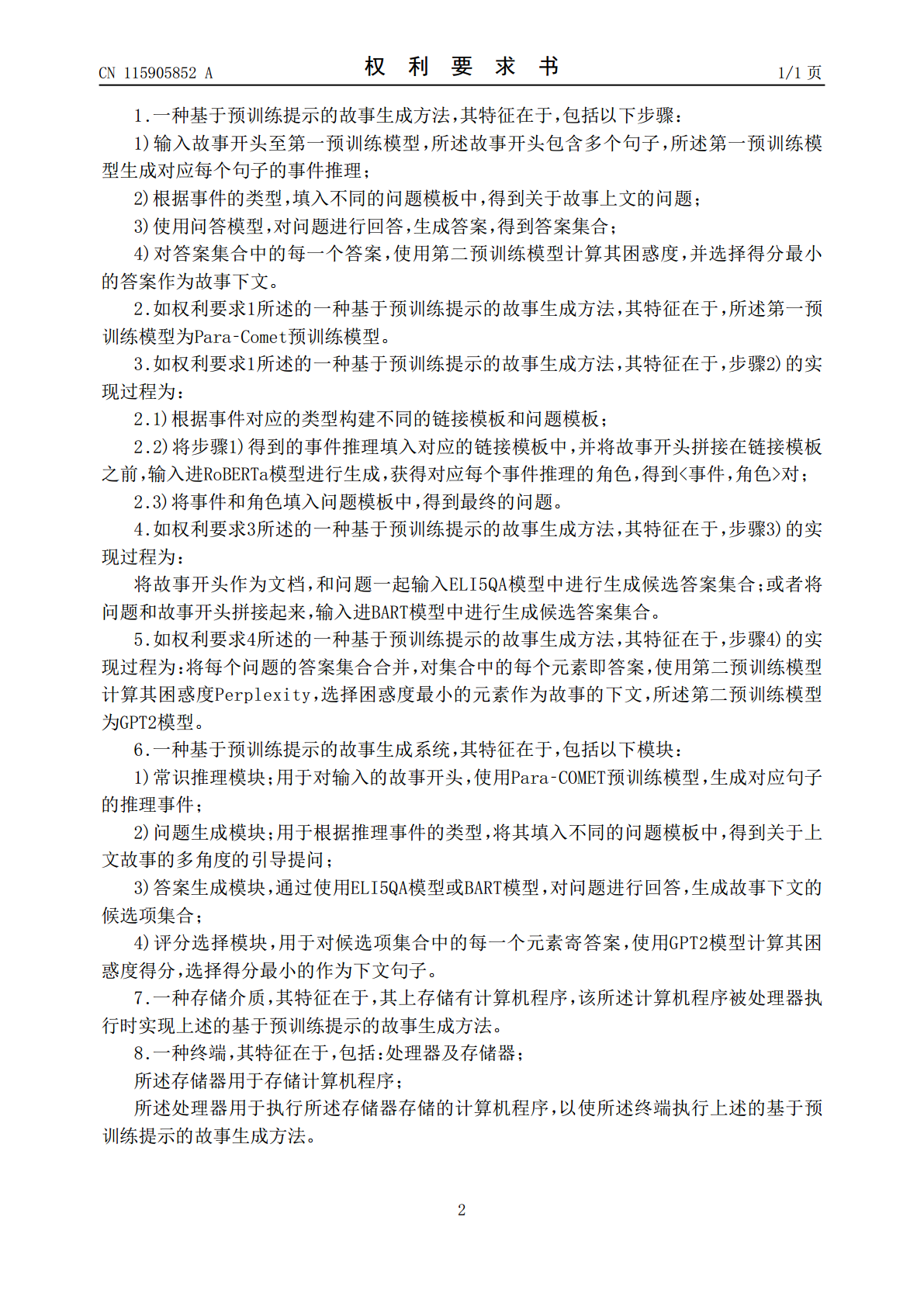

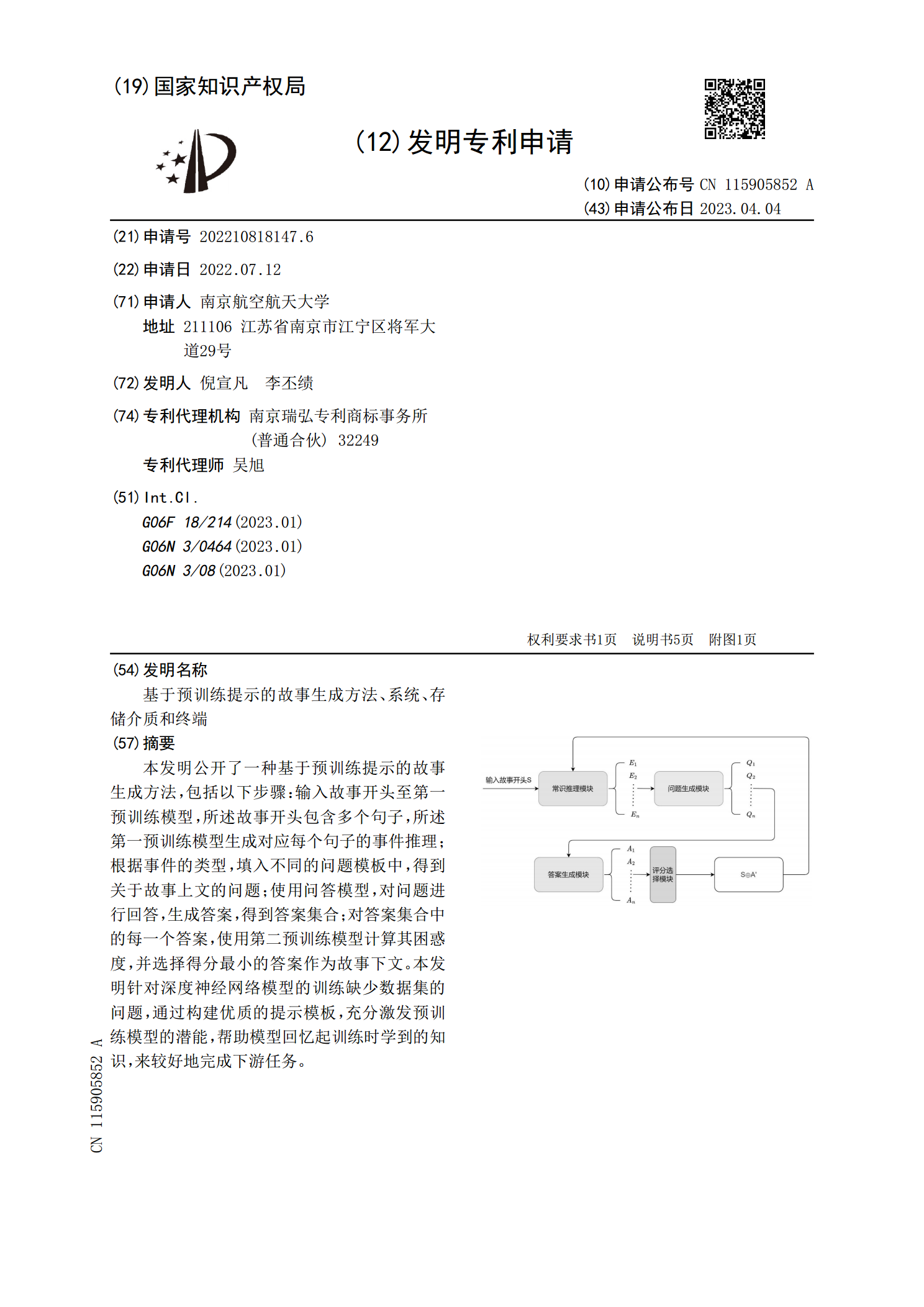

基于预训练提示的故事生成方法、系统、存储介质和终端.pdf

纪阳****公主

在线预览结束,喜欢就下载吧,查找使用更方便

相关资料

基于预训练提示的故事生成方法、系统、存储介质和终端.pdf

本发明公开了一种基于预训练提示的故事生成方法,包括以下步骤:输入故事开头至第一预训练模型,所述故事开头包含多个句子,所述第一预训练模型生成对应每个句子的事件推理;根据事件的类型,填入不同的问题模板中,得到关于故事上文的问题;使用问答模型,对问题进行回答,生成答案,得到答案集合;对答案集合中的每一个答案,使用第二预训练模型计算其困惑度,并选择得分最小的答案作为故事下文。本发明针对深度神经网络模型的训练缺少数据集的问题,通过构建优质的提示模板,充分激发预训练模型的潜能,帮助模型回忆起训练时学到的知识,来较好地

基于cGAN的无限地形生成方法、系统、存储介质和终端.pdf

本发明公开了基于cGAN的无限地形生成方法、系统、存储介质和终端,方法包括:获取草图;数据预处理:将所述草图覆盖已存在的生成地形对应位置,并打包该位置与周围八个方向邻接区域的地形灰度图,形成一整张待处理图像,作为地形生成网络的输入;网络处理:将待处理图像在地形生成网络中进行处理,网络的输出将对中心草图区域进行地形的创作,通过该区域的草图与周围已有地形的高低起伏生成拟合周围走向的中心区域的地形灰度图;后期处理:将输出的中心区域的地形灰度图与已有地形对应位置的区域分别乘以一个权重并相加,再赋值到已有地形中,形

信息生成方法、装置、终端、系统和存储介质.pdf

本发明实施例公开了一种信息生成方法、装置、设备、系统和存储介质,该方法包括:从服务器获取目标物品的初始需求量信息,该初始需求量信息是由服务器利用需求量预测模型对目标物品进行需求量预测生成的;在预设界面上展示初始需求量信息和需求量配置信息,并监测作用于预设界面上的根据需求量配置信息对初始需求量信息的调整操作;在监测到调整操作时,根据调整操作生成目标物品的目标需求量信息。本发明实施例中,在得到利用模型对目标物品进行需求量预测的预测结果之后,会通过预设界面提供人工调整方式,使得可以人工对模型预测结果进行调整,将

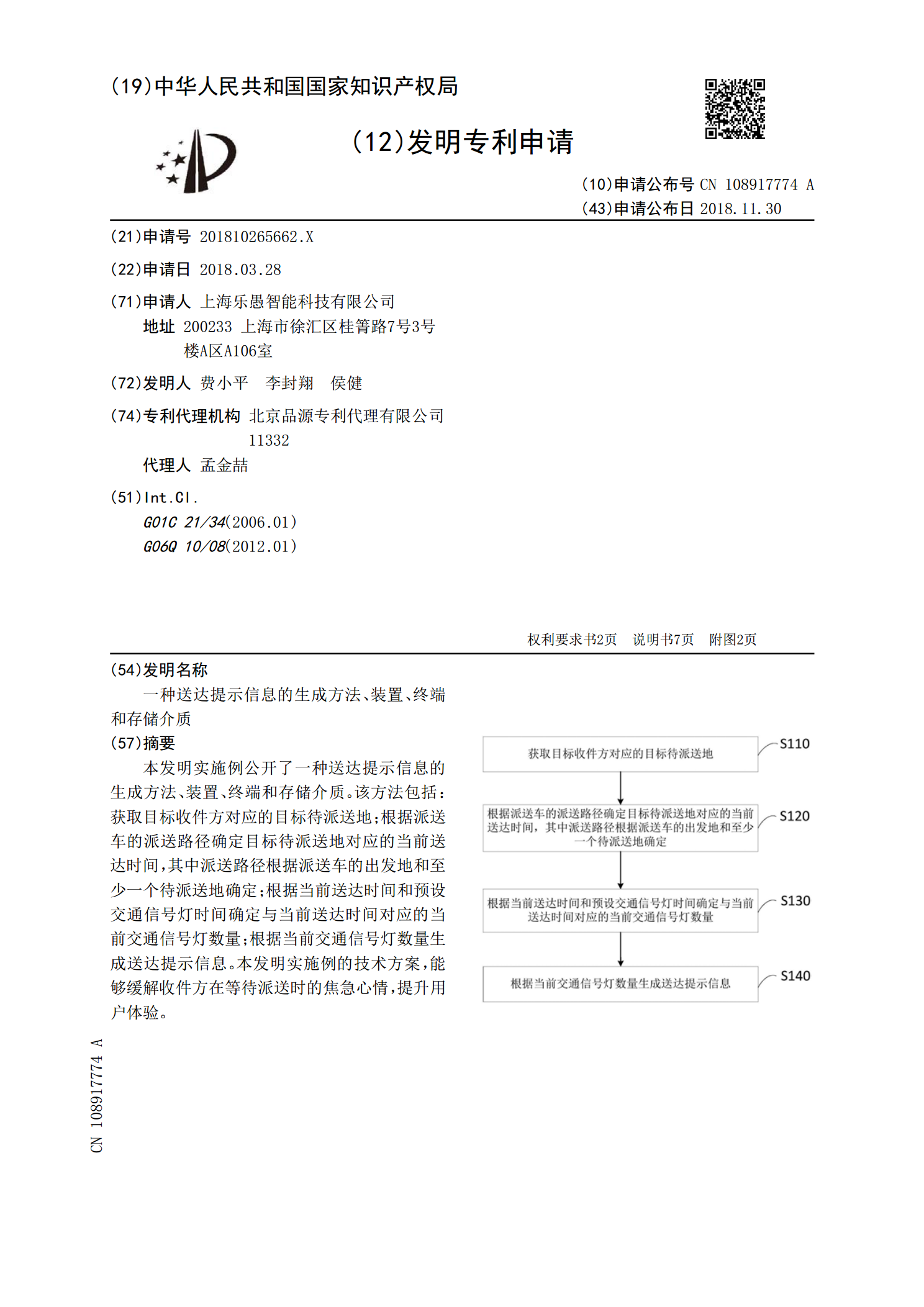

一种送达提示信息的生成方法、装置、终端和存储介质.pdf

本发明实施例公开了一种送达提示信息的生成方法、装置、终端和存储介质。该方法包括:获取目标收件方对应的目标待派送地;根据派送车的派送路径确定目标待派送地对应的当前送达时间,其中派送路径根据派送车的出发地和至少一个待派送地确定;根据当前送达时间和预设交通信号灯时间确定与当前送达时间对应的当前交通信号灯数量;根据当前交通信号灯数量生成送达提示信息。本发明实施例的技术方案,能够缓解收件方在等待派送时的焦急心情,提升用户体验。

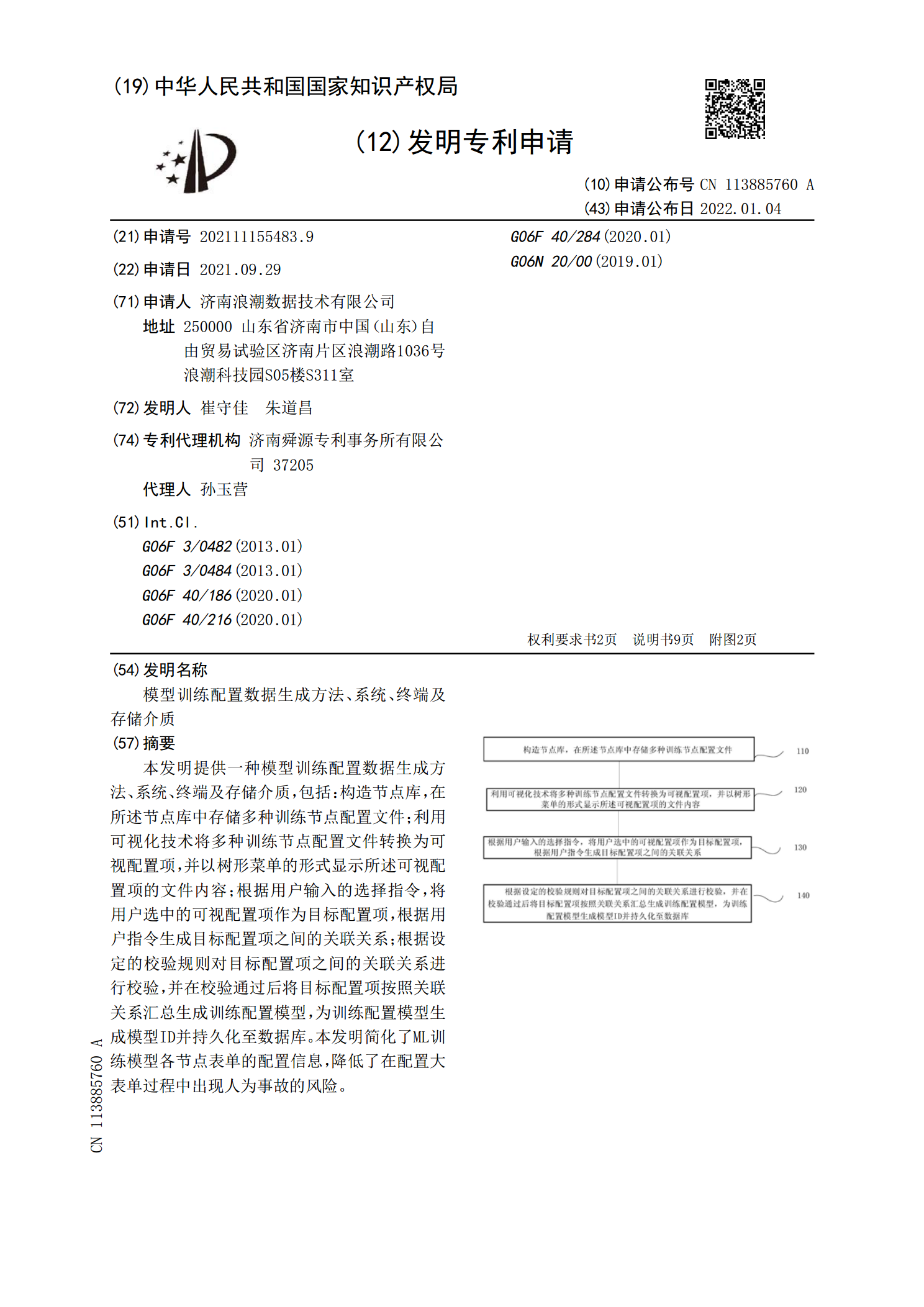

模型训练配置数据生成方法、系统、终端及存储介质.pdf

本发明提供一种模型训练配置数据生成方法、系统、终端及存储介质,包括:构造节点库,在所述节点库中存储多种训练节点配置文件;利用可视化技术将多种训练节点配置文件转换为可视配置项,并以树形菜单的形式显示所述可视配置项的文件内容;根据用户输入的选择指令,将用户选中的可视配置项作为目标配置项,根据用户指令生成目标配置项之间的关联关系;根据设定的校验规则对目标配置项之间的关联关系进行校验,并在校验通过后将目标配置项按照关联关系汇总生成训练配置模型,为训练配置模型生成模型ID并持久化至数据库。本发明简化了ML训练模型各