一种基于概率图和ViT模型的图片分类方法.pdf

白真****ng

在线预览结束,喜欢就下载吧,查找使用更方便

相关资料

一种基于概率图和ViT模型的图片分类方法.pdf

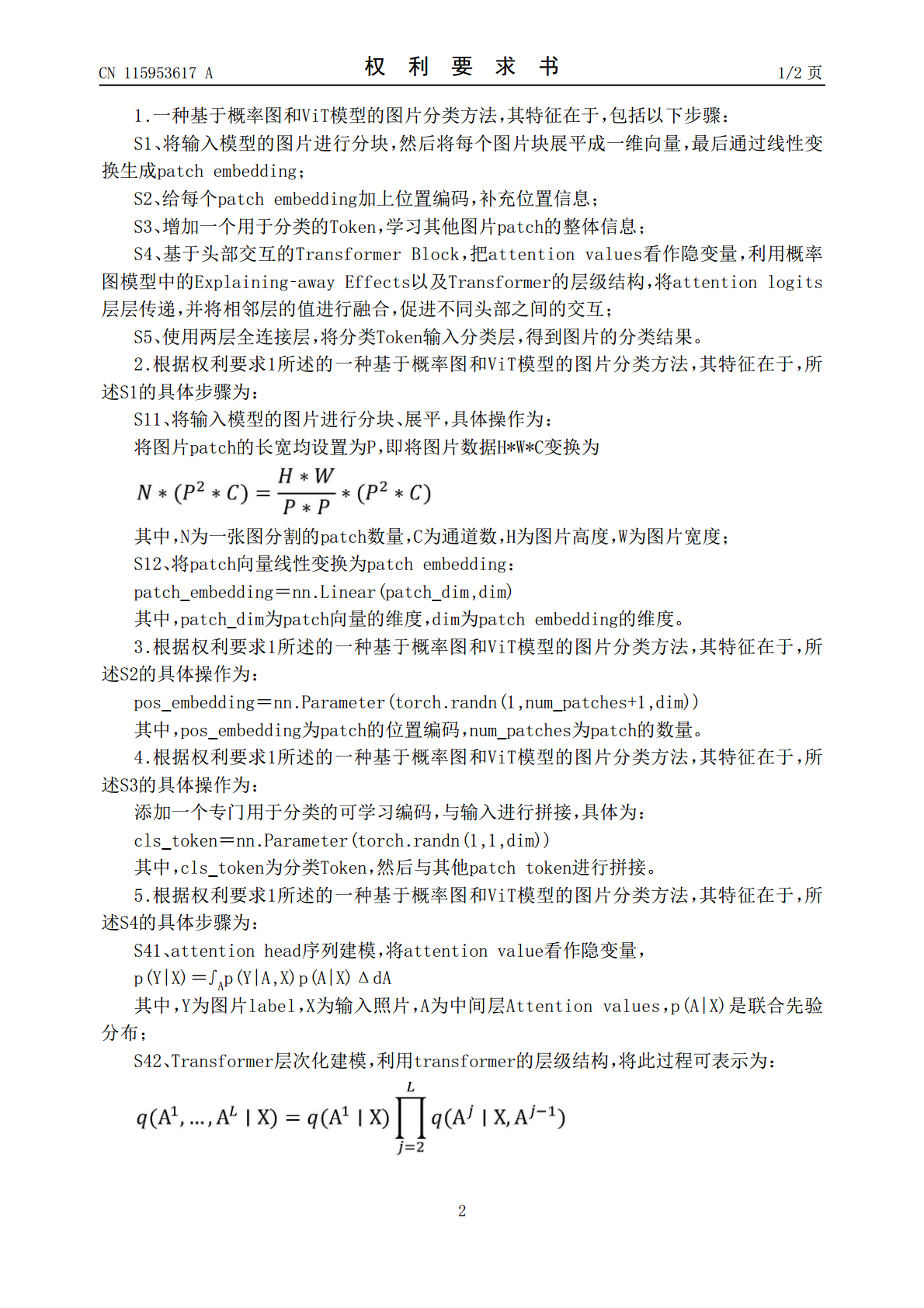

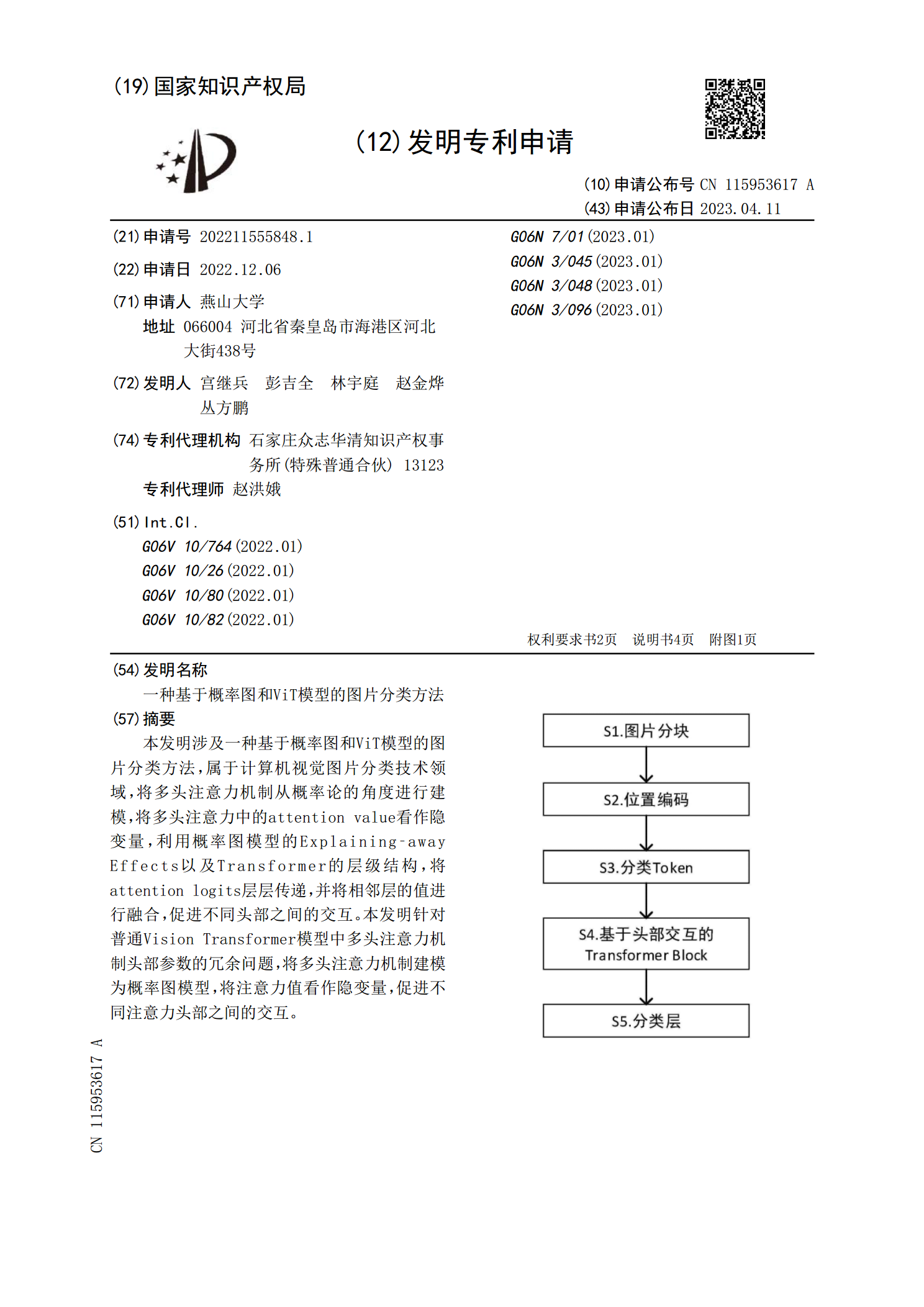

本发明涉及一种基于概率图和ViT模型的图片分类方法,属于计算机视觉图片分类技术领域,将多头注意力机制从概率论的角度进行建模,将多头注意力中的attentionvalue看作隐变量,利用概率图模型的Explaining‑awayEffects以及Transformer的层级结构,将attentionlogits层层传递,并将相邻层的值进行融合,促进不同头部之间的交互。本发明针对普通VisionTransformer模型中多头注意力机制头部参数的冗余问题,将多头注意力机制建模为概率图模型,将注意力值看

一种基于小波散射网络和ViT的图像分类方法.pdf

本发明提供了一种基于小波散射网络和ViT的图像分类方法。该方法包括:对图像数据进行预处理,获取带标签的预处理后的图像数据;构建基于小波散射网络和ViT的分类模型ScatViT,设定模型参数;设定训练参数,利用预处理后的图像数据训练分类模型ScatViT;利用训练好的分类模型ScatViT对待分类图像进行分类处理。本发明结合小波散射网络和ViT两个模型,提出了将图像切块操作改为使用小波散射网络提取图像特征的ScatViT模型,该模型改进了小波散射网络由于滤波器权重固定导致的无法从数据中学习的缺陷,修复了由于

一种基于深度学习和概率图模型的本征分解方法的研究.docx

一种基于深度学习和概率图模型的本征分解方法的研究一种基于深度学习和概率图模型的本征分解方法的研究摘要:本文提出了一种基于深度学习和概率图模型的本征分解方法,利用深度学习模型提取数据的抽象特征表示,然后结合概率图模型对特征进行建模和分析,从而实现对数据的本征分解。通过实验验证,在不同的数据集上,所提出的方法能够有效地进行本征分解,并得到更好的结果。该方法具有一定的泛化能力,并可以应用于多种不同的领域。关键词:深度学习、概率图模型、本征分解1.引言本征分解是一种常用的数据分析方法,可以用于对数据进行降维、去噪

一种基于3因素概率图模型的长尾推荐方法.pptx

基于3因素概率图模型的长尾推荐方法目录添加章节标题方法概述3因素概率图模型定义长尾推荐方法的原理方法的适用场景方法优缺点分析3因素概率图模型构建用户画像构建物品特征提取用户与物品的关联关系建立概率图模型参数学习长尾推荐算法实现冷启动问题处理用户兴趣建模物品相似度计算推荐列表生成与排序实验验证与结果分析数据集选择与预处理实验设置与对比方法推荐效果评估指标实验结果分析结果对比与讨论应用案例与效果展示应用场景描述实际应用效果展示用户反馈与案例分析方法改进与优化建议总结与展望方法总结研究贡献与限制未来研究方向TH

一种基于图压缩的深度图分类模型防御方法.pdf

本发明涉及图科学技术领域,具体公开一种基于图压缩的深度图分类模型防御方法,包括以下步骤:(1)设计深度图分类模型,对干净样本与对抗样本的连边求梯度得到所有连边权重系数;(2计算干净/对抗样本的梯度‑传统连边重要性相似度;(3)选择传统连边重要性指标与对抗样本中的连边进行排序,提取对抗样本中的关键连边;(4)根据提取到的关键连边进行图压缩,并将压缩后的图样本重新输入深度图分类模型,输出压缩后的图分类准确率,实现深度图分类模型的防御过程。本发明利用图压缩方法保留图原始关键连边并滤除对抗扰动连边与非关键连边,实