多方联合进行模型训练的方法及装置.pdf

慧红****ad

亲,该文档总共21页,到这已经超出免费预览范围,如果喜欢就直接下载吧~

相关资料

多方联合进行模型训练的方法及装置.pdf

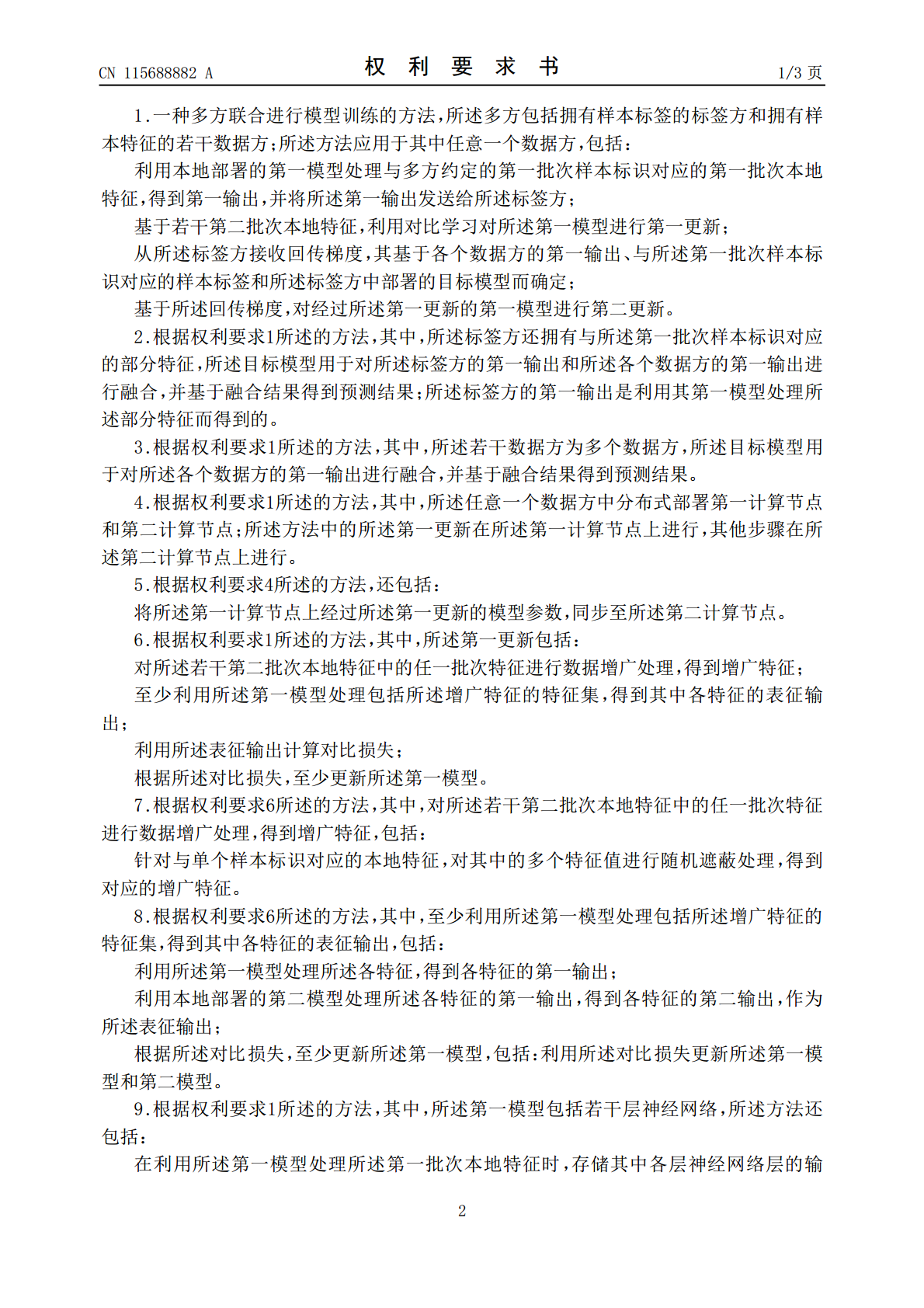

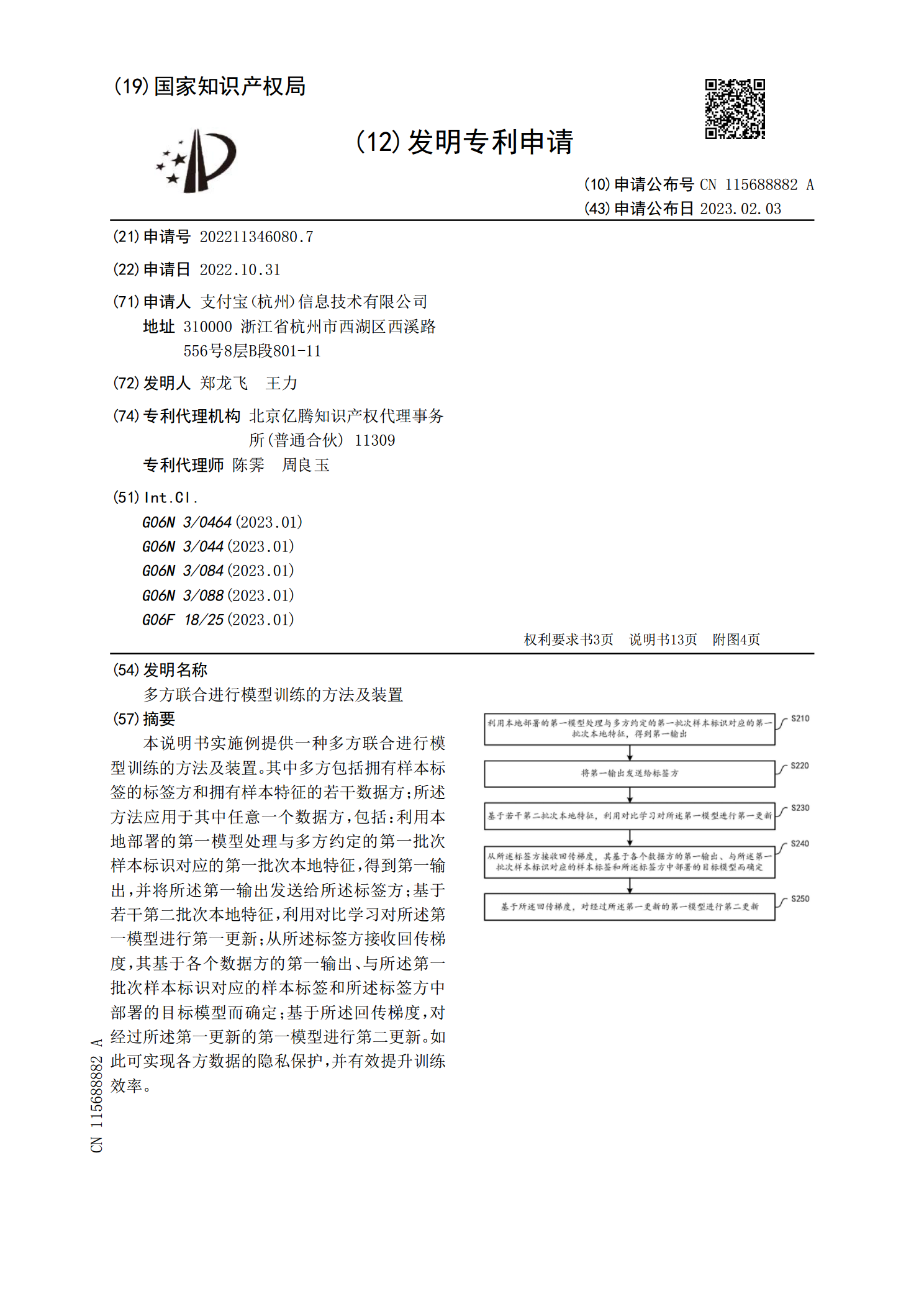

本说明书实施例提供一种多方联合进行模型训练的方法及装置。其中多方包括拥有样本标签的标签方和拥有样本特征的若干数据方;所述方法应用于其中任意一个数据方,包括:利用本地部署的第一模型处理与多方约定的第一批次样本标识对应的第一批次本地特征,得到第一输出,并将所述第一输出发送给所述标签方;基于若干第二批次本地特征,利用对比学习对所述第一模型进行第一更新;从所述标签方接收回传梯度,其基于各个数据方的第一输出、与所述第一批次样本标识对应的样本标签和所述标签方中部署的目标模型而确定;基于所述回传梯度,对经过所述第一更新

多方联合进行模型数据处理的方法及装置.pdf

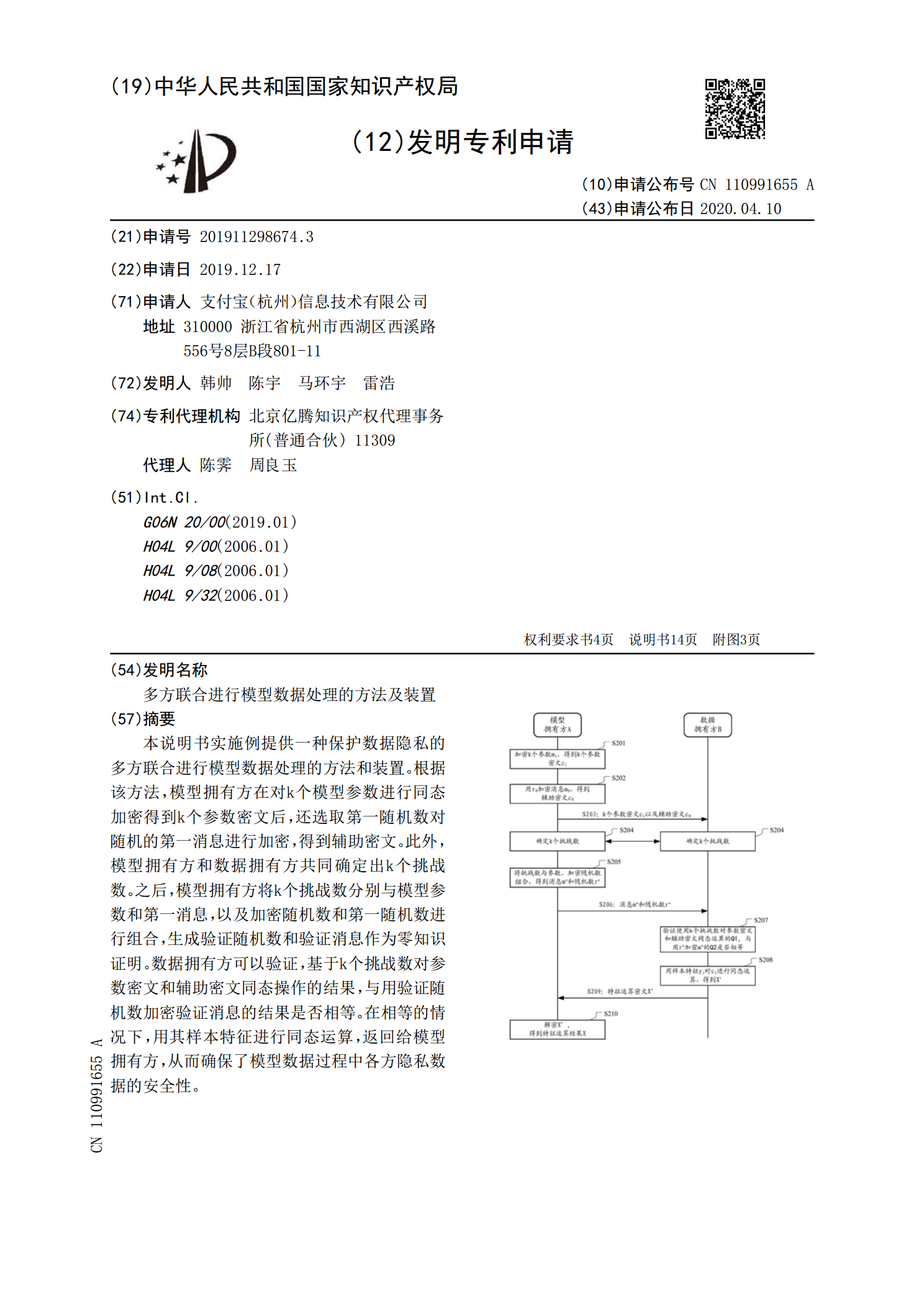

本说明书实施例提供一种保护数据隐私的多方联合进行模型数据处理的方法和装置。根据该方法,模型拥有方在对k个模型参数进行同态加密得到k个参数密文后,还选取第一随机数对随机的第一消息进行加密,得到辅助密文。此外,模型拥有方和数据拥有方共同确定出k个挑战数。之后,模型拥有方将k个挑战数分别与模型参数和第一消息,以及加密随机数和第一随机数进行组合,生成验证随机数和验证消息作为零知识证明。数据拥有方可以验证,基于k个挑战数对参数密文和辅助密文同态操作的结果,与用验证随机数加密验证消息的结果是否相等。在相等的情况下,用

多方联合进行模型数据处理的方法及装置.pdf

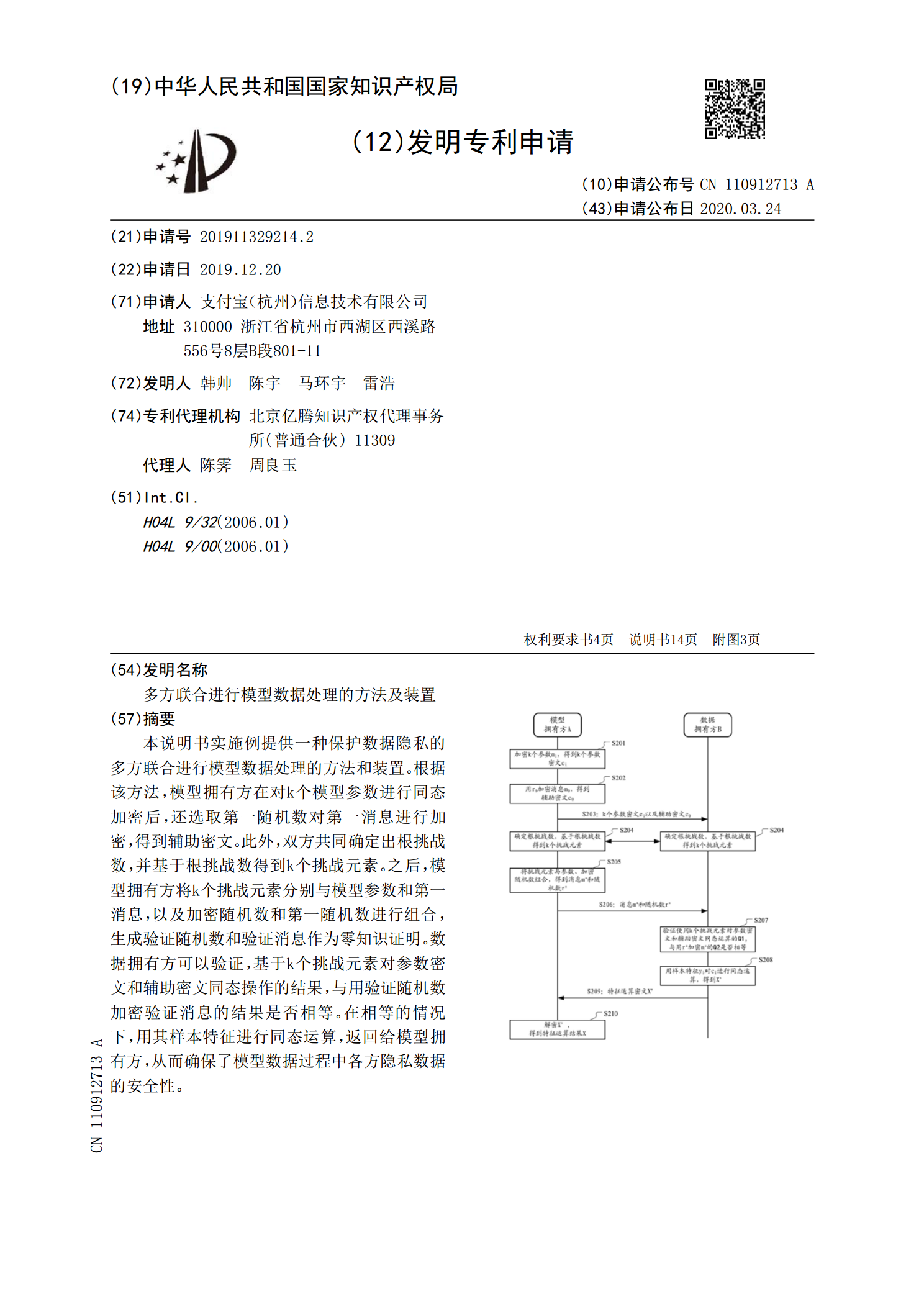

本说明书实施例提供一种保护数据隐私的多方联合进行模型数据处理的方法和装置。根据该方法,模型拥有方在对k个模型参数进行同态加密后,还选取第一随机数对第一消息进行加密,得到辅助密文。此外,双方共同确定出根挑战数,并基于根挑战数得到k个挑战元素。之后,模型拥有方将k个挑战元素分别与模型参数和第一消息,以及加密随机数和第一随机数进行组合,生成验证随机数和验证消息作为零知识证明。数据拥有方可以验证,基于k个挑战元素对参数密文和辅助密文同态操作的结果,与用验证随机数加密验证消息的结果是否相等。在相等的情况下,用其样本

一种对业务预测模型进行多方联合训练的方法及装置.pdf

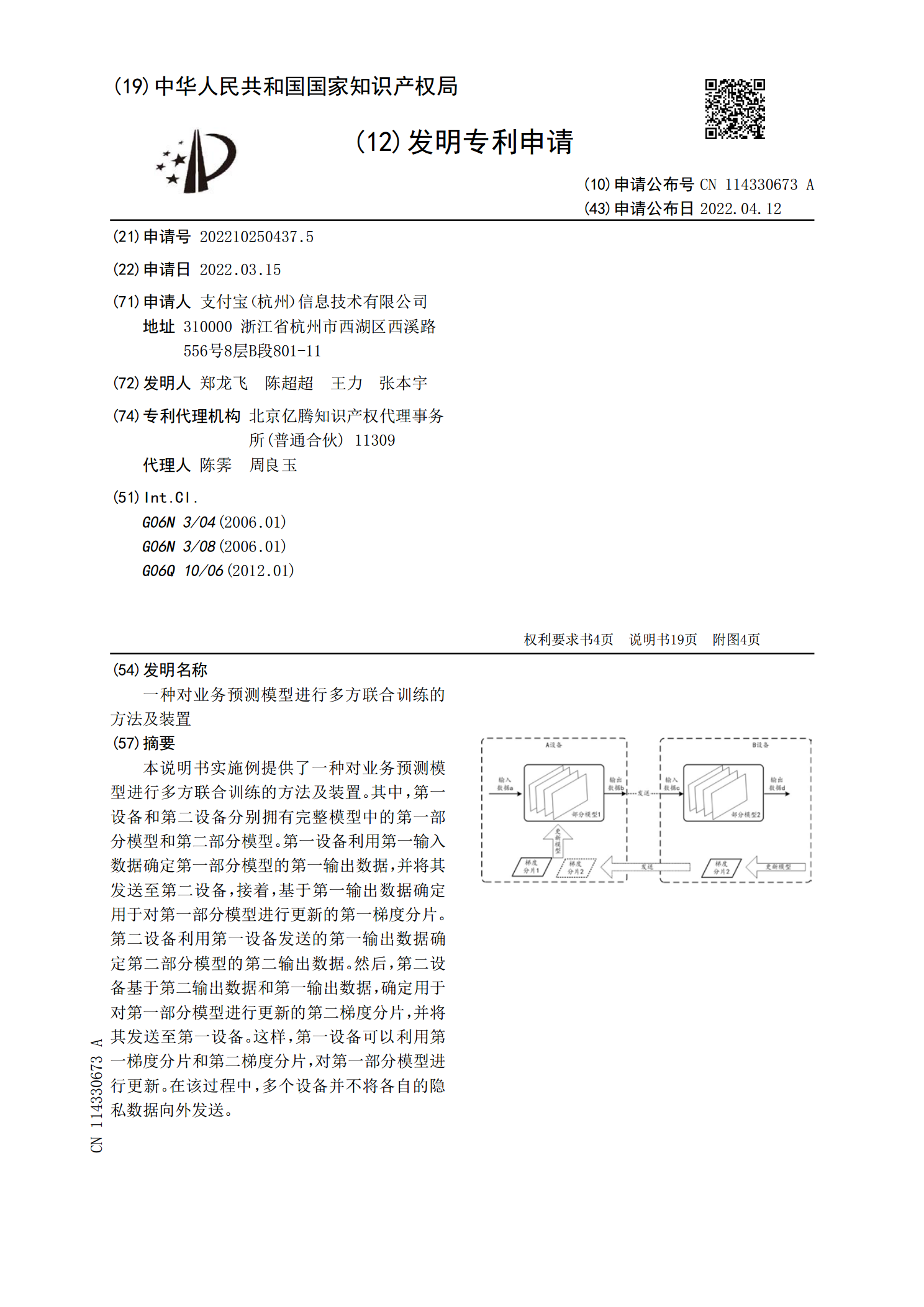

本说明书实施例提供了一种对业务预测模型进行多方联合训练的方法及装置。其中,第一设备和第二设备分别拥有完整模型中的第一部分模型和第二部分模型。第一设备利用第一输入数据确定第一部分模型的第一输出数据,并将其发送至第二设备,接着,基于第一输出数据确定用于对第一部分模型进行更新的第一梯度分片。第二设备利用第一设备发送的第一输出数据确定第二部分模型的第二输出数据。然后,第二设备基于第二输出数据和第一输出数据,确定用于对第一部分模型进行更新的第二梯度分片,并将其发送至第一设备。这样,第一设备可以利用第一梯度分片和第二

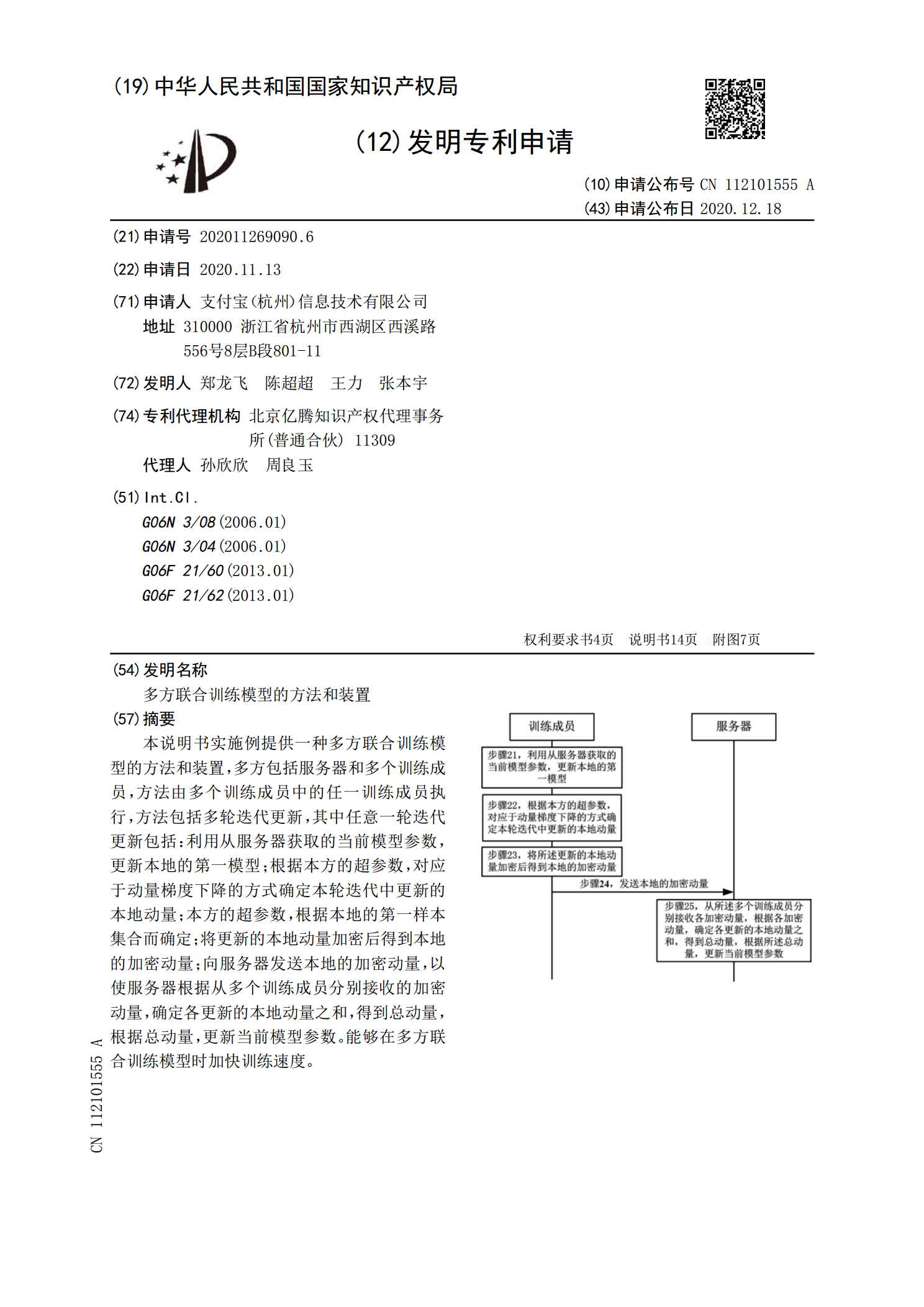

多方联合训练模型的方法和装置.pdf

本说明书实施例提供一种多方联合训练模型的方法和装置,多方包括服务器和多个训练成员,方法由多个训练成员中的任一训练成员执行,方法包括多轮迭代更新,其中任意一轮迭代更新包括:利用从服务器获取的当前模型参数,更新本地的第一模型;根据本方的超参数,对应于动量梯度下降的方式确定本轮迭代中更新的本地动量;本方的超参数,根据本地的第一样本集合而确定;将更新的本地动量加密后得到本地的加密动量;向服务器发送本地的加密动量,以使服务器根据从多个训练成员分别接收的加密动量,确定各更新的本地动量之和,得到总动量,根据总动量,更新