基于单目夜视图像的深度估计的开题报告.docx

快乐****蜜蜂

在线预览结束,喜欢就下载吧,查找使用更方便

相关资料

基于单目夜视图像的深度估计的开题报告.docx

基于单目夜视图像的深度估计的开题报告摘要:随着机器视觉的发展,深度估计在计算机视觉中扮演着重要的角色。深度估计技术有着广泛的应用,例如场景重建、自主驾驶等。然而,在夜间条件下,深度估计面临着很大的挑战,因为夜视图像缺乏明显的纹理和细节。因此在本研究中,我们提出了一种基于单目夜视图像的深度估计方法。首先,本研究将调查已有的夜视图像与深度估计方法,分析它们的限制和局限性。然后,我们将提出一种新的深度估计方法,该方法利用光流场来增强夜视图像的纹理信息,并使用深度学习技术进行深度估计。最后,我们将使用公开数据集进

基于单目夜视图像的深度估计的任务书.docx

基于单目夜视图像的深度估计的任务书一、任务背景随着计算机视觉技术的不断发展,深度学习在图像处理领域中发挥着越来越大的作用。深度学习神经网络不仅可以完成图像分类、目标检测、语义分割等任务,同时也能够实现单目深度估计,也就是在没有深度传感器的情况下,通过图像来推断物体的深度信息。随着深度学习的发展,单目深度估计的准确性也逐渐提高。然而,在夜间或低光照条件下,由于图像信噪比低、对比度不足以及光照条件不稳定等原因,单目深度估计的精度进一步降低,面临着许多挑战。因此,在夜视图像上的单目深度估计成为了一个很大的研究热

基于深度学习的单目深度估计及其应用的开题报告.docx

基于深度学习的单目深度估计及其应用的开题报告一、选题背景及意义随着深度学习技术的迅速发展,对计算机视觉的研究也越来越多,深度学习在计算机视觉领域的广泛应用也得到了广泛地验证。在计算机视觉领域,单目深度估计是非常重要的研究领域之一,因为它可以提供场景中物体的深度信息,从而使我们更好地理解场景中的物体和环境,同时为视觉应用提供重要的输入。因此,基于深度学习的单目深度估计研究对于计算机视觉和机器人领域的发展具有非常重要的意义。二、研究现状及发展动态在历史上,单目深度估计是一个经典的计算机视觉问题,其目的是从一张

单目胃肠镜视频图像深度估计方法研究的开题报告.docx

单目胃肠镜视频图像深度估计方法研究的开题报告一、选题背景随着医学技术的不断发展,各种医疗设备也得到了飞速的发展和应用。其中,胃肠镜是一种经口腔或鼻孔进入人体进行消化系统检查的医疗设备,其主要功能是观察消化道内部的病理变化,如胃溃疡、肠炎、息肉等。而单目胃肠镜作为胃肠镜的一种新型设备,其具有小巧、便携、无需麻醉等优点,已经逐渐走进人们的视野,并得到了广泛的应用。然而,单目胃肠镜由于其视野较小,只能观察到局部的病变情况,为了更好地协助医生进行病情分析和治疗,需要对单目胃肠镜进行视觉深度估计,以便在观察局部病变

从单目内窥镜图像估计实时深度.pdf

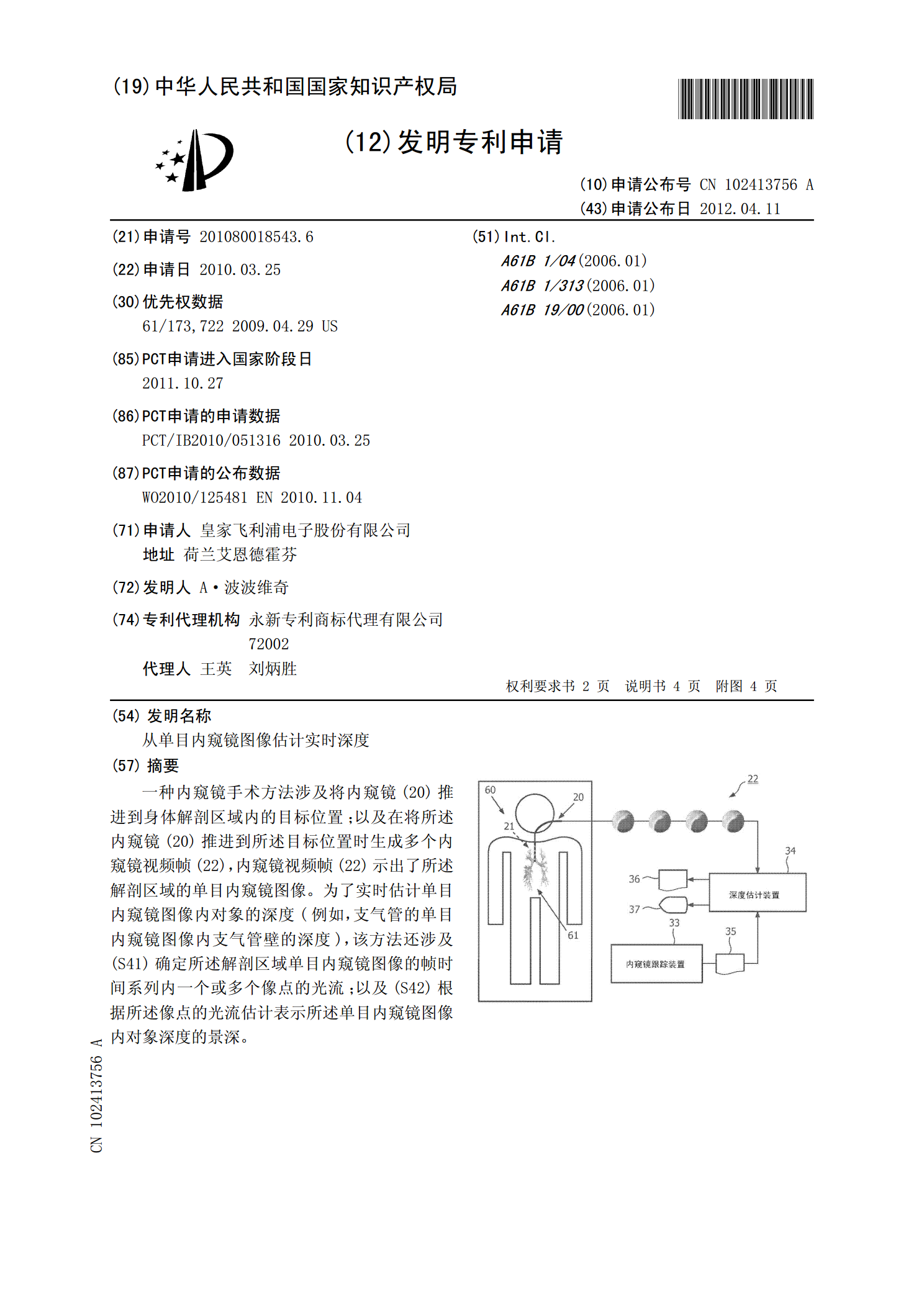

一种内窥镜手术方法涉及将内窥镜(20)推进到身体解剖区域内的目标位置;以及在将所述内窥镜(20)推进到所述目标位置时生成多个内窥镜视频帧(22),内窥镜视频帧(22)示出了所述解剖区域的单目内窥镜图像。为了实时估计单目内窥镜图像内对象的深度(例如,支气管的单目内窥镜图像内支气管壁的深度),该方法还涉及(S41)确定所述解剖区域单目内窥镜图像的帧时间系列内一个或多个像点的光流;以及(S42)根据所述像点的光流估计表示所述单目内窥镜图像内对象深度的景深。