基于多模态的情绪识别方法.pdf

努力****梓颖

亲,该文档总共28页,到这已经超出免费预览范围,如果喜欢就直接下载吧~

相关资料

基于多模态的情绪识别方法.pdf

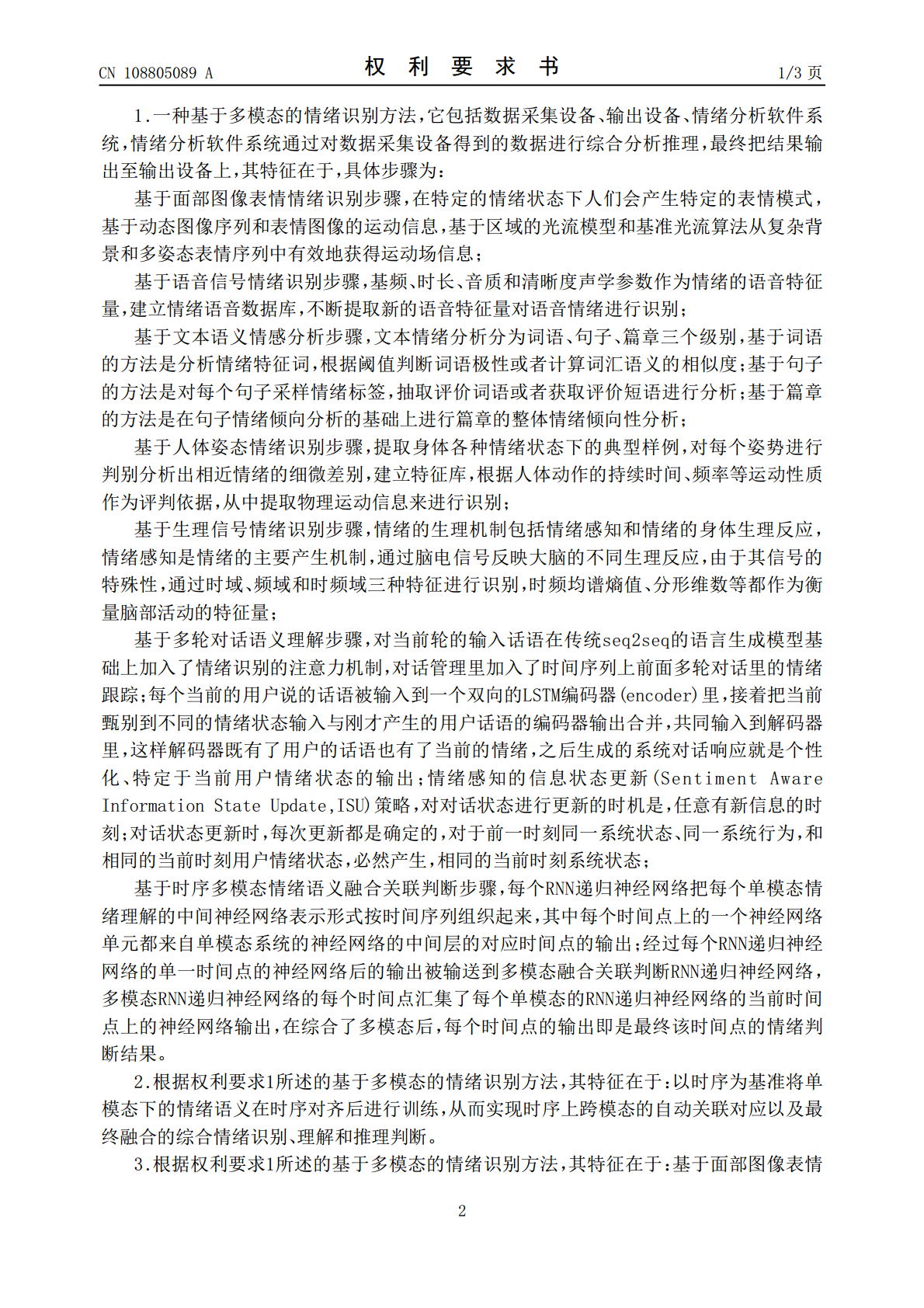

本发明的基于多模态的情绪识别方法,包括数据采集设备、输出设备、情绪分析软件系统,情绪分析软件系统通过对数据采集设备得到的数据进行综合分析推理,最终把结果输出至输出设备上;具体步骤为:基于面部图像表情情绪识别步骤、基于语音信号情绪识别步骤、基于文本语义情感分析步骤、基于人体姿态情绪识别步骤、基于生理信号情绪识别步骤,以及基于多轮对话语义理解步骤和基于时序多模态情绪语义融合关联判断步骤。本发明突破性的打通了五大单模态的情绪识别,创新性的利用深度神经网络将多个单模态的信息由神经网络编码、深度的关联和理解后进行综

基于多模态信息融合处理的文本识别方法.pdf

本发明披露一种基于多模态信息融合处理的文本识别方法。本发明中的多模态信息,包括图像信息和语意信息。在图像信息方面,选用胶囊网络提取像素特征;在语意信息方面,通过引入预处理语言模型构建语意胶囊模块,可以根据文本中前一时刻的字符,预测出下一个字符,为模型提供语意特征;在融合阶段中本发明对胶囊神经网络进行轻量化并对其内部的动态路由算法进行优化,使得在保留网络模型的识别精度的同时有效降低网络中神经元的数量,减少了网络的空间占用,提升运算速度。本发明提出的基于多模态信息融合处理的文本识别方法有效提高了字符文本的识别

基于多模态的电子元器件智能识别方法.pdf

一种基于多模态的电子元器件智能识别方法,涉及电路板检测技术领域,该方法先拍摄目标电路板在直射光源、侧光源两种模态下的图像,并在图像中对需要识别的目标器件进行标注,并将标注数据分为训练集、验证集、测试集,再从两种模态的图像中随机裁剪出多张样本图像,以Efficientlite轻量级模型为Backbone,自适应特征融合结构为Head构建一个YOLOv5网络,以裁剪的样本图像作为训练数据,对YOLOv5网络进行训练,并用验证集的标注数据进行验证,用测试集的标注数据进行测试,最终得到基于YOLOv5网络的电子元

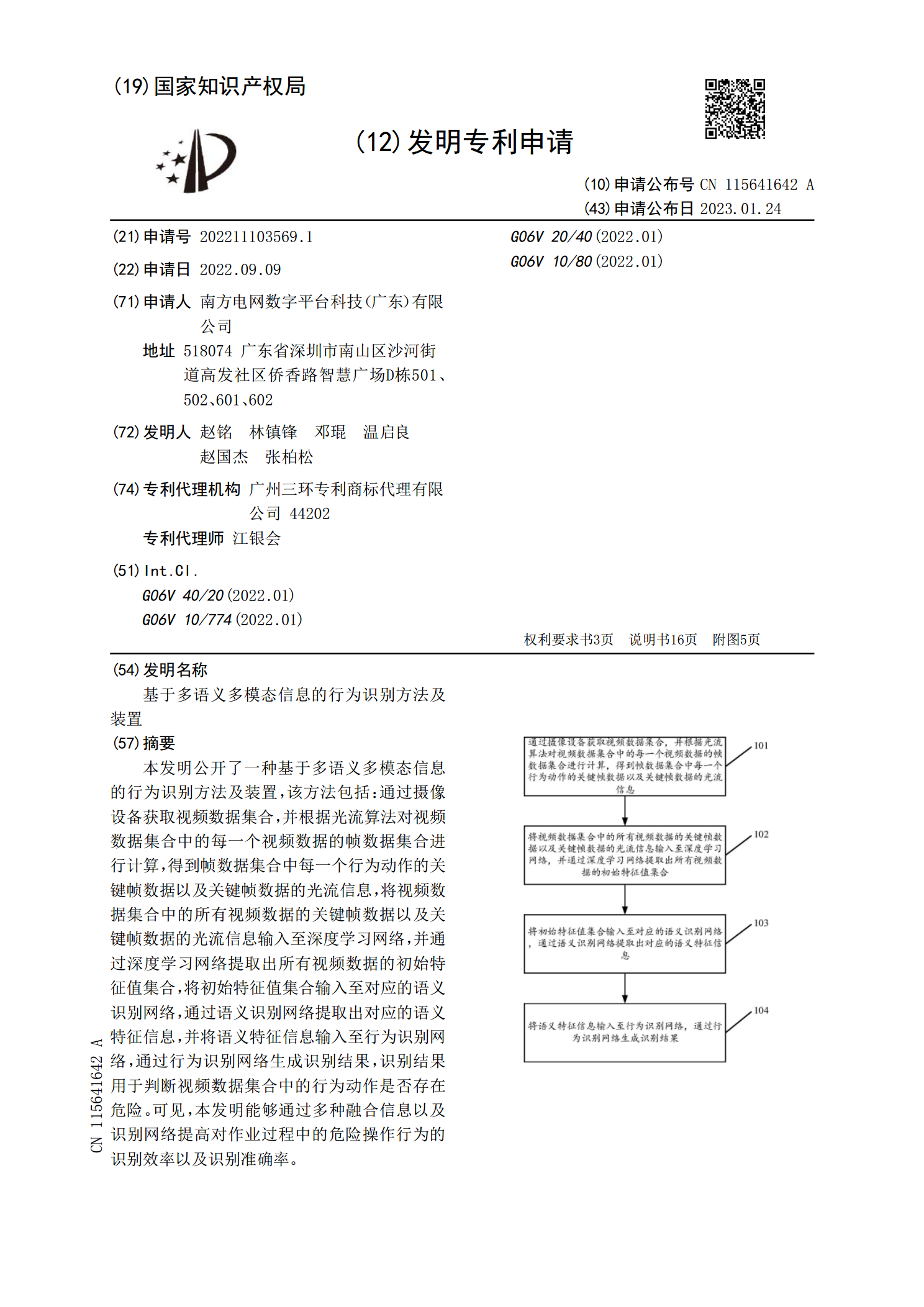

基于多语义多模态信息的行为识别方法及装置.pdf

本发明公开了一种基于多语义多模态信息的行为识别方法及装置,该方法包括:通过摄像设备获取视频数据集合,并根据光流算法对视频数据集合中的每一个视频数据的帧数据集合进行计算,得到帧数据集合中每一个行为动作的关键帧数据以及关键帧数据的光流信息,将视频数据集合中的所有视频数据的关键帧数据以及关键帧数据的光流信息输入至深度学习网络,并通过深度学习网络提取出所有视频数据的初始特征值集合,将初始特征值集合输入至对应的语义识别网络,通过语义识别网络提取出对应的语义特征信息,并将语义特征信息输入至行为识别网络,通过行为识别网

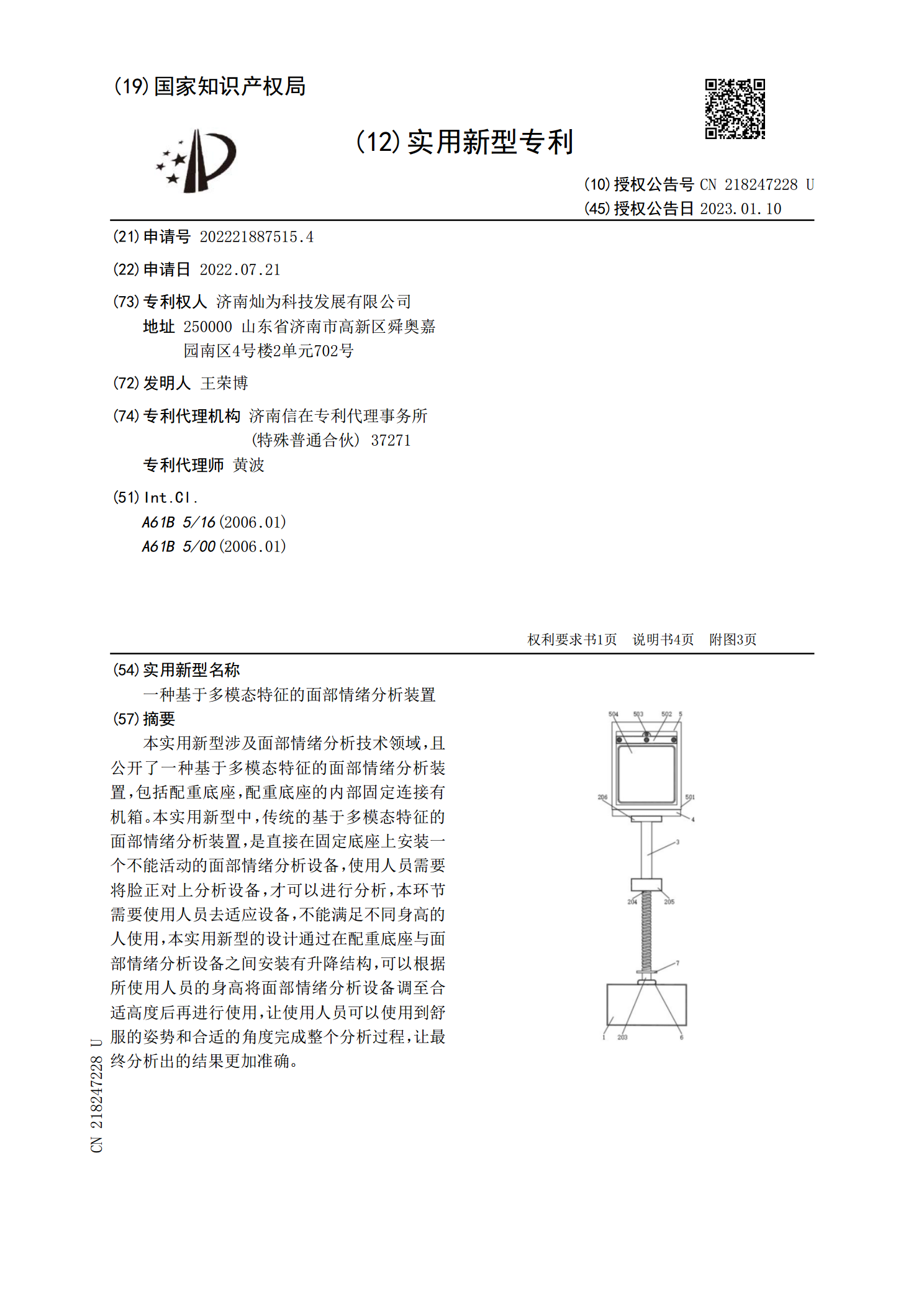

一种基于多模态特征的面部情绪分析装置.pdf

本实用新型涉及面部情绪分析技术领域,且公开了一种基于多模态特征的面部情绪分析装置,包括配重底座,配重底座的内部固定连接有机箱。本实用新型中,传统的基于多模态特征的面部情绪分析装置,是直接在固定底座上安装一个不能活动的面部情绪分析设备,使用人员需要将脸正对上分析设备,才可以进行分析,本环节需要使用人员去适应设备,不能满足不同身高的人使用,本实用新型的设计通过在配重底座与面部情绪分析设备之间安装有升降结构,可以根据所使用人员的身高将面部情绪分析设备调至合适高度后再进行使用,让使用人员可以使用到舒服的姿势和合适